Meta Reality Labs研究进展:EMG手腕交互、AR眼镜项目、3D扫描重建、虚拟化身驱动

AR/VR和神经接口研究将为未来的元宇宙奠定基础

(映维网Nweon 2022年10月12日)AR/VR和神经接口研究将为未来的元宇宙奠定基础,但眼见为实。对于这项由Reality Labs首席科学家迈克尔·亚伯拉什(Michael Abrash)领导的研究,大部分缓都需要数年的时间才能与消费者见面,而且不是每个人都能前往Reality Labs位于美国华盛顿州雷得蒙德的实验室亲身体验。

但证据就在产品之中。很快,你将能够亲自体验Quest Pro,并亲眼感受团队的部分研究成果,例如手部追踪和Pancake光学模组。所述两个项目都是从研究项目开始,而经过多年的实验室原型制作后,研究和产品团队作为一个整体终于能够将所述技术带到人们手里。

当然,团队将会继续为大家带来惊喜。Reality Labs正在发明一个全新的计算平台,一个围绕人、联结和关系构建的平台。在Meta Connect大会,亚伯拉什与首席执行官马克·扎克伯格分享了Reality Labs研究工作的最新进展。下面是具体的整理:

1. 下一代界面

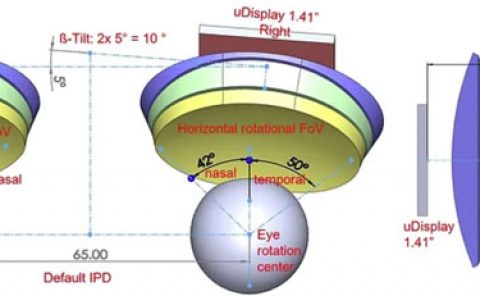

随着计算机在过去半个世纪的发展,个人电脑、笔记本电脑、平板电脑和智能手机应运而生,图形用户界面(GUI)在很大程度上定义了人们对数字世界的体验,为与之交互提供了全新的可能性。但当我们展望未来的AR眼镜和下一代VR头显时,我们看到了人机交互模式转变的必要性,而这将有助于新设备在一天中可能遇到的各种情况下发挥作用,同时允许你完全活在当下,专注于世界和周围的人和事。

对于新的输入方式(Mea押注于使用肌电图(EMG)进行基于手腕的交互),Meta对未来的展望需要能够与未来设备(尤其是AR眼镜)协同工作,从而感知和重建周围世界,并理解设备环境的个性化人工智能。有了这样的理解,人工智能将能够提出建议并采取相应行动,帮助你完成任务(理想情况下,你甚至可能不会注意到)。

将个性化人工智能与肌电图相结合: 肌电图将通过手腕的神经肌肉信号直接作为输入信号,这样你将拥有一个直观、几乎无摩擦的界面。这将是第一个真正以人为中心的界面,部分原因是它不会强迫人们学习一个困难的新型控制方案。相反,未来的设备将在你使用时学习并适应你。通过将机器学习和神经科学相结合,这种未来的界面将适用于不同的人员,同时通过一种称为“共同适应学习”的过程来解释他们在生理、大小等方面的差异。

在第一个演示内容中,你可以看到两个人使用基于手腕的肌电图开玩街机游戏。尽管他们都在游戏中使用相同的手势进行控制,但他们的手势执行方式略有不同。每次他们中的一个人执行手势时,算法都会适应解释这个特定人员的信号,所以每个人的自然手势都能快速可靠地识别出来。换句话说,随着时间的推移,系统能够更好地理解它们。协同适应学习的潜力不仅限于全手势,而且包括微手势。算法能够实时学习如何对肌电信号作出反应,即人们激活并发送到手上的肌电信号,只需手部的轻微动作。

系统可以解码手腕信号并将其转换为数字命令,从而识别用户决定执行的动作。这样你几乎不需要任何手部动作就可以将想要实现的动作传达给计算机。正如GUI标志着我们与计算机交互方式的巨大变化一样,EMG有潜力彻底改变我们与数字世界的交互方式:我们不仅可以做更多的事情,而且可以以我们想要的方式实现。在Connect大会,扎克伯格展示了一个可以通过运动神经元信号控制AR/VR设备的演示内容。

通过微妙的动作,你可以查看信息和进行拍照等等。手势越微妙,体验就越流畅和轻松。你不必掏出手机就可以完成操作。

这只是开始。真正的AR眼镜及其未来的界面有望解锁更加有用的交互,例如能够右键单击物理对象或位置以获取相关详细信息,更好地控制我们的设备而无需远离我们周围的世界,并从个性化的AI数字助理获取主动帮助。它们将共同为计算提供一种更加自然、以人为中心的方法,并可能为我们带来尚未想到的全新可能性。

这种未来的接口将真正改变我们的生活。一个特别鼓舞人心的例子是卡内基梅隆大学的NavCog项目:帮助视力受损者。

2. Reality Labs与卡内基梅隆大学合作的最新情况

Reality Labs两年前在Connect大会亮相了Project Aria。这个全新的研究项目旨在帮助团队构建第一代可穿戴AR设备。作为公告的一环,Meta宣布与卡内基梅隆大学及其Cognitive Assistance Laboratory实验室进行合作试点,共同构建博物馆和机场的3D地图。这种地图将具有多种应用,包括帮助视觉障碍患者更好地在室内导航,因为室内GPS信号通常无法到达。

今天,Reality Labs分享了这个项目的最新情况。

NavCog是由卡内基梅隆大学开发的智能手机应用,旨在帮助视觉障碍者更好地在室内环境中导航。卡内基梅隆大学的研究人员利用Project Aria绘制了匹兹堡国际机场的3D地图。然后,他们可以使用所述地图来训练在手机端运行的人工智能本地化模型。有了NavCog,人们可以知道自己在机场的什么地方,无需依赖机场周围的外部蓝牙信标。这是一个重要的发展,因为它表明了最终大规模部署NavCog的能力。

3. 将物理对象引入元宇宙

构建和操作3D对象的能力将在元宇宙中发挥关键作用。例如,想象一下在Horizon Home中展示一件珍贵的传家宝,或者能够在购买实物家具之前通过AR查看相应的效果。从零开始构建3D对象十分困难,使用物理对象作为模板可能更容易、更快速。但目前尚没有无缝的方法来实现这一目标,所以Reality Labs正在研究两种不同的技术来帮助解决这个问题。

第一种方法使用基于机器学习的神经辐射场(NeRFs),从不同角度拍摄的多个2D图像重建3D对象的外观。这种方法甚至可以再现对象的最精细细节。

尽管需要一定的处理时间,但结果令人印象深刻。纹理非常清晰,你可以拾取细腻的细节,如单根毛发。

第二种技术直接捕获几何图形和外观。团队使用一种称为Inverse Rendering反向渲染的不同技术来扫描一个对象,并将其数字孪生带到VR或AR。它能够动态响应VR环境中的照明。当你把它抛向空中,把它扔到墙上,或者把它弹离地面时,它的反应与实物的反应相同。

这两种技术暂时都无法实时运行,而且都有其局限性。但对于帮助人们轻松地将物理对象变成虚拟世界一部分的这一目标,它们都是重要的一步。

4. Codec Avatars更新

元宇宙中的Avatar将有多种风格。但如果你能真正忠实地再现自己,并用它与其他人互动呢?这将是迄今为止最强大的远程联结技术,并创造一种真正的社交体验。你会感觉自己就在那里,与其他人共在一起。在2021年,Reality Labs已经分享了全身Codec Avatars的早期进展。与你可能见过的其他高质量Avatar相比,Codec Avatars的区别在于,它们可以实时自动生成和驱动,匹配真实人员的外观和晕动。这意味着它们不限于预设动作,你可以实时控制他们。Reality Labs正继续开发这项技术,而在今天的大会中,他们表示现在已经可以改变Codec Avatars的虚拟服饰。

延伸阅读:Meta研究为Avatar设计合成逼真自然的穿衣服饰效果

延伸阅读:Meta探索为AR/VR构建高保真服饰效果的全身化身模型

延伸阅读:Meta研究用单个RGB-D传感器生成穿衣人体的高保真渲染图像

延伸阅读:Meta研究员探索AR/VR照片级真实感人体衣物穿着

延伸阅读:Meta提出Neural-GIF模型,为AR/VR模拟复杂衣服穿着效果

这意味着,未来你将能够无缝地从动作游戏会话跳到重要的商务会议,然后回到你的首空间环境,与朋友或家人在元宇宙中闲逛。

Meta同时展示了他们在Codec Avatars 2.0方面的最新进展。相关的研究项目旨在帮助合成的面部表情能够更真实地契合我们的身体形态。

团队令Codec Avatars 2.0更具表现力。除了看左、看右、看上、看下等简单的动作外,Reality Labs同时整合了人们相互交流和理解语气所依赖的非语言线索,比如扬眉、眯眼和睁大眼睛。通过更好地捕捉微妙的表情,Codec Avatars 2.0现在更加逼真和自然。你甚至可以控制Codec Avatars 2.0的照明,从而添加另一个维度的真实感。

Codec Avatars令人印象深刻,但它们需要很长时间才能生成,所以Reality正在研究一种更快的解决方案来供人们在未来使用:Instant Codec Avatars。

Instant Codec Avatars比Codec Avatars更快、更容易制作。扫描所需只是智能手机和像样的照明。以中性表情从多个角度扫描人脸大约30秒,然后在继续扫描时再花90秒做出各种表情即可。目前,在扫描过程之后生成一个Instant Codec Avatars需要几个小时,但团队正在努力减少总体处理时间。

Reality Labs在Instant Codec Avatars方面取得了非常大的进展。尽管它们的质量和逼真度不如Codec Avatars 2.0,但Instant Codec Avatars依然令人感觉逼真和富有表现力。另外,因为扫描所需的只是你的手机,所以它们更容易普及。

团队强调,这项工作依然处于研究阶段,它可能会,或者可能永远不会成为实际产品。不过,这只是未来五到十年技术发展方向的一瞥。Reality Labs评论道:“我们在过去数年的研究为未来的发展奠定了坚实的基础。”