Meta研究员探索AR/VR照片级真实感人体衣物穿着

动画化照片级真实感的穿衣化身

(映维网 2021年12月14日)可动画的照片级真实感数字人类是实现社交临场感的关键能力,并可以为远程联系开辟一条全新途径。长期以来,计算机图形学界一直在研究数字人类化身的构建问题。人体建模的早期研究是用最低限度的衣物来构建人体表面的低维几何表示。

不过,过往的研究大多只关注于几何体的建模,不能直接产生真实感的渲染输出。即使采用了基于神经网络的数据驱动方法,为照片级真实感衣物人体制作动画依然是一个远未解决的问题。

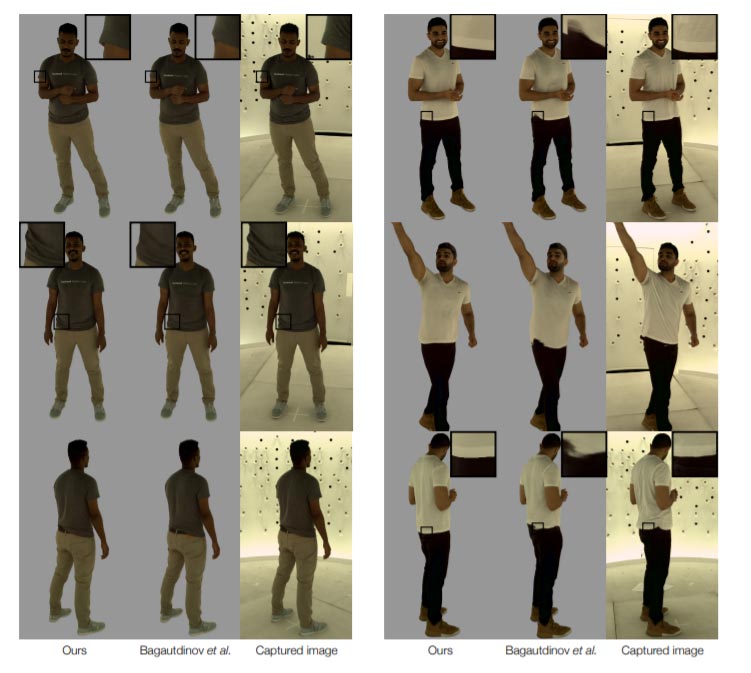

在名为《Modeling Clothing as a Separate Layer for an Animatable Human Avatar》的论文中,卡内基梅隆大学和Facebook Reality Labs Reaserch的研究人员尝试通过可轻松访问的驱动信号来动画化照片级真实感的穿衣化身,例如三维身体姿势和面部关键点。

利用诸如Variational Autoencoders(VAE)这样的深度生成模型来同时建模几何体和纹理已证明是创建照片级真实感人脸化身的有效方法。最近业界已经扩展了这种方法,以身体姿势和面部关键点为条件,通过VAE对全身化身进行建模。

由于所述条件信号不能唯一地描述所有的身体状态,如头发和注视点,VAE隐代码用于区分多个可能的身体阶段。另外,为了减少驱动信号和隐码之间的伪相关,必须对驱动信号和隐码进行分离。

......(全文 2059 字,剩余 1602 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限