实现高质量AR/VR全息显示,斯坦福大学提出神经网络参数化平面到多平面波传播模型

一个神经网络参数化的平面到多平面波传播模型

(映维网 2022年01月10日)增强现实和虚拟现实系统能够带来前所未有的沉浸式用户体验,但当前AR/VR平台的光引擎在峰值亮度、功率效率、设备形状参数、对感知重要焦点线索的支持、以及校正用户视觉像差能力等方面都受到不同程度的限制。所以,学界和业界正在积极探索各种解决方案。

对于由斯坦福大学博士后研究员Yifan Peng和电子工程副教授戈登·韦茨坦(Gordon Wetzstein)等人组成的团队而言,其相信全息近眼显示器有望解决上述的一系列问题。

继在SIGGRAPH 2020发表了一份名为《Neural Holography》的研究论文后,他们又在今年的大会介绍了最新的研究成果:《Neural 3D holography: learning accurate wave propagation models for 3D holographic virtual and augmented reality displays》。

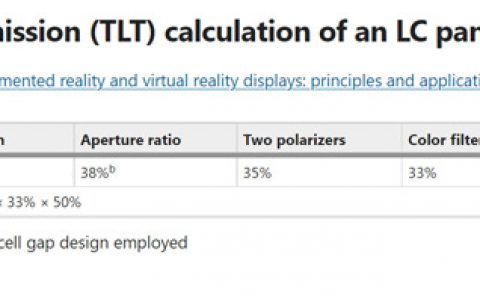

简单来说,《Neural Holography》主要介绍了一个能够以1080p分辨率实时生成全彩高质量全息图的CGH算法。《Neural 3D holography: learning accurate wave propagation models for 3D holographic virtual and augmented reality displays》则提出了一个神经网络参数化的平面到多平面波传播模型,其能够缩小物理和模拟之间的差距,并实现高质量的3D计算机生成全息图。

全息近眼显示器通常是利用单个空间光调制器(SLM)来合成3D强度分布,并通过明亮且节能的激光器产生相干照明。全息术的基本原理在70多年前就已经发展起来,但高质量的全息图一直以来都是通过光记录技术实现。以高效利用SLM来生成高质量数字全息图的主要挑战是用于计算机生成全息(CGH)的算法。传统的CGH算法依赖于模拟的波传播模型,但由于无法充分代表近眼显示器的物理光学,所以可实现的质量存在严重的限制。

......(全文 2767 字,剩余 2202 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限