微软专利使用IMU数据更新MR叠加图像,最小化动显延迟影响

使用IMU数据来最小化延迟影响

(映维网Nweon 2022年06月13日)如果大家有关注微软的专利探索,这家公司曾提出一种集成式摄像头/系统摄像头+分离式摄像头/外部摄像头的系统理念。其中,集成式摄像头/系统摄像头是指物理集成到头显的摄像;分离式摄像头/外部摄像头则是指与头显分离的摄像头。

例如在一个的场景中,可以将分离式摄像头捆绑或以其他方式放置在用户的胸部。在另一个场景中,分离式摄像头可以不放置在用户的身体上,而是由用户握持或者安装在自拍杆或另一种类型的延长杆上。

集成式摄像头+分离式摄像头的设置可以提升头显的扫描范围和质量,优化全息图的放置和生成。但显然,对于这种图像合并和叠加,系统需要对齐两个摄像头的内容,并实现快速目标捕获。

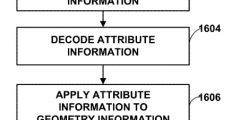

在名为“Low motion to photon latency rapid target acquisition”的专利申请中,微软介绍了一种使用IMU数据更新叠加图像内容的位置,以反映摄像头位置的后续变化,从而最小化延迟影响。

......(全文 3153 字,剩余 2797 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限