谷歌CVPR2021:AR/VR关联性研究成果

或能用于增强现实/虚拟现实的部分论文

(映维网 2021年06月24日)2021年计算机视觉和模式识别大会(Conference on Computer Vision and Pattern Recognition;CVPR)正在如火如荼地进行中,并已经公布了收录的论文。

对于今年的CVPR大会,谷歌人工智能团队共有70多份论文获得了收录,并介绍了在计算机视觉的一系列研究,包括对象映射与渲染,3D人类姿态生成,语义分割和透明对象关键点估计等等。

下面映维网整理了或能应用于增强现实/虚拟现实的部分论文及相关摘要:

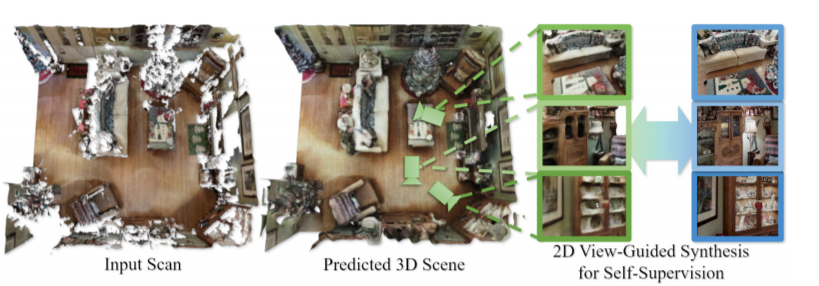

1. SPSG: Self-Supervised Photometric Scene Generation from RGB-D Scans

SPSG可以以自监督方式学习推断未观察到的场景几何和颜色,从而根据RGB-D扫描观察中生成高质量彩色三维场景模型。这种自监督方法用更完整的版本来关联不完整的RGB-D扫描,从而同时修复几何和颜色。值得注意的是,所述方法不依赖3D重建损失来为3D几何和颜色重建提供信息,而是建议在2D渲染操作对抗性和感知损失,以实现场景的高分辨率、高质量彩色重建。这利用了来自单个原始RGB-D帧的高分辨率、自一致性信号。所以,通过直接利用2D信号来为3D场景生成提供信息,团队提出的方法能够生成3D场景的高质量彩色重建。

......(全文 3423 字,剩余 3017 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限