港大联合团队提出EgoHumanoid,用PICO提升机器人泛化能力

用PICO提升机器人泛化能力

(映维网Nweon 2026年02月17日)想象一下,一个身高1.3米的人形机器人,不仅能像人一样走路,还能在陌生的卧室里准确放置枕头,在便利店中帮忙往购物车里放玩具,甚至在户外花园里将垃圾投入垃圾桶。这听起来像是科幻电影的场景,但一项最新的研究正将其变为现实。

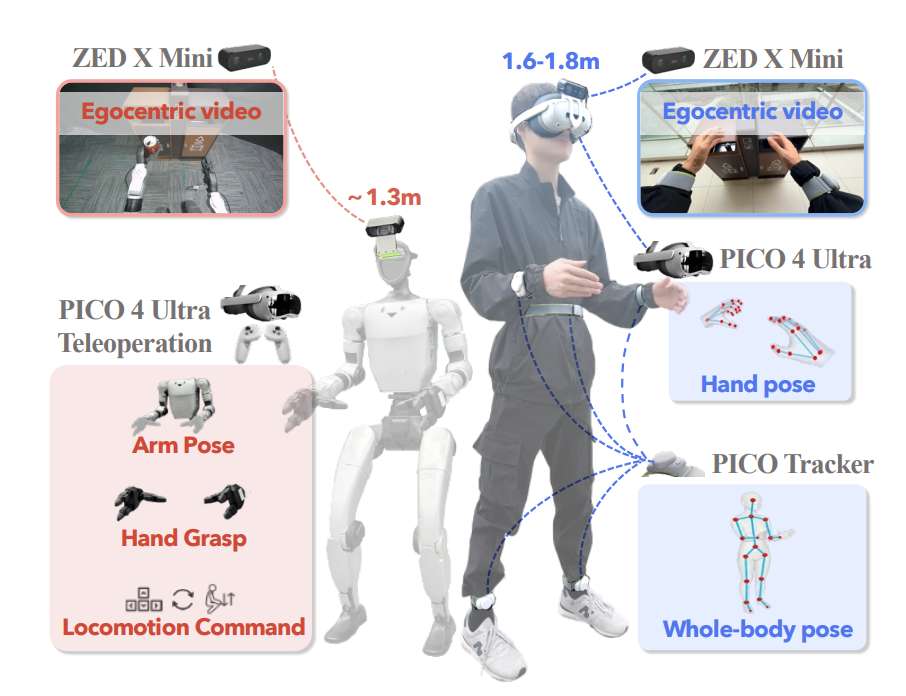

香港大学、上海创新研究院、北京航空航天大学及Kinetix AI的联合研究团队提出了EgoHumanoid框架,使用PICO VR头显在室内和室外环境中低成本、无约束地记录人类演示,并系统性地探索了如何利用人类日常生活中的“自中心”演示视频来训练人形机器人完成复杂的全身移动操作任务。

传统上,训练人形机器人需要研究人员通过远程操作,在受限的实验室环境中一遍遍演示。这种方法不仅成本高昂、操作复杂,更关键的是,由于硬件和安全限制,机器人很难在真实的家庭、商店、公园等多样化场景中进行数据收集,导致其一旦离开熟悉的环境就“水土不服”,泛化能力极差。

......(全文 851 字,剩余 494 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限