清华大学等团队发布EyeNavGS 6DoF导航数据集及记录回放软件

六自由度导航数据集

(映维网Nweon 2025年09月26日)3DGS是一种新兴的媒体表示技术,能够高保真地重建真实世界的3D场景,并支持在虚拟现实中进行六自由度导航。然而,开发和评估支持3DGS的应用程序以及优化其渲染性能,都需要真实的用户导航数据。目前,对于真实世界场景的光线级真实感3DGS重建,这类数据尚不可用。

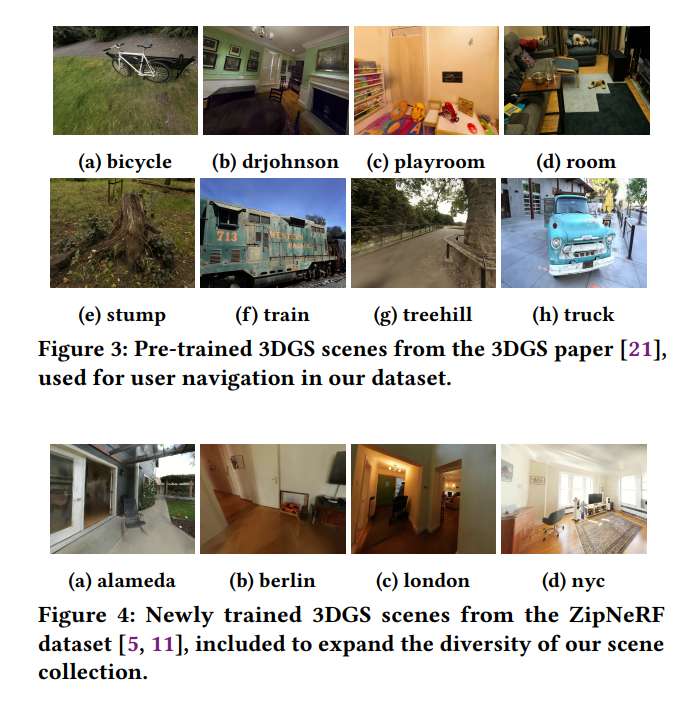

所以,美国罗格斯大学和台湾清华大学团队介绍了EyeNavGS,这是首个公开可用的六自由度导航数据集,包含46名参与者探索十二个多样化真实世界3DGS场景的轨迹。数据集在两个地点收集,使用Meta Quest Pro头显,记录了在自由导航期间每个渲染帧的头部姿态和眼动注视数据。对于十二个场景中的每一个,研究人员都进行了细致的场景初始化以校正场景倾斜和尺度,确保感知舒适的VR体验。

团队同时发布了开源的SIBR查看器软件分支,提供记录和回放功能,以及一套用于数据处理、转换和可视化的实用工具。EyeNavGS数据集及其附带的软件工具为推进六自由度视口预测、自适应流传输、3D显著性以及3DGS场景的注视点渲染等方面的研究提供了宝贵资源。

......(全文 3241 字,剩余 2846 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限