Meta Connect 汇总:Quest Pro,App生态、MR办公、AR探索、前瞻研究等

查看引用/信息源请点击:映维网Nweon

Quest Pro

(映维网Nweon 2022年10月12日)在过去的一年里,Meta已经陆续分享了关于Project Cambria的细节,而这家公司终于在今天的Connect大会中正式揭晓了这款设备Quest Pro,以及一系列关于Quest 内容生态、商业应用、AR前瞻研究等信息,以下是映维网的汇总整理。

1. Quest Pro头显

Quest Pro是Meta高端设备系列的第一款产品,并搭载了一系列的创新功能,如可以提供全彩混合现实体验的高分辨率传感器,高清LCD显示屏,全新时尚的设计,以及眼动追踪和面部追踪。这款设备将于10月25日以1499.99美元的价格发售,包装盒含有Quest Pro头显、Touch Pro控制器、触控笔、部分挡光器和充电座。

Quest Pro是首款采用高通骁龙XR2+ Gen 1平台的设备。全新的骁龙XR2+ Gen 1经过了专门优化,散热更好,性能显著提高,实现了50%持续功率(sustained power)提升和30%散热性能提升。每台Quest Pro都配有12GB内存、256GB存储空间和10个高分辨率传感器(内5个,外部5个),从而有助于增强各种沉浸式体验。

Quess Pro采用Pancake光学模组取代了Qust 2中的菲涅尔透镜。Pancake光学元件可以将光线折叠数次,在提供清晰视觉效果的同时,光学模块的深度可以减少40%。另外,两个LCD显示器使用局部调光和量子点技术,从而提供更丰富和更生动的颜色。其中,定制的局部调光技术由专门的背光硬件和配套的软件算法支持,可以独立控制500多个单独的LED区块,并将显示器的对比度提高75%。

Quest Pro的每英寸像素数比Quest2多37%,每度像素数比Quest 2多10%,这使得从阅读文本到玩游戏的画面效果看起来都更好。同时,中心视图的全场视觉清晰度提高了25%,外围区域提高了50%,色域比Quest 2大1.3倍。

Quest Pro拥有全新的传感器架构,配备高分辨率前置摄像头,可捕获4倍于Quest 2外置摄像头的像素,从而实现高清的全彩混合现实体验。

Quest Pro的混合现实允许你以逼真的方式将物理环境与虚拟元素结合起来,从而增强社交、生产力和协作能力。你可以建立一个大型虚拟工作区,并摆放多个屏幕,而不是局限于办公桌尺寸。你同时可以在Immersed等生产力应用中使用物理键盘和鼠标。或者,如果你是一名家具设计师,你可以使用Arkio和Gravity Sketch与同时实时协作创建详细的3D模型,然后看看它们在实际客厅中的效果。借助Presence Platform的场景理解和共享空间锚定,开发者可以构建与物理空间交互的虚拟对象。

2. Touch Pro控制器

Quest Pro的控制器是全新的Touch Pro控制器。它们的一个主要新功能是:每个控制器内置了三个传感器,可独立于头显追踪其在3D空间中的位置,从而为你提供全方位的360度运动范围。以这种方式,它确保了对所有VR应用的稳定追踪。

Meta表示,这款Pro控制器经过了重新设计,更加平衡,更加符合人体工学,感觉就像是手的自然延伸。它们同时配备了升级的触觉反馈,利用全新的TruTouch触觉系统提供更广泛、更精确的反馈范围。当然,Pro控制器包含可充电电池。利用附带的充电座和45W USB-C电源适配器,你可以随时为头显和控制器充电。

另外,Quest 2用户可以在今年年底以299.99美元的价格单独购买Touch Pro控制器。

3. Quest Pro配件

除了新的头显和控制器外,你同时可以预订各种相关配件,从而提升你的Quest Pro体验。

Meta Quest Pro Compact Dock(售价79.99美元,10月25日发售)是一款二合一的充电座,可为Touch Pro控制器和任何USB-C插口的Quest头显充电。它包括一个45W USB-C电源适配器。

Meta Quest Pro Full Light Blocker全遮挡器(售价49.99美元,于11月22日发售)是一款完全遮光的面部界面,可轻松接到Quest Pro并为你带来更身临其境的体验。另外还有Quest Pro VR Earphones耳机(售价49.99美元,10月25日发售)和Meta Quest Pro Carry Case from Incase便携包(售价119.95美元,10月25日发售)。

4. Quest Store营收

在今天凌晨的Meta Connect 2022大会上,扎克伯格开场就分享了Quest App Store的喜人成绩,Quest 商店三分之一的App实现了百万美元营收,其中55款App实现了500万美元营收(是一年前的两倍),33款App实现了1000万美元营收。

开发者取得成功的速度越来越快。例如,《BONELAB》在发行不到一个小时的时间内就达到了100万美元,创下了Meta Quest历史纪录,但Stress Level Zero并不是唯一一家成功的开发者。《Zenith: The Last City》和《生化危机4》在不到24小时内就达到100万+美元的营收;《Blade & Sorcery: Nomad》在两天内达到了这个目标,而基于“行尸走肉”的《The Walking Dead:Saints&Sinners》单单在Meta Quest平台的营收就超过了5千万美元,几乎是所有其他平台营收的两倍。

当然,构建健康可持续的VR生态系统的一环是确保开发者有多种方式触及受众。自2021年推出以来,审核标准更宽的App Lab已经发展到2000多个应用。诸如《Smash Drums》,《Ancient Dungeon》和《Puzzling Places》等优秀作品都是从App Lab开始。

Meta同时看到了用户行为的转变:当Quest 2发布时,用户在VR中的大部分时间都是独自度过。但如今,他们的大部分时间都用到了多人游戏和社交应用,涉及探索、游戏、学习新爱好等等。

5. Quest 新IP游戏:《钢铁侠 VR》

Meta宣布来自漫威的《钢铁侠 VR》将于11月3日登陆Meta Quest 2。这款基于“钢铁侠”宇宙的作品是由Camouflaj Teams,索尼互娱,以及漫威游戏(Marvel Games)共同研发而成。值得一提的是,著名美术、概念设计师阿迪·格兰诺夫(Adi Granov)为游戏构思了相关的盔甲,将经典的漫画美学与超现代风格融为一体,从而为玩家带来了富有沉浸感的独特VR体验。

作为故事背景,经历数年超级英雄生涯后,世界知名的钢铁侠托尼·史塔克突然遭到神秘人物幽灵的袭击。这名反派改造了史塔克工业的旧武器,并用以对付钢铁侠。。

6. Quest 云游戏探索:Xbox

在Connect大会期间,微软首席执行官萨提亚·纳德拉宣布Xbox Cloud Gaming(Beta)即将登陆Quest Store,但具体日期未确定。

Xbox Cloud Gaming这项云游戏服务能够将数百款高质量游戏流式传输到一系列设备,而这将会包括Meta Quest 2。当Xbox Cloud Gaming在正式支持Quest时,你同时可以启用巨大的2D屏幕,并利用Xbox控制器畅玩Xbox Game Pass Ultimate内容库中的主机内容。

7. VR游戏团队买买买

尽管针对健身应用《Supernatural》开发商Within的收购受挫,但这家公司依然在继续自己的买买买。 在本届大会,Meta宣布已经收购《钢铁侠 VR》的开发商Camouflaj Teams,《Wilson’s Heart》和《Path of the Warrior》背后的开发商Twisted Pixel,以及《生化危机 4》背后的开发团队Armature Studio。

值得一提的是,根据美国联邦贸易委员会(FCC)早前的揭秘,Twisted Pixel的收购案早已在2021年11月完成。下面是FCC公布的Meta收购的VR内容工作室。

- 2020年1月,收购VR游戏《Asgard’s Wrath》背后的工作室Sanzaru Games

- 2020年5月,收购VR游戏《Lone Echo II》背后的工作室Ready at Dawn - 2021年4月,收购VR游戏《Onward》背后的工作室Downpour Interactive

- 2021年5月,收购VR游戏《Population One》背后的工作室BigBox VR

- 2021年6月,收购了元宇宙游戏平台Crayta背后的Unit2 Games

- 2021年11月,收购了VR游戏《 Wilson’s Heart》背后的工作室Twisted Pixel

8. Quest Pro混合现实办公

Quest Pro是为建筑师、工程师、建设者、创造者和设计师等希望通过VR增强其工作流程并增强其创造力的人而设计。从长远来看,Meta希望所述设备能够解锁一系列的新方法,并改进不同行业和企业的工作体验。

在Connect大会中,微软宣布与Meta达成进一步的合作,把Mesh for Microsoft Teams,Microsoft 365应用,Microsoft Intune和Azure Active Directory带到Quest系列头显。这家公司指出,作为一家平台企业,微软提高工作效率和协作的方法是确保其提供的软件体验能够帮助所有用户受益。本着这种精神,他们宣布与Meta达成了进一步的合作:

Mesh for Microsoft Teams将支持Meta Quest设备这个工具旨在将Microsoft Mesh的混合现实功能与Microsoft Teams的生产工具相结合。

Microsoft 365应用程序将登陆Meta Quest设备,从而允许人们能够在VR中与Word、Excel、PowerPoint、Outlook和SharePoint等进行交互。未来,Windows 365将同样登陆Meta Quest设备并允许流式传输Windows Cloud PC,包括你的个性化应用、内容和设置。

Microsoft Intune和Azure Active Directory将支持Quest Pro和Quest 2,这样IT管理员就能够通过Meta的Quest for Business订阅为用户提供服务,并将PC和移动设备的安全和管理选项带到VR。

微软评论道:“这一合作伙伴关系补充了我们对HoloLens的承诺,我们非常高兴能够继续推进我们的混合现实设备路线图,并以我们的云第一方法为先导,以Windows和Microsoft 365为先导。所有这一切都推动了我们建立负责任的元宇宙基础的努力,而安全、合规和企业级经验是我们如何继续为未来办公开启新可能性的基础。”

扎克伯格同时邀请了埃森哲主席兼首席执行官朱莉·斯威特(Julie Sweet)。她透露,这家全球专业服务公司正在与Meta和微软合作,共同帮助世界各地的企业创造新的体验,从而加速未来办公的到来。

在2021年,埃森哲部署了6万台Quest 2头显。这改变了员工的入职流程,他们在与微软共同创建的Nth Floor虚拟园区中欢迎了15万人。埃森哲将在未来一年内继续与Meta和微软合作,帮助企业使用VR改变吸引员工、与客户互动或在元宇宙中创建产品和服务的方式。

微软和埃森哲并不是唯一对未来元宇宙办公持乐观态度的公司。在过去的一年里,Meta与数十个合作伙伴进行了合作,为希望在VR及其他领域完成任务的人们创造了新的体验。

例如,Autodesk正在更新其协作设计审查应用程序,从而利用Quest Pro提供的新功能。这将为建筑师和设计师提供一种沉浸式查看3D模型的全新方式。

Meta同时与Adobe合作,帮助人们在VR中完成更多工作。在2023年,Adobe面向专业3D创造者、设计师和艺术家的Substance 3D应用程序将登陆Quest Pro和Quest2。另外,Adobe将把Adobe Acrobat带到Quest Store,从而实现PDF文档的查看、编辑和协作。

9. MR开发工具Presence Platform大更新,释放Quest Pro混合现实潜力

Meta在2021年的Connect大会亮相了Presence Platform。这个拥有大量机器感知和人工智能功能的工具集旨在帮助你构建逼真的混合现实、交互和语音体验,从而在用户的物理世界中无缝融合虚拟内容。对于今天发布Quest Pro,它将能解锁全彩混合现实。

9.1 Movement SDK

Meta发布了Presence Platform的最新补充Movement SDK。Movement SDK由眼睛追踪、面部追踪和三点身体追踪功能组成,而它们将有助于解锁全新的临场维度。Movement SDK允许Avatar使用Quest Pro的朝内传感器实时模拟面部动作。现在,开发者可以通过眼动追踪和面部追踪实现栩栩如生的Avatar,从而令虚拟角色可以看起来和感觉更像真人。值得一提的是,这是驱动Horizon Worlds和Holizon Workrooms中的Avatar的相同底层技术。

9.2 眼动追踪和面部追踪

Movement SDK包括Quest Pro新开发的眼动追踪和面部追踪功能。头显内有五个指向面部的红外传感器:三个指向眼睛和上半脸,两个指向下半脸。面部追踪由机器学习模型驱动,可允许Quest Pro检测各种面部运动。

Movement SDK输出的抽象面部运动数据由基于面部动作编码系统Facial Action Coding System(FACS)的线性混合形状表示。FACS是一系列0到1的值,与一组通用面部运动相对应,例如皱眉。在将信号从Face Tracking API 映射到自己的角色rig时,开发者可以轻松保留用户原始动作的语义含义。

随着Movement SDK的引入,Meta现在能够支持第三方角色具现的社交临在。例如,团队创建了一个称之为Aura的外星人角色。她可以眨眼,左右移动嘴巴等等。

正如你在上面视频所示,Aura的面部和眼部动作可用于社交活动,并展示了机器学习驱动的高分辨率角色的潜力。Aura将于本月中下旬作为可下载示例托管至GitHub。你可以自由查看幕后情况,看看Meta是如何实现重定目标和rig映射。届时可注意相关的文档,它将为映射到不同的具体角色提供指导和最佳实践。

除了社交临在之外,开发者同时可以估计某人在VR中的视线作为输入,从而构建全新的交互和体验,类似于手动追踪。这意味着人们可以根据自己的视线所见来与虚拟内容进行交互。

9.3 Body Tracking API

Movement SDK同时包括Body Tracking API,后者可根据控制器或手相对于头显的位置来使用三点追踪。肢体语言是社交体验的一个重要组成缓解。若看到角色的身体动作不符合人类实际,这将会完全打破沉浸感。所以,Meta使用了大量真实人体运动数据集来学习和纠正简单反向运动学(IK)方法常见的错误。

Body Tracking API可以在玩家使用控制器或仅使用裸手的情况下工作,并且在这两种情况下都提供了完整的模拟上身骨骼。它同时可以自动处理玩家放下控制器并开始使用裸手的情况,无需开发者进行任何额外的逻辑处理。

Body Tracking API适用于Quest Pro和 Quest2,并会支持未来的Meta Quess设备。另外,未来几年的Body Tracking API优化将通过相同的API实现,因此你将能继续从Meta获得最佳的身体追踪技术,无需切换到不同的界面。

9.4. 混合现实与场景理解

Meta早前已经发布了场景理解功能,并分享了混合现实和Presence Platform的可能性,包括Quest 2和Quest Pro。

使用Presence Platform的混合现实功能,Arkio正在带来一种更具沉浸感和影响力的体验,并且远远超出了平板屏幕的可能性。

场景理解功能允许开发人员创建适应用户个人空间的混合现实体验,并大大增加沉浸感。数字内容可以与物理世界交互,支持遮挡、碰撞和导航网格等等,而所有这一切都提高了混合现实中的沉浸感和真实感。

以Sir Aphino的以上场景为例,它展示了场景理解如何在虚拟角色、物理墙壁和天花板位置,以及玩家房间内的其他对象之间实现交互的基本示例。

下面是Meta今天发布的全新混合现实功能Demo,它将帮助开发者以全新的方式融合物理世界和虚拟世界。

9.5 全彩透视

借助Quest Pro的先进传感器和4倍像素数,开发人员现在可以构建允许人们在参与虚拟世界的同时,又保持物理空间中完整、丰富的色彩的体验。Meta对高级立体视觉算法的投资提供了更高质量和更为舒适的Passthrough体验,在特写和房间规模混合现实场景中可以实现更好的深度感知和更少的视觉失真。

生产力应用程序可以将巨大的虚拟监视器与键盘和鼠标等物理工具相结合。对于Immersed,用户可以生成多达五个虚拟屏幕,在虚拟桌面上无干扰地工作或与他人协作。

利用全彩Passthrough,开发者现在可以进一步指出用户探索、体验和参与混合现实。最棒的是,使用Passthrough构建的 Quest 2应用程序支持Quest Pro。

9.6 Shared Spatial Anchors

Meta在2021年发布了允许开发人员在物理世界中锚定虚拟内容的Spatial Anchors。现在,Meta计划带来一个令人兴奋的升级版本:允许开发者构建本地多人游戏体验的Shared Spatial Anchors。

Shared Spatial Anchors允许开发人员为多个用户创建一个共享的锁定世界参考帧,从而构建本地多玩家(共同定位)体验。例如,开发人员可以构建两人或更多人可以在同一物理空间中协作或一起游玩,并与相同虚拟内容进行交互的游戏和应用。

在Connect大会,Meta展示了Magic Room的预览,这是他们为利用Shared Spatial Anchors的Horizon Workroom构建的混合现实体验。Magic Room允许任何形式的组合在共一空间协作,例如有人远程有人置身在物理空间。

10. Reality Labs研究探索:EMG手腕交互

但当我们展望未来的AR眼镜和下一代VR头显时,我们看到了人机交互模式转变的必要性,而这将有助于新设备在一天中可能遇到的各种情况下发挥作用,同时允许你完全活在当下,专注于世界和周围的人和事。

对于新的输入方式(Mea押注于使用肌电图(EMG)进行基于手腕的交互),Meta对未来的展望需要能够与未来设备(尤其是AR眼镜)协同工作,从而感知和重建周围世界,并理解设备环境的个性化人工智能。有了这样的理解,人工智能将能够提出建议并采取相应行动,帮助你完成任务(理想情况下,你甚至可能不会注意到)。

将个性化人工智能与肌电图相结合: 肌电图将通过手腕的神经肌肉信号直接作为输入信号,这样你将拥有一个直观、几乎无摩擦的界面。这将是第一个真正以人为中心的界面,部分原因是它不会强迫人们学习一个困难的新型控制方案。相反,未来的设备将在你使用时学习并适应你。通过将机器学习和神经科学相结合,这种未来的界面将适用于不同的人员,同时通过一种称为“共同适应学习”的过程来解释他们在生理、大小等方面的差异。

在第一个演示内容中,你可以看到两个人使用基于手腕的肌电图开玩街机游戏。尽管他们都在游戏中使用相同的手势进行控制,但他们的手势执行方式略有不同。每次他们中的一个人执行手势时,算法都会适应解释这个特定人员的信号,所以每个人的自然手势都能快速可靠地识别出来。换句话说,随着时间的推移,系统能够更好地理解它们。协同适应学习的潜力不仅限于全手势,而且包括微手势。算法能够实时学习如何对肌电信号作出反应,即人们激活并发送到手上的肌电信号,只需手部的轻微动作。

系统可以解码手腕信号并将其转换为数字命令,从而识别用户决定执行的动作。这样你几乎不需要任何手部动作就可以将想要实现的动作传达给计算机。正如GUI标志着我们与计算机交互方式的巨大变化一样,EMG有潜力彻底改变我们与数字世界的交互方式:我们不仅可以做更多的事情,而且可以以我们想要的方式实现。在Connect大会,扎克伯格展示了一个可以通过运动神经元信号控制AR/VR设备的演示内容。

通过微妙的动作,你可以查看信息和进行拍照等等。手势越微妙,体验就越流畅和轻松。你不必掏出手机就可以完成操作。

这只是开始。真正的AR眼镜及其未来的界面有望解锁更加有用的交互,例如能够右键单击物理对象或位置以获取相关详细信息,更好地控制我们的设备而无需远离我们周围的世界,并从个性化的AI数字助理获取主动帮助。它们将共同为计算提供一种更加自然、以人为中心的方法,并可能为我们带来尚未想到的全新可能性。

这种未来的接口将真正改变我们的生活。一个特别鼓舞人心的例子是卡内基梅隆大学的NavCog项目:帮助视力受损者。

11. Reality Labs研究探索:卡内基梅隆大学合作项目NavCog

Reality Labs两年前在Connect大会亮相了Project Aria。这个全新的研究项目旨在帮助团队构建第一代可穿戴AR设备。作为公告的一环,Meta宣布与卡内基梅隆大学及其Cognitive Assistance Laboratory实验室进行合作试点,共同构建博物馆和机场的3D地图。这种地图将具有多种应用,包括帮助视觉障碍患者更好地在室内导航,因为室内GPS信号通常无法到达。

今天,Reality Labs分享了这个项目的最新情况。

NavCog是由卡内基梅隆大学开发的智能手机应用,旨在帮助视觉障碍者更好地在室内环境中导航。卡内基梅隆大学的研究人员利用Project Aria绘制了匹兹堡国际机场的3D地图。然后,他们可以使用所述地图来训练在手机端运行的人工智能本地化模型。有了NavCog,人们可以知道自己在机场的什么地方,无需依赖机场周围的外部蓝牙信标。这是一个重要的发展,因为它表明了最终大规模部署NavCog的能力。

12. Reality Labs研究探索:从物理对象构建3D对象

构建和操作3D对象的能力将在元宇宙中发挥关键作用。例如,想象一下在Horizon Home中展示一件珍贵的传家宝,或者能够在购买实物家具之前通过AR查看相应的效果。从零开始构建3D对象十分困难,使用物理对象作为模板可能更容易、更快速。但目前尚没有无缝的方法来实现这一目标,所以Reality Labs正在研究两种不同的技术来帮助解决这个问题。

第一种方法使用基于机器学习的神经辐射场(NeRFs),从不同角度拍摄的多个2D图像重建3D对象的外观。这种方法甚至可以再现对象的最精细细节。

尽管需要一定的处理时间,但结果令人印象深刻。纹理非常清晰,你可以拾取细腻的细节,如单根毛发。

第二种技术直接捕获几何图形和外观。团队使用一种称为Inverse Rendering反向渲染的不同技术来扫描一个对象,并将其数字孪生带到VR或AR。它能够动态响应VR环境中的照明。当你把它抛向空中,把它扔到墙上,或者把它弹离地面时,它的反应与实物的反应相同。

这两种技术暂时都无法实时运行,而且都有其局限性。但对于帮助人们轻松地将物理对象变成虚拟世界一部分的这一目标,它们都是重要的一步。

13. Reality Labs研究探索:Codec Avatars 2.0

在2021年,Reality Labs已经分享了全身Codec Avatars的早期进展。与你可能见过的其他高质量Avatar相比,Codec Avatars的区别在于,它们可以实时自动生成和驱动,匹配真实人员的外观和晕动。这意味着它们不限于预设动作,你可以实时控制他们。Reality Labs正继续开发这项技术,而在今天的大会中,他们表示现在已经可以改变Codec Avatars的虚拟服饰。

这意味着,未来你将能够无缝地从动作游戏会话跳到重要的商务会议,然后回到你的首空间环境,与朋友或家人在元宇宙中闲逛。

Meta同时展示了他们在Codec Avatars 2.0方面的最新进展。相关的研究项目旨在帮助合成的面部表情能够更真实地契合我们的身体形态。

团队令Codec Avatars 2.0更具表现力。除了看左、看右、看上、看下等简单的动作外,Reality Labs同时整合了人们相互交流和理解语气所依赖的非语言线索,比如扬眉、眯眼和睁大眼睛。通过更好地捕捉微妙的表情,Codec Avatars 2.0现在更加逼真和自然。你甚至可以控制Codec Avatars 2.0的照明,从而添加另一个维度的真实感。

Codec Avatars令人印象深刻,但它们需要很长时间才能生成,所以Reality正在研究一种更快的解决方案来供人们在未来使用:Instant Codec Avatars。

14. Reality Labs研究探索:Instant Codec Avatars

Instant Codec Avatars比Codec Avatars更快、更容易制作。扫描所需只是智能手机和像样的照明。以中性表情从多个角度扫描人脸大约30秒,然后在继续扫描时再花90秒做出各种表情即可。目前,在扫描过程之后生成一个Instant Codec Avatars需要几个小时,但团队正在努力减少总体处理时间。

Reality Labs在Instant Codec Avatars方面取得了非常大的进展。尽管它们的质量和逼真度不如Codec Avatars 2.0,但Instant Codec Avatars依然令人感觉逼真和富有表现力。另外,因为扫描所需的只是你的手机,所以它们更容易普及。

团队强调,这项工作依然处于研究阶段,它可能会,或者可能永远不会成为实际产品。不过,这只是未来五到十年技术发展方向的一瞥。Reality Labs评论道:“我们在过去数年的研究为未来的发展奠定了坚实的基础。”

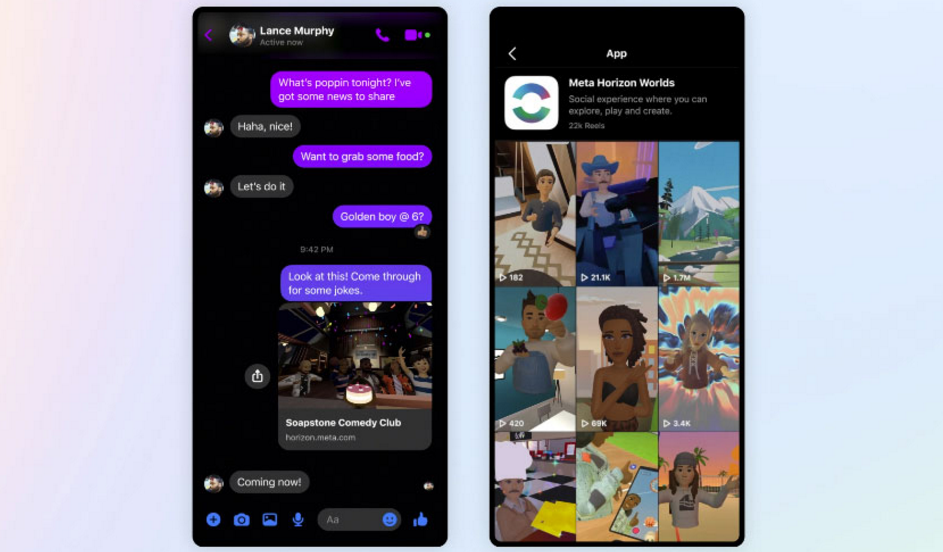

15. Horizon Worlds

Meta表示,元宇宙将为VR头显、智能手机、笔记本电脑和台式PC,甚至尚不存在的设备搭建桥梁。在今天的Connect大会,这家公司宣布将Horizon Worlds带到其他平台,这样你就可以通过手机或笔记本电脑拜访在VR朋友,反之亦然。例如,如果你正在欣赏喜剧节目,你可以将链接发送给你的朋友,这样他们无需头显都可以加入其中。网络将成为世界各地的人们体验虚拟世界的第一条途径。尽管网络并没有提供完整的VR体验,但它为开发者、创造者和人们带来了全新的体验。

Meta同时在测试一种允许你在Worlds录制视频,并轻松地将其作为一个Reel直接分享给Instagram的方法。团队同时与Instagram的创造者合作,呈现他们依靠奇思妙想所构建的世界。

他们同时简化了为Worlds构建内容的过程。过去你必须在虚拟现实中构建一切。现在,你可以在Horizon Worlds中看到由Crayta构建的令人难以置信的世界。同时,团队正继续将创意工具包扩展到VR之外,包括使用脚本语言TypeScript创建更加动态和交互式的世界。另外,Meta正在努力帮助你将tri-mesh项目导入Worlds,并使用诸如如Maya、3Ds Max、Blender和Adobe Substance 3D等3D内容创建工具构建部分世界。

它们是专业人员用来构建3D的高质量工具。支持它们的主要优势之一是其产生的图形质量。整合所有这一切需要一定的时间,但结果将令人期待。同时,Meta正在与Epic Games合作,将Creative Commons许可的内容从Sketchfab库引入Horizon Worlds。

Meta进一步谈到了你在元宇宙中的个人空间。它应该是一个社交空间,无论是什么设备,你都可以邀请你的朋友过来。最重要的是,你需要有一种如同家一般的舒适感。

这家公司进一步宣布,2023年将开始与NBCUniversal进行多年合作,将标志性的喜剧和恐怖体验带入元宇宙。“The Office”、“Blumhouse、“Universal Monsters”和“Halloween Horror Nights”都将来到Worlds。当Peacock应用在明年来到Meta Quest时,你就可以追番你最喜欢的NBCUniversal节目。

16. YouTube VR

Meta正在与YouTube VR团队合作,在社交方面进行创新。如果你在Horizon Home和朋友们一起共聚,你很快就能打开YouTube,大家排排坐,一起看视频。 另外,未来你可以同时处理多个任务,在工作或在家浏览网页时保持YouTube视频播放。

值得一提的是,如果你正在使用Quest Pro,你很快就能将YouTube视频(通过2D面板)带入其他VR应用程序。想象一下,你可以一边学习拳击课程,一边畅玩《The Thrill of the Fight 》,或者在《Walkabout Mini Golf》会话期间看音乐视频。

17. 健身

Meta强调,VR不仅仅是一个尝试新游戏和沉浸式体验的好地方,它对健身而言同样非常出色。Quest提供了各种各样的应用程序任君选择。在Connect大会,Meta又宣布了今年即将推出的产品和更新。

- Meta Quest 2 Active Pack:这是Meta的第一个健身捆绑包,今天可以预购,并将于10月25日以69.99美元的价格发售。这个捆绑包提供了一个全新的可擦洗面部接口、一套额外的腕带、以及用于进一步固定控制器的全新可调节指节带。 -

- Made for Meta计划(原Oculus Ready):Meta正在与硬件制造商合作,从2023年开始为Meta Quest带来更多配件。

- Quest Move(原Oculus Move):这个系统级健身应用可以帮助你跟踪和分享自己的健身进度。在今年, Quest Move已经正式支持Meta Quest app和苹果健康 app,从而允许你通过手机端查看相关的统计信息。

- 如果你是《Supernatural》的粉丝,相信你已经熟悉心流和拳击训练。但现在,这款应用添加了一种新型的锻炼方式:提膝。这是一种激发核心肌群和下半身活力的爆炸性方式,有助于你发展平衡和协调能力。《Supernatural》将于本月中下旬上线所述锻炼方式。

- Quest平台同时带来了推出了《Gym Class - Basketball VR》。这款基于物理的篮球游戏允许你最多可以与六个人在线游玩。你可以练习投篮和运球,或者进行精彩的扣篮。值得一提的是,《Gym Class - Basketball VR》在App Lab的下载量已经超过100万次,而IRL Studios计划在今年秋天把它带到Quest Store。

- Meta将在今年秋季发布一个Fitness API测试版,从而帮助开发人员更容易为Meta Quest平台构建健身内容。一旦实现,Fitness API就可以允许人们选择与开发人员共享来自Move的实时数据,如燃烧的总热量和锻炼的分钟数。这可以带来新的个性化体验,比如定制统计页面或根据进步解锁新内容。

- Meta在2023年会发布一种允许你与选定朋友分享健身进度的方式。

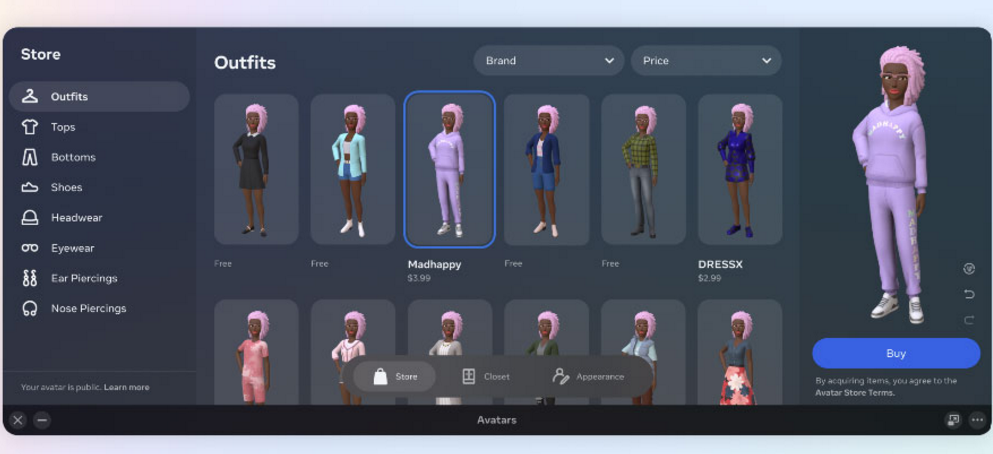

18. 元宇宙中的Avatar和身份

你的Avatar就是你,或者至少是你的数字表示。这意味着Avatar需要为你提供近乎无限的方式来在元宇宙中表达自己。在今年年初,Meta提供了耳蜗植入、耳上助听器和轮椅,从而帮助用户进一步表达自己。但现在,团队又有了更多的改进,包括更多的身体类型和更逼真的皮肤着色器。

你穿什么同样重要。所以,Meta宣布将于今年下半年带来Avatar Store,这样你就可以自由选购自己喜欢的虚拟服饰。Meta正在与体育、娱乐等领域的伙伴合作,以确保你能找到适合自己个人风格的服饰。团队表示:“我们希望这将启动一个可互操作的数字产品市场。换句话说,如果你买了一件毛衣,无论你使用什么应用程序,你都可以为你的Avatar穿上它。”

19. Avatar终于有了下半身

Meta在本届大会宣布了一个备受期待的功能:Avatar的下半身。

当你的数字身体呈现不正确时,比如说没有下半身时,这可能会分散你的注意力,打破沉浸感,甚至会令你感到不安。Meta的设备之前一直无法呈现Avatar的下半身,但现在Quest 2将能利用预测功能呈现你的下半身。

团队表示:“我们投入了大量的时间来确保Quest 2能够准确可靠地将你的双腿带到虚拟现实。”这一功能将首先向Horizon Worlds开放。但随着技术的进步,Meta将开始为更多体验提供双腿。

另外,Meta计划在2023年允许开发者在游戏和应用中实现定制的Avatar动作和行为。

需要注意的是,Meta强调真正成熟的Avatar尚需多年的时间,但他们正在稳步提高技术和对人们希望如何在VR中呈现自己的理解。

20. 增强现实之路

尽管Meta在虚拟现实和混合现实这两个元宇宙的重要窗口方面取得了重大进展,但Meta的增强现实依然需要大量的准备。这家公司指出,AR的基础技术尚需数年的时间才能发展到足以支持优秀AR眼镜的水平。在AR眼镜的梦想完全实现之前,团队需要看到整个堆栈的进展:计算、图形、显示器、传感器、AI,基本是所有一切。

Meta正在对相关领域进行投资,但对于AR眼镜而言,形状参数至关重要。所有技术都必须构建成足够轻便舒适的产品,以便用户可以随意佩戴。所以,他们正致力于打造能够适配普通眼镜形态的技术体验。

这家公司在2021年与Essilor Luxottica合作推出了第一代智能眼镜Ray Ban Stories。这是团队向前迈出的第一步。来到2022年,他们进行了升级:将视频捕获长度从30秒增加到60秒,并允许你更容易将内容从眼镜上传到Instagram。

解放双手是Ray Ban Stories的核心,不再需要你周围摸索手机。很快,你就可以用你的电话号码,并直接通过Ray Ban Stories拨打电话或发送短信。

当然,用户喜欢音乐,而Meta即将带来Spotify Tap。你只需轻触并按住眼镜的侧面即可播放Spotify。如果你想听到不同的声音,请再次轻触并保持,Spotify将为你推荐新的内容。

至于AR开发平台Spark。从今天开始,Meta将为创作者提供使用Spark Studio构建交互式3D对象的能力,并开始通过Spark Player在混合现实中测试它们。团队同时在开发允许创作者更好地了解注视和空间感知如何在物理世界之上形成3D内容的工具。