SLAM动态特征+身形图像深度学习,Facebook提出全身姿态捕捉新方案

精确描述自我姿态

(映维网 2021年10月27日)增强现实和虚拟现实中的真正沉浸式体验需要由用户姿态的显式表征所驱动。特别地,其需要从设备的角度估计用户的姿态,这隐含地对应于以自我为中心的角度,亦即与用户3D头部和身体姿态相应对的“Egopose/自我姿态”。自我姿态驱动着在AR和VR中构建自然体验所需的必要输入。例如,世界锁定的自我姿态表示为用户与虚拟场景中的音视频对象交互提供了必要的输入。对于涉及真实人物和虚拟实体(如化身或全息图)组合的对话,其需要精确描述自我姿态,以实现多个扬声器之间的无缝切换,同时保持沉浸感。

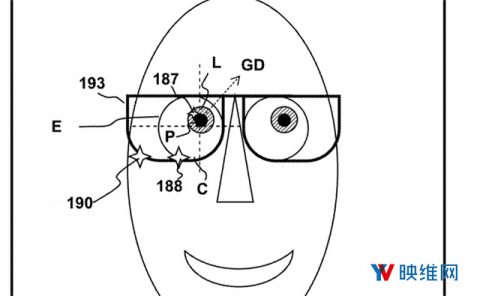

自我姿态估计是一项具有挑战性的任务。现有的方法通常分为两类:基于非光学传感器的方法和基于摄像头的方法。基于传感器的方法依赖于磁性和惯性属性,并给出了自我姿态的稳健估计。然而,它们需要特殊设计且难以设置的设备,并且具有限定用户一般性移动的侵入性。

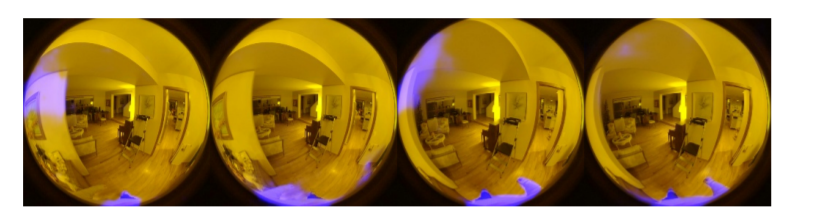

基于摄像头的方法则侵入性较小,可以在不同的环境中工作。其中一类方法依靠自上而下的朝内式摄像头来获得用户的最佳视图,而另一类方法则使用窄视场前向摄像头(用户不可见)。只要能够清楚地“看到”身体部位,前一种设置可以产生可靠的结果,但朝内式摄像头需要向前延伸,以避免鼻子和脸颊被遮挡。当用户离开视场时,姿态估计将完全失败。后一种设置的优点是在看不到用户的情况下估计自我姿态,但它难以解析模糊的身体姿态,尤其是手臂姿态。

......(全文 2009 字,剩余 1469 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限