微软专利介绍如何将手势识别适配不同AR/VR场景中

手势识别

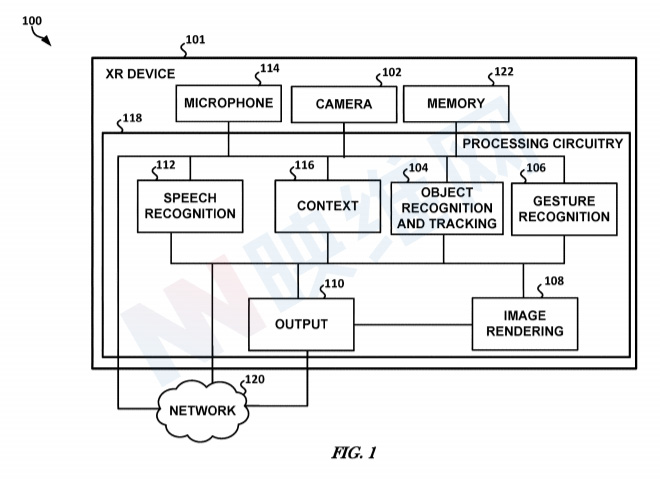

(映维网 2021年08月31日)XR设备可以提供各种XR用户交互。一种交互方法是可穿戴设备使用机器视觉检测用户的手指/手部及相关的手势,然后将其解释为命令。

但是,情景千千万万,而不同情景的操作命令同样数不胜数,所以设备需要定义千千万万个手势命令,而用户又需要学习千千万万的命令吗?有没有可能说,同一个手势在不同情景中可以智能地解读成特定的命令呢?比如说V字手势在幻灯片播放中解读成下一张,而在电视手势中则解读成快进呢?

在名为“Extended reality gesture recognition proximate tracked object”的专利申请中,微软主要介绍了相关的手势识别过程。具体来说,当存在被追踪对象时,识别位于被追踪对象附近的手势识别。例如当XR用户在操作呈现幻灯片的投影仪屏幕时,投影仪屏幕属于XR系统追踪的一个被追踪对象,然后XR系统可以识别位于投影仪屏幕附近的用户手势,并相应地执行相应的操作。

......(全文 1829 字,剩余 1492 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限