Facebook在CVPR2020分享最新AR/VR研究成果

查看引用/信息源请点击:映维网

新研究可以帮助我们解锁虚拟现实和增强现实的创新

(映维网 2020年06月15日)来自世界各地的计算机视觉研究者和工程师将在6月14日至19日举行的2020年计算机视觉和模式识别大会(Conference on Computer Vision and Pattern Recognition;CVPR)共聚一堂,而Facebook AI团队将通过演示,教程,研讨会,在线互动问答等方式展示相关的研究成果。

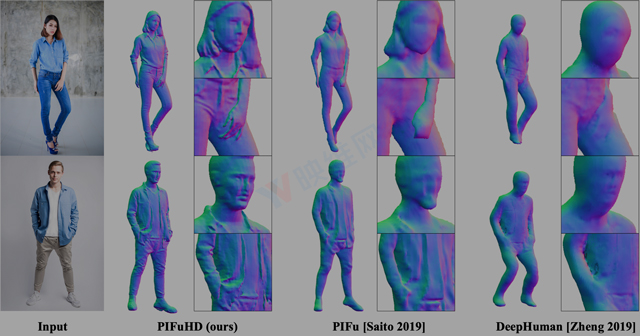

对于今年的CVPR大会,Facebook AI将介绍在计算机视觉众多重要领域的最新进展,包括核心分割任务,架构搜索,转移学习和多模态学习。团队同时将分享多项以新方法解释在常规二维图像显示的三维对象的论文等。这家公司指出:“新研究可以帮助我们解锁虚拟现实和增强现实的创新,以及其他未来体验。”

下面是Facebook将要在CVPR大会介绍的与AR/VR相关的论文及摘要:

1. Novel views from only a single image in complex, real-world scenes

我们构建了一个先进的端到端模型SynSin,它可以获取单个RGB图像,然后从不同的角度生成同一场景的新图像,无需任何3D监督。我们系统主要是预测一个3D点云,后者通过PyTorch3D使用我们的可微渲染器投射到新的视图上,并且将渲染的点云传递到生成对抗网络(GAN)来合成输出图像。当前的方法通常是使用密集体素网格,它们在单个对象的合成场景中显示出优秀的应用前景,但无法扩展到复杂的真实场景。

......(全文 3224 字,剩余 2776 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限