AR/VR行业兵家必争之地(下)-眼动追踪技术大全

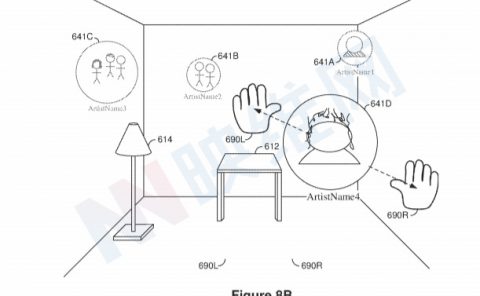

在本篇详细说明AR/VR眼镜上的眼动追踪技术原理。其中分别包括苹果、微软、Magic leap、Facebook、索尼等大厂的最新公开的眼动追踪技术方案。技术方案包括瞳孔角膜反射法、视网膜影像定位、结构光追踪、角膜反射光强度、视网膜反射光强度、光波导眼动追踪。

作者:陈涛,武汉天蝎科技创始人(微信:ct312036931)

一、眼球生理结构和特征

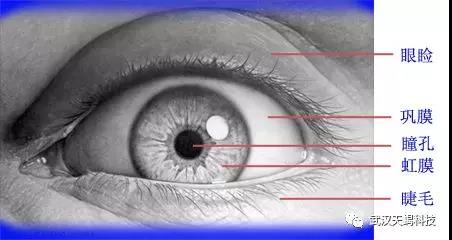

所有的眼动追踪技术都是根据眼球的生理结构实现的,不同的眼动追踪技术会用到不同的眼球生理特征,因此在了解眼动追踪技术之前有必要先了解一下眼球的生理结构。

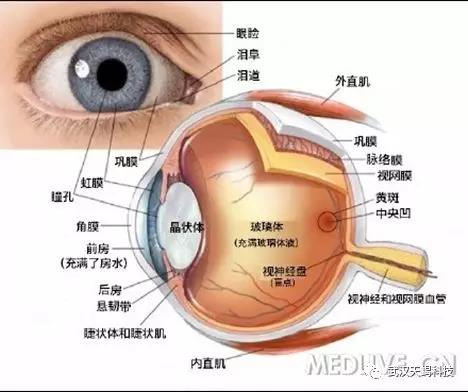

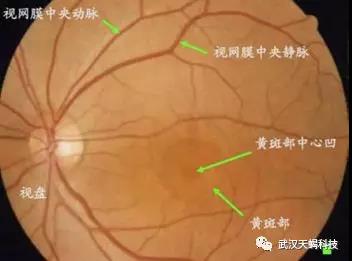

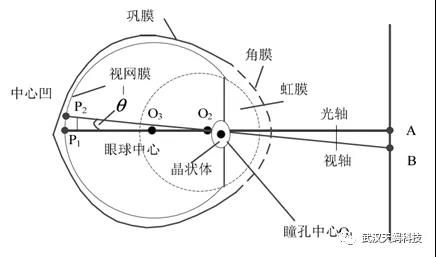

人类眼睛能够感知周围环境光线的明暗,主要包括眼球及人眼附属器官。眼球所接收的外界光线通过视神经传送给大脑,大脑对接收信号进行分析,支配人眼附属器官完成眼球的转动,使视线聚焦在目标区域。人眼生理结构如图 1、图2 所示。

图1 人眼正视图

图2 人眼生理结构图

(1) 巩膜:是人类眼球白色的外围部分,是保护眼球内部结构的最外层纤维膜。

(2) 角膜:是人眼最外层的一层透明薄膜,具有十分敏感的光线感知神经末梢,不但可以保护眼球内部,并且具有很强折光能力。角膜具有自己的曲率且不可调节,不同人的角膜曲率各不相同并且角膜中心是最高点。图 1 中O2为角膜曲率中心。

(3) 虹膜:虹膜是位于黑色瞳孔和白色巩膜之间的圆环状部分,其包含有很多相互交错的斑点、细丝、冠状、条纹、隐窝等的细节特征。而且虹膜在胎儿发育阶段形成后,在整个生命历程中将是保持不变的。这些特征决定了虹膜特征的唯一性,同时也决定了身份识别的唯一性。因此,可以将眼睛的虹膜特征作为每个人的身份识别对象。

(4) 瞳孔:眼睛中心颜色更深的环形部分就是瞳孔,人类可以根据外界不同的光线强度条件反射地通过虹膜肌的运动调节瞳孔大小及形状,进而将外界光线进入瞳孔的数量控制在一定范围内。图 1 中O1 为瞳孔中心。

(5) 晶状体:晶状体和照相机里的镜头非常相似,是眼球中比较重要的屈光间质之一。晶状体对通过瞳孔进入的光线具有折射作用,并且其形状和曲率可变,在不同距离观测目标物体时使眼球聚光的焦点汇聚到视网膜上。

(6) 视网膜:视网膜是一个专门负责感光成像的薄膜。由瞳孔进入的光线经过晶状体的折射作用汇聚到视网膜上,视网膜将汇聚的光信号转化为电信号传递给大脑。视网膜的分辨能力是不均匀的,黄斑区域是对光感觉最敏感的部位,其中间有一个小凹为黄斑中心凹,它包含大量的感光细胞。图 1 中P2 为中心凹。

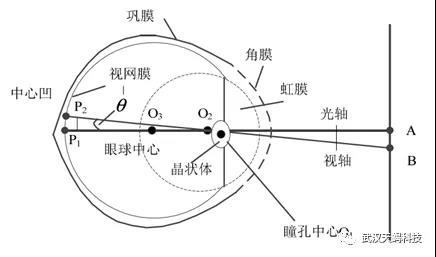

视线追踪系统中,黄斑中心凹 P2 与瞳孔中心O1 的连线称为视轴,即人眼实际注视方向,而实际估计的为角膜中心 O2 与瞳孔中心O1 的连线,称之为光轴。所以,大多数的视线追踪系统需要有一个定标过程,消除人眼视轴与光轴固有的生理偏差,得到真正视线的方向或注视点的位置。

目前近眼显示设备(例如Magic leap one)上的眼动追踪技术方案各种各样,全球的智能眼镜企业为了实现眼动追踪这个重要战略级技术也都各显神通,但是究其底层原理都是依据眼睛的生理结构实现的眼动追踪技术。接下来我根据眼睛的生理结构来为全球的眼动追踪技术进行分类,这将有助于我接下来的眼动追踪技术讲解。

二、眼动追踪技术分类

第一种. 瞳孔角膜反射法:通过角膜中心和瞳孔中心的连线进行眼动追踪。

代表企业:Magic Leap one 、Digilens、Tobii 、SMI、Apple、索尼。

图3 眼球结构中视轴与光轴区别示意图

第二种. 视网膜影像:因为视网膜上不规则的毛血管、中央凹等生理结构形成的图案,通过计算视网膜图像变化来进行眼动追踪。

代表企业:Magic leap(第二代或者第三代)、lumuc、三星。

图4 视网膜影像

第三种. 对眼睛建模后计算视觉中心:1.利用结构光对眼睛建模;2.利用光场相机对眼睛建模

代表企业:Facebook。

第四种. 视网膜反射光强度:激光透过角膜、瞳孔、晶状体最终打在视网膜上,视网膜会对入射的激光反射,外部光敏传感器通过检测视网膜反射光强度确定眼球运动的方向。

代表企业:Facebook、 Lumuc。

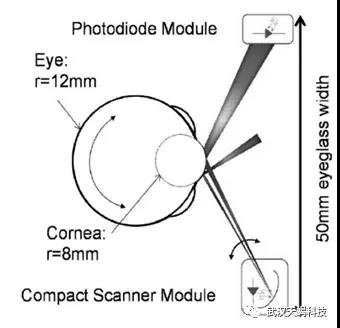

第五种. 角膜的反射光强度:角膜外壁较为光滑,如果在眼睛的一侧发射一束激光到角膜上时会被角膜反射。当激光刚好射在角膜中心时(角膜中心是最高点),激光的反射强度最大,因此通过光敏传感器检测角膜反射光的强度确定眼球运动的方向。

代表企业:微软、华为、 Adhawk。

图5 MEMS角膜中心反射示意图

三、眼动追踪技术详细说明

在上述的眼动追踪技术分类中,第一种瞳孔角膜反射法、第二种视网膜影像、第三种对眼睛建模后计算视觉中心这三种都需要用到摄像头。其中第一种和第二种都是通过计算机对眼睛的图像进行处理、特征点提取,进而获得的眼睛视觉中心。第三种通过摄像头(红外相机、深度相机)对眼睛重建为三维模型再计算视觉中心。第四种和第五种仅仅可以通过一个或者几个光敏传感器元件捕获眼睛反射光的强度获取眼睛视觉中心,反射光可能来自角膜中心或者视网膜。

从眼睛生理结构的特性出发,目前全球主流的智能眼镜公司的眼动追踪方法就为上述的五种。但是目前已公开的上百篇眼动追踪技术技术专利都有什么不一样呢?主要的不同点在于光学路径上的创新,围绕着发射光源的传播路径,摄像头获取眼睛图像的传播路径,使计算机获取稳定的、清晰的眼睛图像展开的。

接下来我将详细的介绍这五种眼动追踪的方法:

一、瞳孔角膜反射法:通过角膜中心和瞳孔中心的连线进行眼动追踪。

首先,我们讲讲瞳孔角膜反射法的前身为单摄像头无闪烁光源,该方法仅仅是通过摄像头获取眼睛的图像,从眼睛图像提取的瞳孔轮廓来计算瞳孔中心,进而推断每帧照片中眼睛的位移量,结合眼球模型注视点被映射在显示器上。这种眼动追踪的方法不允许头部的运动,因为这种方法的参考方法只有眼睛图像,头移动之后眼睛的图像也会发生位移。并且眼动追踪的误差也很大,其原因在于该方法忽略了角膜的屈光度,角膜会引起光的折射,忽略角膜折射可以导致几度的角度误差(见图6误差示意图)

图6:(A)折射导致在角膜界面进入或离开眼睛的光线弯曲。(B)考虑到显式瞳孔轮廓依赖于角膜的屈光特性,折射现象对无闪烁的注视估算方法提出了一个巨大的挑战。上方:无折射,假定眼球是球型;下方:实际情况眼球并非完整的球型,角膜在眼球上突出,形成一个小型半球形。

问:为了解决角膜曲率引起的折射偏差,所以要把角膜曲率也作为一个影响因素带入到眼动追踪的计算。那么如何计算角膜的影响参数呢?

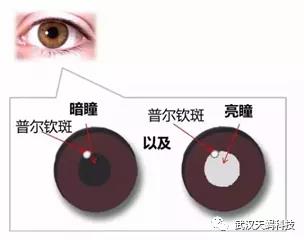

答案是:通过一个红外光源照射在角膜上产生一个闪烁点-普尔钦斑(Purkinje image),该闪烁点由进入瞳孔的光线在角膜外表面上反射(cornealreflection,CR)而产生(如图7)。由于眼球近似球体,照射在上面的闪烁点位置基本不会随着眼球的转动而改变。

图7 闪烁点-普尔钦斑示意图

在智能眼镜的眼动追踪系统中红外光源、摄像机的位置都是不变条件下,并且在眼球模型的结构基础上,利用闪烁点与光源位置计算得到角膜曲率中心。 利用图像处理技术计算获得瞳孔中心。通过角膜曲率中心与瞳孔中心的连线求得眼球光轴,并利用光轴和视轴之间的夹角计算得到了真实的视线方向—视轴。

需要校准的原因:所示如图8,视线追踪系统中,黄斑中心凹P2 与瞳孔中心O1 的连线称为视轴,即人眼实际注视方向,而实际估计的为角膜中心O2 与瞳孔中心O1 的连线,称之为光轴。所以,大多数的视线追踪系统需要有一个定标过程,消除人眼视轴与光轴固有的生理偏差,得到真正视线的方向或注视点的位置。

图8 眼球结构中视轴与光轴区别示意图

利用多个红外光源增强稳定性

问:上述的单摄像头单光源的眼动追踪方案在智能眼镜的使用过程中仍然会出现很多问题。当用户的头迅速摆动或者眼睛大幅度运动时,智能眼镜与眼睛的相对位置会改变,闪烁点在眼睛上的位置也会产生微量位移,因此就注视点位置会产生误差。并且在智能眼镜上眼动追踪系统的光源和摄像头距离眼睛很近,闪烁点可能会被眼脸、睫毛等挡住红外摄像头的视线,因而造成计算误差。

为了解决上述问题会通过2个或者2个以上的红外光源打在眼球上面。利用角膜上多个闪烁点共同计算角膜中心,图像识别获取瞳孔中心,带入到3D眼睛模型中计算获取三维空间的光轴。因此可以通过增加红外光源解决上述问题,目前我们可以在很多的VR眼镜上看到的眼动追踪模块都是一圈红外光。索尼的眼动专利还提出动态的投射多个红外光源到眼球上,以此降低外部因素对眼动追踪精度的影像。

实施例:AR眼镜Magic leapone眼动追踪技术方案。

Magic leap one:在头显眼框底部位置发现了眼动追踪红外摄像头。每个透镜都内置了4个LED的红外传感器,而传感器用于追踪用户的眼球运动。由于眼动追踪摄像头位于镜片底部,所以当眼睛往下看时,眼动追踪更加精准。

图9 A.Magic leap one眼动追踪模块展示

图9 B.Magic leap one眼动追踪模块展示

参考资料:

论文:一种基于眼球结构的视线映射几何模型设计 郑思仪;

论文:基于普尔钦斑点的人眼视线方向监测 李东升;

论文:基于瞳孔角膜反射法的视线追踪 李亚萍;

网站:单摄像头注视点估算,Pupil Labs带来精准眼动追踪效果

索尼专利:信息处理设备,信息处理方法和记录介质US20190191994

TOBII 专利:一种便携式眼动仪 US20180131850

二、捕获眼睛影像法:通过内置摄像设备捕获经由不同光学路径方案的眼睛图像。

2.1 利用反光镜传输眼睛影像

问:通过上图9可以看出用于眼动追踪的摄像头在眼睛的下方,显然Magic leap one是利用瞳孔角膜反射法进行眼动追踪,并且目前市面上已经上市的大多数AR/VR眼镜都是这种方法。图9中相机的镜头对着眼睛以便于拍摄眼睛的图像,摄像头所在的位置必须要能够拍摄到眼睛,并且保证获取到的眼睛图像尽可能减少畸变,以及摄像头位置尽可能正对着眼睛。因此,若摄像头位置太偏则使得眼动追踪误差太大,摄像头位置太正又影响了AR/VR眼镜上显示区域的画面显示,这也将阻碍未来实现更大的视场角。目前全球范围有很多都是在瞳孔角膜反射法的基础上优化采集眼睛图像的光学方案,以何种光学方案来获取无畸变、平稳、清晰的眼睛图像是眼动追踪技术专利创新的不同点。

上述问题,在AR/VR眼镜上可以通过添加一种正面反射光,同时背面还可以透光的光学元件的方法改变光学路径可以使上述问题解决。下面以SMI和苹果关于智能眼镜上眼动追踪专利技术作为讲解。SMI和Apple的眼动追踪技术方案:SMI眼动追踪技术具有一定的权威性,是国际上知名的眼动追踪设备生产商,并且国际上传统的眼动心理学实验中广泛使用这家的眼动追踪仪器。2017年5月SMI被苹果收购。

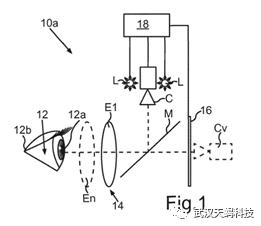

图10 SMI和Apple眼动追踪技术示意图(图10中:10a眼动追踪系统、12眼睛、12a瞳孔、E1放大透镜、M热镜、C红外相机、L红外光源、18控制处理器、16显示装置、CV虚拟照相机)

红外光源L发射的光接触到热镜M后发生镜面反射,红外光经过E1打在瞳孔12a上形成了闪烁点,并且红外入射光照亮了眼睛特征。热镜M光学特性是一面反射红外光,一面可以透光,透光的一面可以经过显示器虚拟影像,也可以经过现实世界的光。透镜E1具有光学校正和放大影像的作用,瞳孔12a上的闪烁点和瞳孔、虹膜、巩膜影像光被透镜E1聚光收集后投射在热镜M,经热镜M反射后被相机C接收。因此,相机通过热镜E实现了在VR眼镜狭小的空间结构中获得了眼睛的闪烁点和瞳孔影像,利用瞳孔角膜反射算法可以计算出眼球注视点。

参考资料:SMI专利:眼镜追踪设备和用于操作眼睛追踪设备的方法 WO 2016180702

APPLE专利:眼动追踪装置及通过镜头系统提供无漂移眼动追踪的方法 US10354136

Google专利:基于棱镜的眼动追踪 US10303940

TOBII专利:VR和AR的眼动追踪 US20190219818

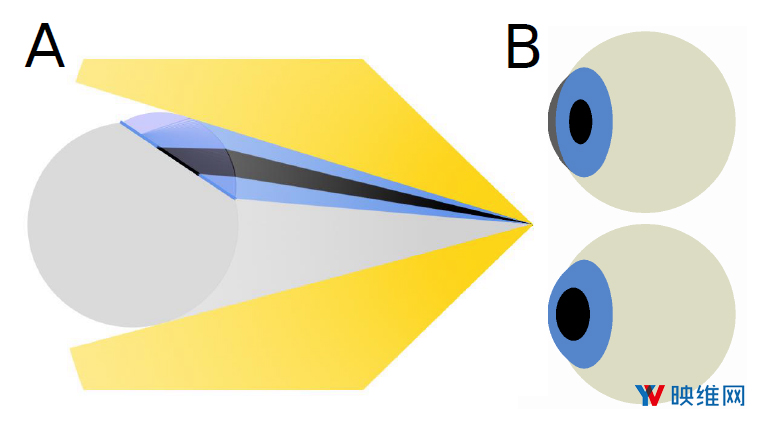

2.2利用光波导传输眼睛影像

问:上述中VR眼睛的眼动追踪利用反射镜作为光学解决方案,那么AR智能眼镜呢?AR眼镜相比VR眼镜有着更狭窄的硬件设计空间,这使得AR眼镜使用反射镜/棱镜这类的光学元件改变发射光和接受眼睛图像的光学路径并不能很好解决方案。因为AR眼镜上,我希望能够把AR眼镜设计的足够小、足够轻,最终达到普通的太阳眼镜的大小,例如钢铁侠的AR眼镜(图11)。为了使AR智能眼镜上眼动追踪的光学方案尽可能的轻薄,眼动追踪系统的摄像头位置尽可能不影响视野和显示系统,那么该使用什么样的光学方案呢?

图11 钢铁侠AR眼镜

为了使AR眼镜能够达到最佳的设计效果,此时眼动追踪系统需要与AR眼镜的光学成像系统相结合。目前,AR智能眼镜的光学显示系统包括棱镜技术-Google 眼镜、自由曲面技术-EPSON智能眼镜、离轴光学-Meta2、光波导-Magic leap one和HoloLens2。其中光波导光学显示系统凭借体积小、镜片厚度薄、重量轻、视场角大等优势成为国内外主流AR智能眼镜首选的近眼显示成像方案。光波导成像技术原理与光纤的传导原理类似,光以一定的入射角在光纤内壁上形成全反射,光通过无数个全反射被传导至末端。利用此原理,AR眼镜图像显示器的影像光被光波导镜片传导至眼睛前,然后被波导耦合元件耦合而出形成全息影像。同理在眼动追踪技术,我们也可以通过光波导技术将眼睛反射光影像传导至摄像头,眼睛反射光影像相当于上述的显示器的影像,摄像头相当于上述的眼睛,此处的摄像头隐藏在AR智能眼镜内部结构中,避免了原始眼动追踪系统中摄像头的外露,使得摄像头可以收集眼睛正前方的影像,而不至于在眼睛的边缘收集影像,并且这为AR眼镜的光学成像设计、外观设计留下了很多的设计空间。

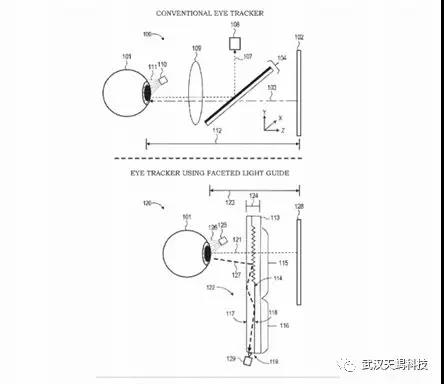

图12 谷歌专利 使用带有刻面组合器的光导进行眼动追踪原理示意图

图12上部分中,所描绘的常规眼睛跟踪系统100包括眼睛101,该眼睛101通过吸收穿过热镜104和透镜109(例如沿z轴)的可见光103来观看显示面板102。热镜104被配置为反射特定光谱(通常是近红外光谱)中的光,同时允许该光谱之外的光(即可见光)通过。光源110可以被布置成接近系统100,并且提供光111,例如IR光,其为图像传感器108提供眼睛101的增加的照明。IR光通常包括波长从大约750到1250纳米(nm)的光。图像传感器108定位成接收从眼睛101反射并由热镜104反射的IR光111。图像传感器108捕获由IR光107表示的眼睛101的一个或多个图像。如图12所示,当直接面向前时,热镜104通常相对于眼睛101的光轴成45度角或以45度角放置,以允许图像传感器108位于视野(FOV)的外部。热镜104的这种成角度的布置要求在眼睛101和显示面板102之间有相当大的观看距离112。与之相一致,常规的头戴式显示器(HDM)必须足够大以容纳热镜104。涵盖了每只眼睛的大部分或整个视野。

图12下部分中,与传统的眼睛跟踪系统相反,眼睛跟踪系统120包括多面光波导122而不是热镜。光源125向眼睛101提供诸如红外光126,红外光126被眼睛反射形成反射光127,反射光127进入光波导122后被耦合光学114耦合偏转方向,眼睛影像光127被传导至图像传感器129,计算利用图像传感器129获取到的图像计算眼动追踪。 因为这里呈现的眼睛跟踪的实现基于波导,所以与基于具有类似功能的“热镜”的传统方法相比,眼睛跟踪的性能准确性得以保持或甚至改善,同时实现更小的封装尺寸和整体更低的重量。

参考资料:

谷歌专利:使用带有刻面组合器的光导进行眼动追踪 US20190101757

https://patent.nweon.com/3163.html

关于光波导技术相关知识可参考如下:

2.3 利用光波导传输红外光和眼睛影像

问:除了上述的将眼睛的反射光影像通过光波导元件传送至摄像头之外,还可以将照亮眼睛特征的红外光也通过光波导传送至眼睛,这样红外光源同样可以隐藏设置在AR智能眼镜内部,这样的入射光方案优势在于使得AR眼镜的外观整洁、硬件架构设计方便,同时红外光可以充分且均匀的照射在眼球上。接下来以Magic leap的一个储备专利技术为例(配备波导的增强现实显示器可捕获眼睛图像 US20190086674)

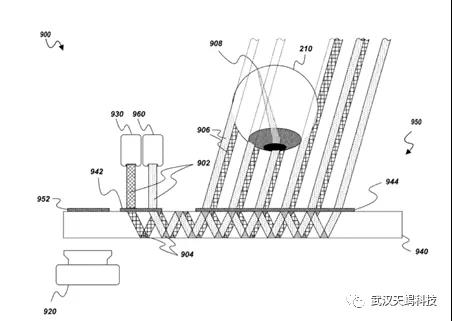

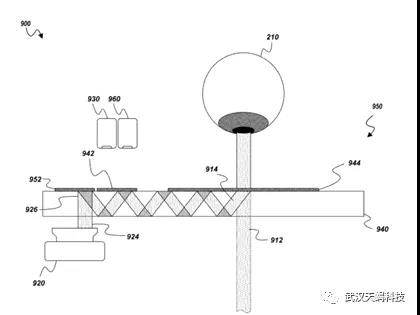

图13 示意性地示出了红外光和影像光通过光波导元件传送至眼睛的过程(如图所示13 :眼动追踪系统900、图像投影仪930、照明源960、光学内耦合器942、红外光源902、全反射传到的红外光源904、光波导镜片940、光学外耦合器944、射出红外光906、视网膜908、眼睛210、耦合光学元件952、摄像头920)

图14 示出了眼睛的反射光通过光波导元件传送至摄像头的过程(耦合进入波导镜片的眼睛反射光914、一部分眼睛的光源图像912、耦合光学元件952、被耦合偏转角度的眼睛影像光924和926、摄像头920)

三. 利用视网膜影像计算注视点

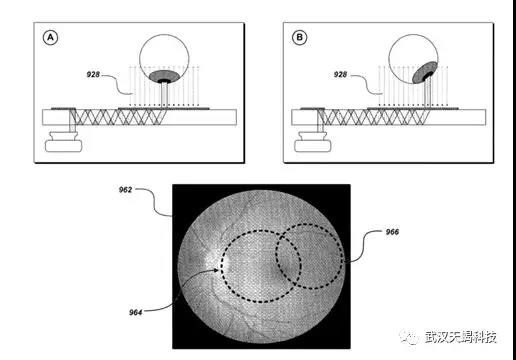

通过上述的光波导眼动追踪技术,光波导不仅仅可以收集眼睛的巩膜、虹膜、瞳孔图像来计算视觉中心点,还可以采集人眼内部视网膜的影像,在上图视网膜图例中我们可以观察到视网膜上的特征都包括的血管、中央凹、视盘、黄斑等生理特征,通过光波导传输给摄像头每一帧视网膜图像上不同的特征变化计算获取眼球运动向量,其中原理类似激光鼠标。当然,有了图像计算眼球运动向量的算法有很多,也可以视网膜全部影像计算机获取后储存起来,并将影像一一与眼球注视方向对应,从而根据实时所拍摄到的视网膜图像计算获得注视方向。

图15 A图眼球的位置对应着视网膜964区域的影像,B图眼球位置对应视网膜966区域位置

参考资料:

LUMUS专利:基于光导成像光学元件的眼动仪 US20190056600

DIGILENS专利:全息波导眼动仪 US10209517

Magic leap专利:配备波导的增强现实显示器可捕获眼睛图像 US 20190086674

Face book专利:光场波导集成眼动 US10168531

三星专利:用于输出虚拟图像的可穿戴设备和方法 US10175485

四. 重建三维模型法:

将眼球重建为三维模型进行眼球追踪

至此,上述无论是瞳孔角膜反射法还是光学方案改进后的眼动追踪方法都是通过摄像头获取眼睛上特征的图像,计算机主要是通过处理图像来计算眼球的运动。Facebook所公开的眼动追踪技术中,其中提出了一种利用结构光或者光场相机实时对眼球重建为三维模型,通过计算眼球三维模型获取眼球的运动方向,进而实现了眼动追踪。例如在iPhone X 人脸识别技术中就充分运用了结构光。

结构光眼动追踪说明:

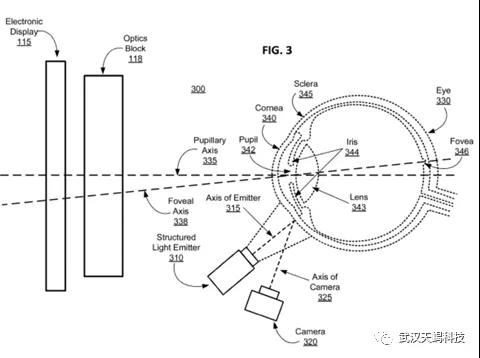

图16 结构化光发射器和照相机的结构光眼动追踪系统示意图

如图16,结构光眼动追踪方法中包括结构化的发光器310和照相机320。眼动追踪系统或其元件是头戴式显示器的一部分。结构化光发射器310以结构化光图案照射眼睛,例如结构光图案315可以是矩形点阵、光栅条纹等。照相机捕获用结构化光图案照射的眼睛的图像(例如,捕获图像作为视频流)。发射器310和照相机320之间的视差可能导致照明图案的图像(图像帧)失真。眼动追踪基于捕获图像中明显的失真来检测结构光入射到其上的眼睛的表面的一部分的形状。基于检测到的眼睛形状与模型的比较,眼睛跟踪单元估计眼睛的方向。估计眼睛的方向可以包括例如确定眼睛的偏航,俯仰和侧倾旋转以及眼睛的平移矢量。在一些实施例中,估计眼睛的取向包括估计眼睛的中央凹轴的方向。通过估计眼睛的瞳孔轴335(光轴)的方向并使用在瞳孔轴和中央凹轴338之间的偏移,可以间接地估计中央凹轴338(视轴)的方向。估计的方向可以用于例如确定注视方向,

在一些实施例中,在眼睛跟踪开始之前,可以通过训练用户的眼睛模型来校准系统。训练模型可以包括控制电子显示器以在电子显示器上的位置处显示视觉指示器;以及 所述摄像机捕获所述发射器投射到眼睛上的第二变形照明图案的第二图像;并基于捕获的第二图像并基于视觉指示器的位置训练模型。

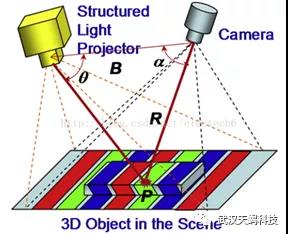

结构光说明:结构光法就是使用提前设计好的具有特殊结构的图案(比如离散光斑、条纹光、编码结构光等),将图案投影到三维空间物体表面上,使用另外一个相机观察在三维物理表面成像的畸变情况。如果结构光图案投影在该物体表面是一个平面,那么观察到的成像中结构光的图案就和投影的图案类似,没有变形,只是根据距离远近产生一定的尺度变化。但是,如果物体表面不是平面,那么观察到的结构光图案就会因为物体表面不同的几何形状而产生不同的扭曲变形,而且根据距离的不同而不同,根据已知的结构光图案及观察到的变形,就能根据算法计算被测物的三维形状及深度信息。

图17 结构光法原理示意图

参考资料:

Facebook专利:使用密集结构光图案的眼动追踪系统 US20190101978

Facebook专利:利用结构光进行眼动追踪 US10268290

【深度相机系列一】iPhone X的原深感相机到底是个什么玩意?

https://blog.csdn.net/electech6/article/details/78348917

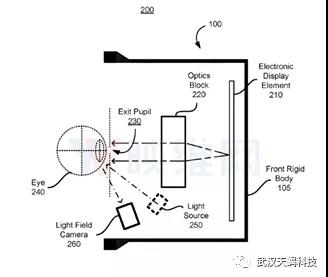

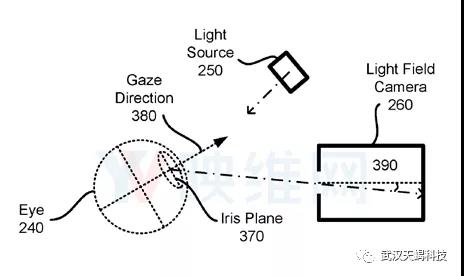

光场相机眼动追踪说明

根据专利 US20180173303A1描述,这样的头戴式显示器将具备多个光场摄像头,以及位于设备内部可照亮用户两只眼睛的光源。光场摄像头用于捕捉用户眼睛的全光图像,包括光强度数据和光线的方向数据。眼动追踪系统基于来自全光图像帧的深度信息来更新用户眼睛的3D光场模型,进而利用3D光场模型识别用户眼睛的虹膜平面,在通过识别虹膜平面中心的法线来确定用户眼睛的注视方向。

图18

光场摄像头或全光摄像头可以拍摄包括关于光强度和光线方向信息的图像。与之相比,传统摄像头仅捕捉光强度的信息,不包含所述光线的方向信息。在光场摄像头拍摄图像之后,图像处理技术可以重新聚焦在图像的不同部分之上。例如,图像最初聚焦在背景中的树上,然后可以重新聚焦在前景附近的花朵上。

图 19

由于光场摄像头可以捕捉光方向数据,因而眼动追踪系统不需要依靠角膜球面反射模型或闪烁位置来计算用户眼睛的角膜中心。因此,不需要将外部照明源定位在相对于光场摄像头的特定位置。光场摄像头在头显内部的定位位置也拥有更多的自由度。最终实现用户眼睛的注视方向用于控制头显的电子显示器,对应用户注视方向的电子显示器部分以高分辨率渲染图像,而其他部分以较低分辨率渲染图像,从而节省头显系统的计算资源。

相关专利:Eye tracking using a light field camera on a head-mounteddisplay

http://appft.uspto.gov/netacgi/nph-Parser Sect1=PTO1&Sect2=HITOFF&d=PG01&p=1&u=%2Fnetahtml%2FPTO%2Fsrchnum.html&r=1&f=G&l=50&s1=%2220180173303%22.PGNR.&OS=DN/20180173303&RS=DN/20180173303

五&六、视网膜/角膜反射法:

五,利用视网膜反射光强度检测眼动追踪法;

六,利用角膜顶点处的反射光强度检测眼动追踪法。

问:至此,上述所提到的眼动追踪技术都是通过摄像头实现的,无论是瞳孔角膜反射法,还是利用光波导传导眼睛或视网膜图像,亦或者利用结构光或光场相机对眼睛建模进行眼动追踪,通通都是通过摄像头实现的眼动追踪(虽然用到相机的类型繁多)。既然是通过对摄像头拍到的图像进行计算,进而获取眼球的注视位置,要知道该类图像计算的追踪方法对CUP计算量和电量的消耗是巨大的。我在上篇《AR/VR行业兵家必争之地(上)-眼动追踪应用大全》提到,眼动追踪为AR智能眼镜的光学显示、交互控制、目标识别、身份验证(虹膜识别)和活体检测、健康检测、虚拟社交有着重要的意义。在未来智能眼镜应用场景成熟后,眼动追踪可能会是一个需要实时开启的硬件。因此,在未来的眼动追踪模块只有低功耗、高精度且轻便才能够满足未来的AR眼镜的需求。

接下来重点我将讲解两种只需要眼镜反射光强度就可以计算获得眼睛注视方向的眼动追踪技术方案。

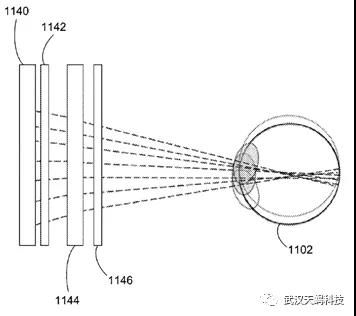

五,利用检测视网膜反射光强度实现眼动追踪,来自Facebook专利嵌入式眼动仪,US10274730;

图20 Facebook视网膜强度眼动追踪示意图

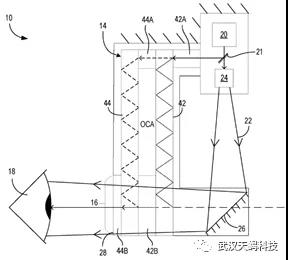

如图20所示, Facebook构思的显示设备包含四层元件:

1140为光敏传感器阵列,是一个光敏传感器和一个红外光发射器设置在同一位置组成一组,该光敏传感器阵列是由许许多多的组形成的二维阵列。光敏传感器阵列设置在AR/VR眼镜显示器的后方。

1142为透镜阵列,用于将来自发射器的光线引导至眼睛,并将眼睛反射的光线引导至传感器。

1144是二维显示块阵列,用于对虚拟影像的成像,显示块阵列对红外光透明。所以,传感器面板发射的红外光可以通过显示块阵列并到达眼睛。

1146,同样是透镜阵列,用于对显示器图像的校正或者是虚拟影像深度的调节。

这时,当1140光敏传感器阵列上每个红外光源发射红外光,红外光经过1142、1144、1146组件,直至穿过眼睛瞳孔,最终打在眼睛的视网膜上。视网膜会反射红外光,反射光会经过原来的路径最终被1140上的光敏传感器接收。但是这里需要重点关注的是,只有和眼球瞳孔中心和角膜中心(光轴)在一条直线上的那个光敏传感器所接收到的反射光强度是最大的,由于光敏传感器的位置计算机已知,所以通过分析反射光最大强度就可以获取相应光敏传感器位置,光敏传感器强度最大处位置就是眼球的注视位置。

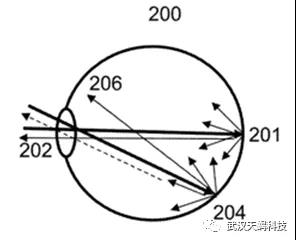

视网膜反射光强度原理

图21 视网膜上反射原理图,提供的人眼的示意性侧视图,给出了针对不同入射角的镜面反射和漫反射的几何形状

图22 视网膜上反射原理图;是本发明实施例提供的光线进入眼睛后被视网膜和虹膜反射示意图

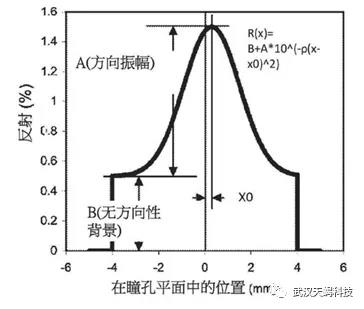

图23 眼睛反射的光的强度的曲线图,给出了来自视网膜的照射反射的变化作为角度的函数图(通过改变瞳孔偏移而变化)

所示如图21,描述利用视网膜的详细特征进行反射捕获的实施方式中进行了描述,来自视网膜的反射通常包括镜面反射和漫反射。图21中的眼睛200的简化模型包括:图21示出了垂直照射在视网膜201的中心上的轴上光线。强镜面反射光202通过入射光瞳反射,因此在外部强烈地检测到该反射。然而,当光以离轴角度204照射在视网膜上时,镜面反射206不会离开瞳孔,并且仅有被去除的反射离开瞳孔(标记为虚线箭头),因此外部光敏探测器检测到的弱得多的信号。上述可以看出视网膜的中心区域具有比视网膜的非中心区域更高的反射率。

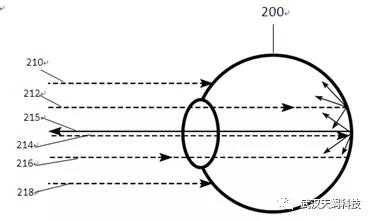

如图22所示,进入眼睛201的光线212,214和216被眼睛201的视网膜反射,上述的入射光212、214、216比光线210和218更好地反射,光线210和218被眼睛201的巩膜反射。此外,光线的光线214是由眼睛201的中心区域反射的光线215被眼睛201的非中心区域反射的光线212和216反射得更好。

图23示意性地示出了由眼睛反射的光的强度的曲线图。镜面反射分量(表征为可变幅度A)是角度相关的(这里描述为光瞳位置),而漫反射大致恒定(表征为幅度B)。在图19C中,由眼睛的中心区域反射的光具有比眼睛的非中心区域更高的强度。因此,在一些实施例中,眼睛的位置(例如,眼睛的瞳孔的位置)是由眼睛反射的光强度的轮廓确定的(例如,具有最高反射光强度的位置对应到眼睛中心的位置)。参考资料:LUMUS专利:基于光导成像光学元件的眼动仪 US20190056600

Facebook专利:光波导集成的眼动追踪系统 US10268268

Facebook提出『内置眼动追踪的AR显示设备』,以实现紧凑轻便

Facebook 专利:带有嵌入式眼动仪的显示器 US10274730

https://patent.nweon.com/3515.html

Facebook 专利:基于瞳孔位置的眼球投射 US10359629

Facebook专利:使用分段电极阵列增强空间分辨率US20190179205

六,利用角膜顶点处的反射光强度检测眼动追踪法。

图 24

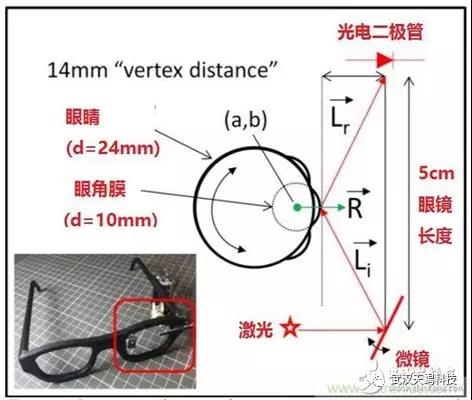

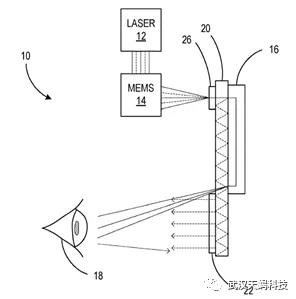

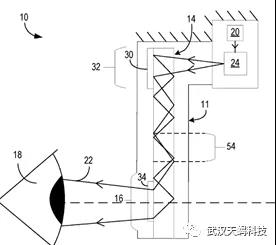

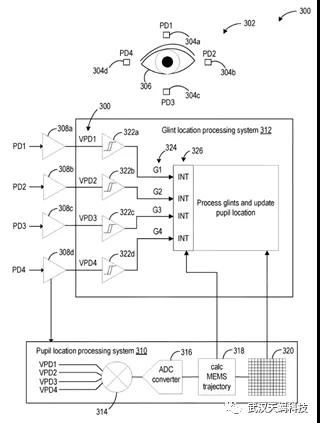

以上是加拿大Adhawk提出的眼动追踪方案,也是本人看到最早提出利用MEMS扫描光照射眼睛角膜的眼动追踪技术方案。该技术方案具体为在智能眼镜的一侧红外激光发射的光束打在MEMS反射镜上,MEMS反射镜可以改变激光射向眼睛的角度,扫描激光在眼睛上的接触点可以形成任意的扫描路径,例如扫描路径包括正弦余弦函数,还包括光栅扫描路径、Lissajous图案,rhodonea曲线,圆形路径,椭圆路径。扫描路径在眼睛上形成的二维图像就是眼球追踪的扫描范围,走完一次扫描就是对眼睛的一次采样。其中,当执行一次扫描路径时,在这个周期内的某一时刻必然会扫在角膜的中心点上(眼球最高位置),而入射激光这个点上所产生的镜面反射会把光反射出去,这时另外一侧的光敏传感器所检测到的反射光强度是最强的。光敏传感器会将光信号转化成电信号,电路中的比较器会筛选出最大电信号,并且中段器会记录下电信号强度最大这一时刻的时间,最后计算机在利用时间和扫描路径/MEMS反射镜角度去反推眼睛的注视位置。

笔者认为这个眼动追踪的的方法指的技术人员深入的学习,这个眼动追踪的方法中利用MEMS扫描镜和光敏传感器、中断器巧妙的将二维的扫描路径转化为一维的时间去表示和计算。相比于上述利用图像计算进行眼球追踪的技术方案,本段所述的MEMS扫描镜眼动追踪的计算量下降的不是一星半点,而且该技术方案的眼动追踪硬件成本下降的也不是一星半点,硬件的体积也非常下,十分符合AR眼镜轻便和功耗低的设计需求。从微软目前已公开的近眼显示设备上的眼动追踪技术可知,微软也是MEMS眼动技术的拥护者,相比于Facebook已公开的眼动追踪技术,微软更为专一,不像是Facebook广撒网。微软目前已公开的MEMS眼动技术分别在光学路径、信号处理、传感器硬件这几个角度进行的专利保护。

光学路径-利用反射传播扫描光 US20190050051

光学路径-利用光学继电器传播扫描光 US20190056599

光学路径-利用波导镜片传导扫描光 US20190155046

微软MEMS眼动技术信号处理-使用扫描光束和多个探测器进行眼动追踪 (US10303248)

微软MEMS眼动技术信号处理-使用扫描光束和多个探测器进行眼动追踪 (US10303248)

什么是MEMS?

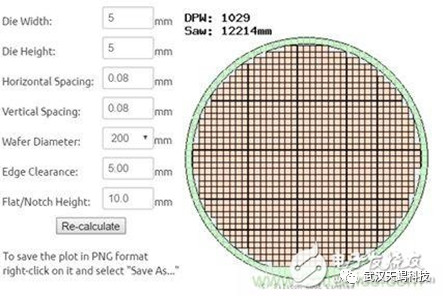

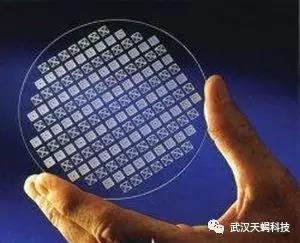

MEMS(Micro electromechanical systems,微机电系统/微机械/微系统),是采用微电子技术、集成电路技术及其加工工艺制作而成的微米级别机械器件。MEMS往往会采用常见的机械零件和工具所对应微观模拟元件,例如它们可能包含通道、孔、悬臂、膜、腔以及其它结构。MEMS传感器、驱动器同样可以实现眼球追踪功能,并且具有极大的发展潜力。MEMS器件的特征长度从1毫米到1微米,相比之下头发的直径大约是50微米。MEMS器件主要优点是体积小、重量轻、功耗低、可靠性高、灵敏度高、易于集成等,是微型传感器/驱动器的主力军,正在逐渐取代传统机械器件。其成本有可能通过工艺优化、批量生产大幅度降低,主要原因是由于MEMS生产不同于传统加工制造生产,MEMS采用类似于集成电路的制造工艺,由于产品体积小,在一个二十厘米的硅片上可一次性生产出上千器件。若单个MEMS传感器芯片面积为5mmx5mm (也有大量MEMS传感器可以小于毫米尺度),则一个8英寸(直径20厘米)硅片(wafer)可切割出约1000个MEMS传感器芯片,分摊到每个芯片的成本则可大幅度降低。由于具有上述优势,基于MEMS的眼动追踪系统在AR/AR系统中具有不可比拟的优势,也将成为VR/AR装置小型化、低成本化的重要资本。

图示为8英寸硅片上的MEMS芯片(5mmX5mm)示意图

图示为硅片,其上的重复单元可称为芯片(chip 或die),每个重复单元可含有若干MEMS传感器,甚至包含相应的集成电路

参考资料

微软专利:使用扫描光束和多个探测器进行眼动追踪 US10303248

微软专利:利用MEMS和反射光的眼动追踪 US20190050051

微软专利:利用MEMS扫描和光学继电器进行眼动追踪 US20190056599

微软专利:使用Mems扫描和光学继电器进行眼动跟踪US10394034

微软专利:基于硅光电倍增管传感器的高效基于Mems的眼动追踪系统US20190250703

微软专利:用于可见光显示设备的眼睛跟踪系统 US20190250704

Adhawk专利:System andMethod for Resonant Eye-Tracking US2018210547A1

Adhawk专利:眼球追踪系统及方法US2017276934A1

Adhawk专利:眼动追踪系统及其方法US2016166146A1

华为专利:一种眼球追踪系统和眼球追踪方法 CN107515466

华为专利:一种启动眼球追踪功能的方法及移动设备CN108027644A

从上述的AR/VR第一梯队公司所眼动追踪技术公开专利技术不难看出,几乎所有的AR智能眼镜公司都在布局自己的眼动追踪技术,相对于中国的科技公司目前的在眼动技术上的布局很薄弱。同时从上面的分析不难看出目前的全球眼动追踪技术都处于开始阶段,后面还有需要大量的技术迭代,我认为好的眼动追踪技术一定是需要和光波导元件、显示光学方案一起考虑设计才能有更好的效果。眼动追踪可以为波导显示器提供更好的显示效果,同时波导也可以为眼动追踪提供更高追踪精度。天蝎科技吸收全球的眼动追踪技术的优点,也提出了一种利用眼动追踪技术专利,希望能够与我国的AR智能眼镜生产商、波导镜片生产商合作。

同时,天蝎科技拥有大量AR眼镜上基于眼动追踪应用软件商业模式发明专利,可以完善AR眼镜硬件公司的战略布局。眼动追踪应用具体可详见 阅读原文《AR/VR行业兵家必争之地(上)-眼动追踪应用大全》。

作者介绍:

天蝎科技来源于一部讲述由天才黑客团队的美剧《天蝎计划》,目前团队由90后组成的创业团队。作者认为每个时代都有每个时代的馈赠,2000年 PC和互联网成就了微软;2010年 手机成就了苹果;移动互联网成就了微信和支付宝,同时在无数80后前辈的努力下也成就了许多互联网产品。所以下个AR/VR、5G的时代90后必须参与。最后特别鸣谢:虽然本人与映维网刘总素未谋面,但是希望借此感谢映维网为中国AR/VR行业所提供的社会公共资源。尤其是专利板块为我开启了世界的大门,让我这样的草根创业者能够接触世界顶尖智能眼镜公司的专利技术。使我们快速的吸收先进的技术。

武汉市天蝎科技创始人 陈涛

PS:如果您对本项目感兴趣,有合作及投资意愿的朋友与我们联系(微信号ct312036931)