VR研究:谷歌借助纯眼部追踪预测面部表情

文章相关引用及参考:techcrunch

在眼球、眉毛、眼部皱纹等区域之间,我们其实可以发现不少的信息

(映维网 2017年7月29日)有人说判断是否真笑要看眼睛。当然,这是因为我们都需要学习这种假笑。但我们眼球区域的微表情有一个额外的好处:VR研究人员利用这一点来判断面部其他区域正在做什么。

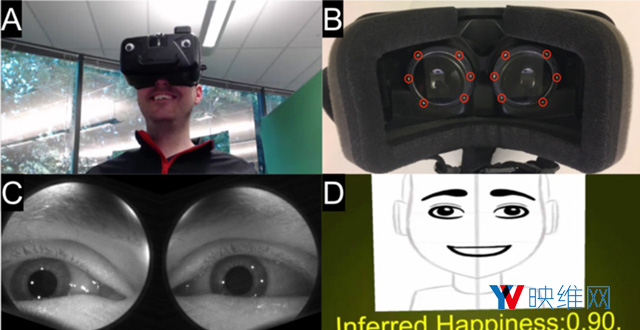

谷歌研究院刚刚发布了一个有趣的小项目,试图通过在头显内追踪眼睛来掌握用户表情。在眼球、眉毛、眼部皱纹等区域之间,我们其实可以发现不少的信息。

无论如何,这部分信息足以让深度学习系统判断出一些基本的表情和程度,而且还相当精准。系统能够分辨出“开心”和“惊喜”,但数据尚不够丰富,不足以识别出“幸灾乐祸”或“使坏”。

谷歌研究院的想法是,通过最低程度的监测工具(头显内的眼部追踪传感器),你至少能大概知道用户面部正在做什么。谷歌研究院已经发表了相关论文,当然,你也可以在即将召开的SIGGRAPH大会上听取他们的报告。

相关论文:EyeMotion: Classifying facial expressions in VR using eye-tracking cameras

......(全文 350 字,剩余 0 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限