谷歌XR专利提出基于上下文感知的用户输入事件检测方法与系统

基于历史交互数据训练的上下文模型

(映维网Nweon 2025年12月08日)对于XR设备交互,传统方法依赖摄像头、陀螺仪等传感器识别手势、语音等输入时,容易因用户相似动作(如日常手势与操作UI的手势混淆)导致误判,交互准确性不足。在一份专利申请中,谷歌提出引入基于历史交互数据训练的上下文模型(如Transformer),将实时传感器数据与用户习惯等上下文信息融合计算,以生成更可靠的输入判断,从而显著提升交互精准度和用户体验。

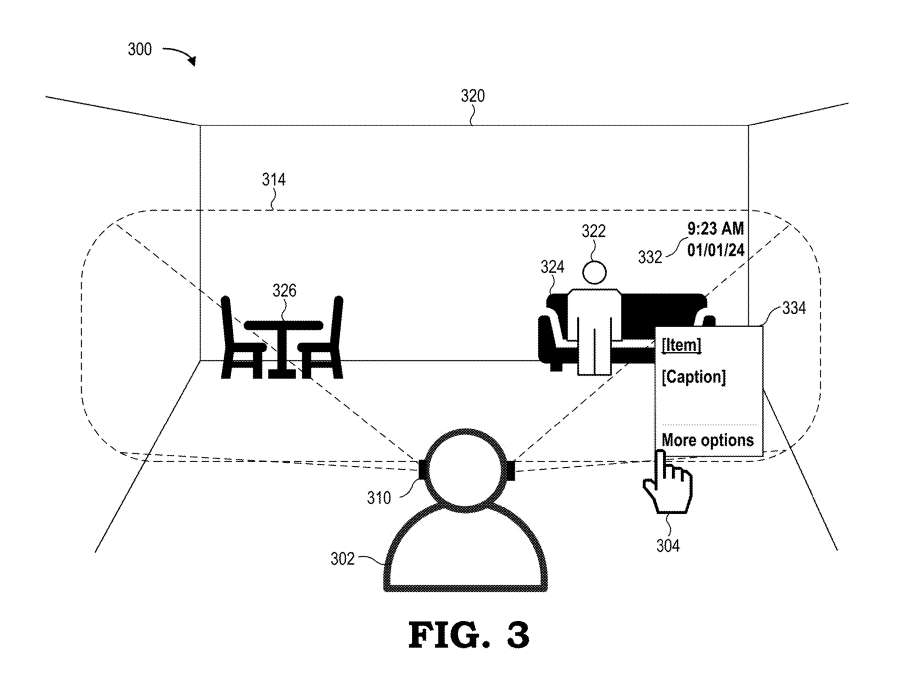

图3示出用户302佩戴近眼显示器310。用户302佩戴近眼显示器310,面向房间320(图3显示用户302后脑)。房间320中有另一人322坐在用户右侧的沙发324上,左侧有包含餐桌和两把椅子的餐组326。图3同时显示视场314的示例轮廓,用户302可在其中观察由图像投影系统产生的虚拟内容。

在图示实施例中,虚拟内容的一个例子是交互菜单334,其显示为不透明并覆盖在沙发324上方,从用户302视角遮挡了部分沙发。替代实施例中,近眼显示器310配置生成半透明虚拟内容(如交互菜单334),使用户302能透过虚拟内容感知现实世界(如沙发324)。因此近眼显示器310使用户302能同时观察现实世界与显示器生成的虚拟内容(如日期时间332和交互菜单334)。

......(全文 4177 字,剩余 3759 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限