所思即所得,Meta DINOv2深度学习可将大脑活动转化为相似图像

所思所看即世界

(映维网Nweon 2023年10月19日)在不久的将来,人机交互可能会超越触控屏和键盘,甚至超越眼睛和手势,最终实现真正的脑机接口。

除了马斯克的Neuralink,诸如Meta等巨头同样在积极探索相关的概念。由Meta和巴黎文理研究大学的研究人员日前发布了一个基于Meta开源模型DINOv2的新型深度学习应用程序Image Decoder,而它可以几乎实时地以将大脑活动转化为与被试所看或所思相似的图像。

简单来说,如果Meta研究人员坐在房间里,无法看到被试,或者说被试远在世界另一头。这时无论被试在看着什么或者在想什么,Image Decoder都可以根据正在接受神经扫描的被试的大脑活动来为Meta研究人员呈现相似的图像。

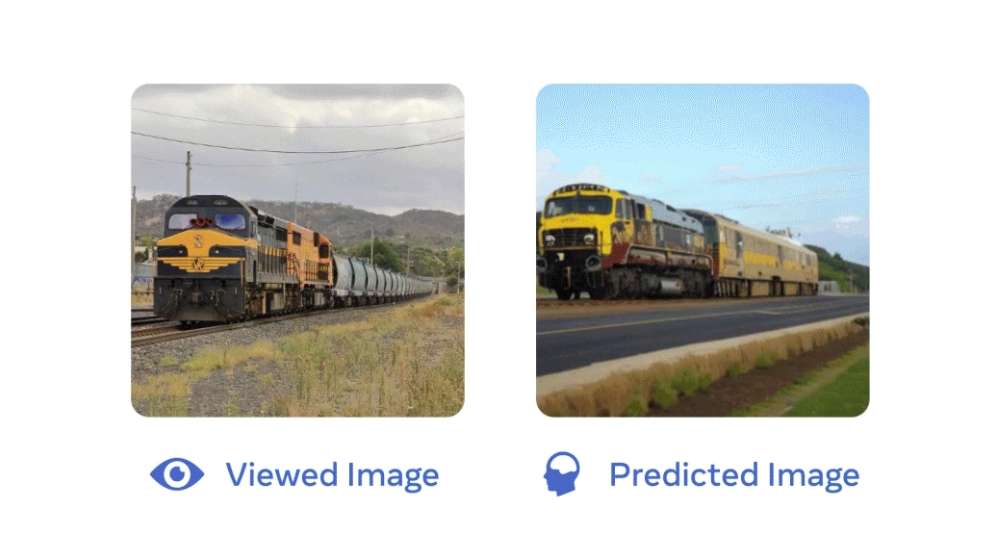

如下图所示,如果被试在看着(或想象)一节火车,系统就可以实时解读预测,并呈现出高度相似的火车画面。

利用每秒进行数千次大脑活动测量的非侵入性神经成像技术脑磁图(MEG),团队开发的人工智能系统Image Decoder能够以前所未有的时间分辨率解码大脑中视觉表征的展开。

......(全文 1110 字,剩余 743 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限