Meta为Quest MR体验推出Mesh API 和实验性Depth API

丰富MR体验中的交互,并生成更多的细节,提高用户体验的真实感

(映维网Nweon 2023年10月16日)Meta日前正式通过SDK v57推出了Mesh API (Unity | Unreal)和实验性版本的Depth API (Unity | Unreal)。这两个全新的功能可以丰富MR体验中的交互,并生成更多的细节,提高用户体验的真实感。

用Mesh API构建动态体验

Mesh API允许你访问Scene Mesh。这种环境的几何表示将物理世界重建为单个基于三角形的网格。Meta Quest 3的空间设置功能通过捕获房间元素来自动生成场景网格,而你的应用程序可以使用Scene API查询相关数据。

Quest 3的Scene Mesh提供了比Quest 2更细粒度的物理环境表示。当你访问用户环境的场景网格时,你可以用相关关键用例吸引受众:

- 生成精确的物理:对于在物理环境中弹跳的虚拟球体、激光、弹丸和其他物体等,快速碰撞可以从房间的详细表现中受益匪浅。Mesh API使得碰撞效果能够根据房间中的各种对象进行调整,从而创造出更逼真的体验。

- 导航和避障:查询Scene Mesh可以让你的应用程序知道障碍物在物理空间中的位置,这可以为AI导航提供信息并防止虚拟对象与物理对象相交。

- 精确的内容放置:能够以更高的保真度访问用户环境,使得用户可以自由地在更精确的位置放置和附加虚拟对象。

要开始使用Mesh API并学习如何获得物理环境的场景网格,请参考文档(Unity | Unreal)。要查看使用Scene Mesh的最佳实践,你同时可以在GitHub 查看演示应用《Phanto》的代码,如AI导航,碰撞和基于物理的交互等等。

用Depth API逼真地混合虚拟内容

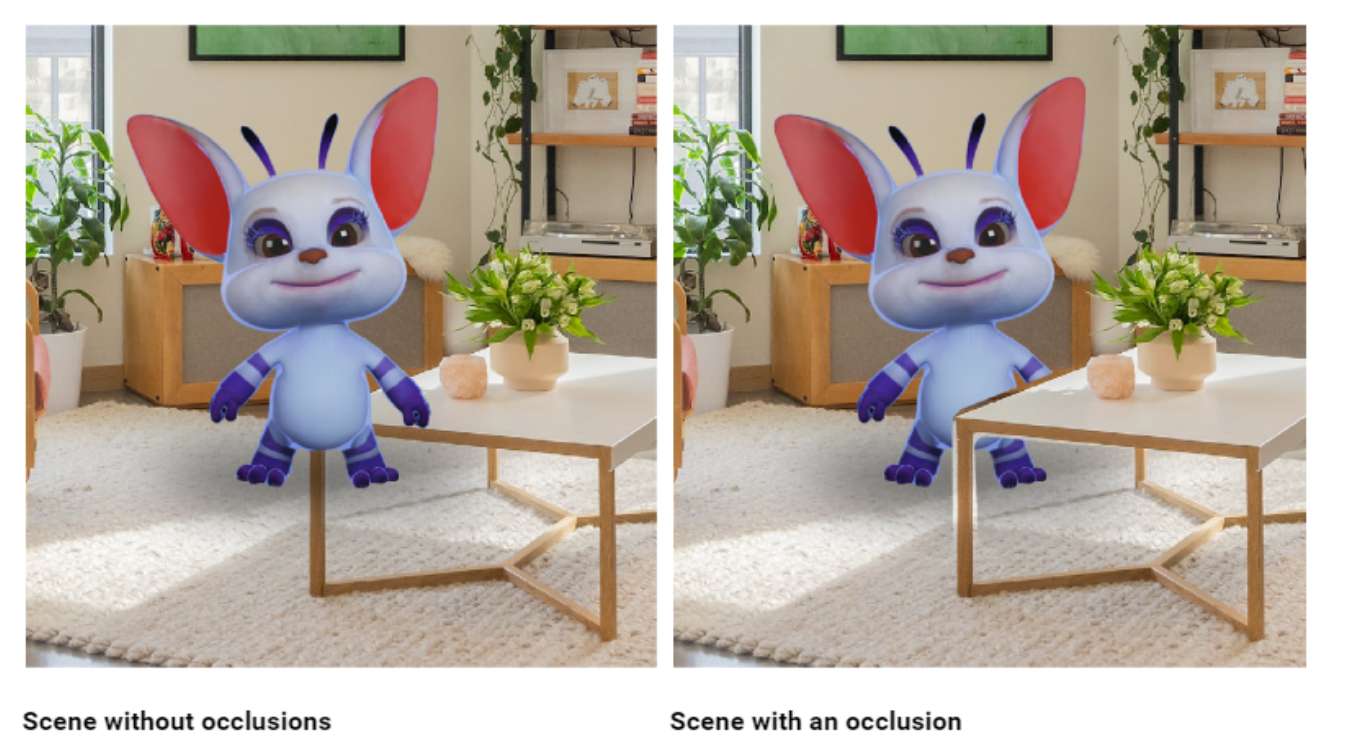

当你毛茸茸的四条腿朋友走到沙发的另一边时,你下意识地就会知道它在沙发后面,因为家具挡住了你的视线。在MR中,当一个虚拟宠物隐藏在一个实体物体后面,但应用程序没有办法适当地渲染它时,真实感就会立即受到影响。

现在有了Depth API,你可以解决这种类型的深度相关交互问题。它提供了对遮挡的支持,或者说能够准确地隐藏或掩盖物理对象背后的虚拟元素。

左边没有遮挡,右边有遮挡

通过使用Depth API,你现在可以支持快速移动对象的动态遮挡,比如虚拟角色、宠物、四肢等等,并帮助你解锁MR体验:

- 更流畅的社交和游戏体验,物理对象和人可以自由移动,而不会干扰房间内的3D虚拟对象。

- 创造性的基于深度效果,可以平滑过渡到背景环境,没有硬边界。

- 可信的手部交互和体验,鼓励人们用手操纵虚拟对象。

来自Meta Connect的演示展示了使用Depth API的体验。

为了构建真实的混合现实应用程序,你应该同时使用Depth API和Scene Mesh API,从而覆盖更广泛的用例。Meta建议采用以下流程:

- 步骤1:提示用户启动空间设置Space Setup以构建场景的表示。

- 步骤2:使用Depth API中的深度图来渲染基于每帧感测深度的遮挡,并使用来自场景的数据进行增强。

- 步骤3:如果需要,使用场景实现其他效果,如碰撞。

要开始使用Depth API,请访问文档(Unity | Unreal)。如果你是用Unity,请访问GitHub,以查找使用Depth API进行实时动态遮挡的示例。

开始使用Mesh API和Depth API的关键考虑因素

Mesh API和Depth API旨在利用Presence Platform的现有MR功能来支持涉及用户物理环境的动态交互。Depth API通过场景模型并使用注释来增强立体深度数据。为了获得所述数据,Meta建议启动空间设置Space Setup。尽管可以在没有场景理解的情况下使用Depth API,但团队建议在使用新功能构建之前熟悉掌握Scene(Unity | Unreal | OpenXR |WebXR)。