微软专利提出重建虚拟环境,允许远程多个角度查看AR设备视角

重建虚拟环境

(映维网Nweon 2023年08月11日)对于通过HoloLens与远程用户通信,你可以捕获对周围环境的视图,并将相关图像或视频传输给远程用户。但对于远程用户,你看到的视图仅限于AR设备的视角,即摄像头的位置和方向。这种有限的视角可能会导致用户花费更多时间来执行会议的功能,例如诊断机械问题,评估原型,为一件艺术品定价等等。

所以在名为“Re-creation of virtual environment through a video call”的专利申请中,微软提出可以重建一个虚拟环境,并允许远程用户从多个角度查看。

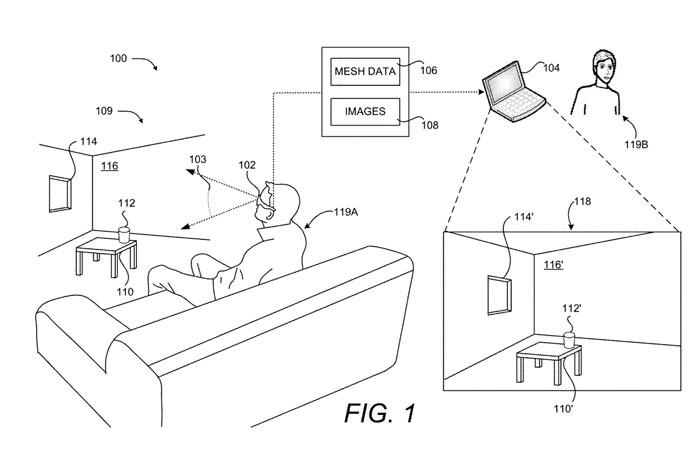

如图1所示,计算设备102与远程计算设备104交互。远程计算设备104可以是个人计算机或其他设备,而计算设备102可以是HoloLens。

远程计算设备104接收由计算设备102生成的网格数据106和图像108,并在UI 118中呈现图像108。通过这种方式,远程计算设备的用户119B可以看到计算设备102的用户119A所看到的真实世界环境109的视图,以及用于增强所述视图的任何虚拟对象。

图2是示出用户119B从第二视角203查看场景的3D表示218的计算系统图200,第二视角203不同于捕获场景的光学摄像头的视角103。如在3D表示218中所示,桌面210、虚拟杯子212、窗户214和墙壁216从第二个角度203描绘。

......(全文 3302 字,剩余 2902 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限