Meta Quest混合现实平台Presence Platform概述

Presence Platform平台概述

(映维网Nweon 2023年04月28日)Meta在2021年的Connect大会亮相了Presence Platform。这个拥有大量机器感知和人工智能功能的工具集旨在帮助你构建逼真的混合现实、交互和语音体验,从而在用户的物理世界中无缝融合虚拟内容。随着Quest Pro等越发先进的设备亮相,它们将能解锁全彩混合现实,并为Presence Platform的核心堆栈引入一个新的支柱:社交临在。

日前,Meta的娜维亚塔·芭瓦(Navyata Bawa)撰文再次概述了Presence Platform平台。

Meta的Presence Platform包括各种各样的功能,如先进的追踪和运动传感技术、高质量的图形和音频,以及直观的控制和界面,而它们可以共同创造无缝的沉浸式体验。除了为开发者提供一个构建创新应用的平台之外,Presence platform同时提供了帮助人们在虚拟空间中相互联结和互动的社交功能,包括语音聊天和共享体验。

下面我们来看看Presence Platform的功能和工具,这样你就可以为我们如何通过Meta Quest设备游乐、联系和工作构建未来。

1. 混合现实

Presence Platform为开发者提供了允许用户将物理世界和虚拟世界融合在一起的混合现实工具和功能,利用你的周围环境来解锁引人入胜的新体验。相关的混合现实工具可以允许用户同时看到虚拟和物理对象并与之互动,从而创造出更具沉浸感和吸引力的XR体验。

Presence Platform提供的基础混合现实工具有:Passthrough、Scene和Spatial Anchors。

1.1 Passthrough

Passthrough提供了物理世界的实时3D可视化。Passthrough API允许开发人员将Passthrrough可视化与虚拟体验集成在一起。在开发混合现实应用程序时,它可以允许你看到头显周围的环境。

自Passthrough推出以来,开发者已经建立了一系列非常酷炫的早期体验。但是,过往的体验都是黑白,所以下一步的发展显然是全彩Passthrough。借助Quest Pro等设备的先进传感器,开你现在可以构建允许人们在参与虚拟世界的同时,又保持物理空间中完整、丰富的色彩的体验。Meta对高级立体视觉算法的投资提供了更高质量和更为舒适的Passthrough体验,在特写和房间规模混合现实场景中可以实现更好的深度感知和更少的视觉失真。

Passthrough同时可以支持Meta Quest Link,允许启用Passthrough的应用程序在使用Meta Quest-Link时运行。这大大减少了开发启用Passthrown的应用程序时的迭代时间。开发者文档请访问这个页面。

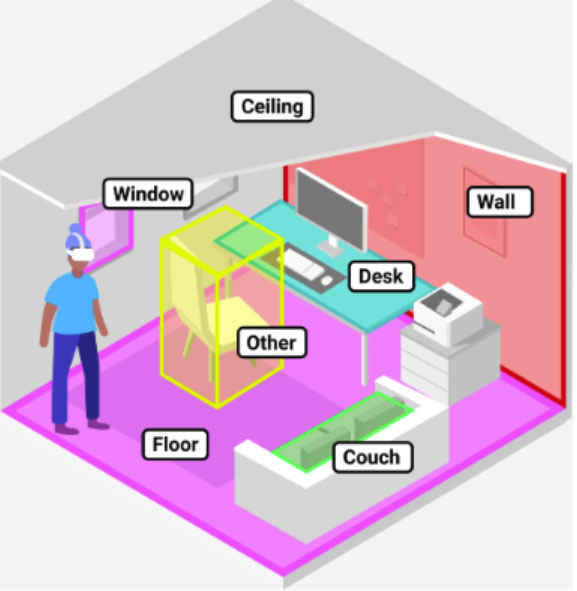

1.2 Scene

Scene允许你通过丰富的交互来快速构建复杂的场景感知体验。Scene包括两个重要概念:Scene Capture和Scene Model。

-使用Scene Capture,用户可以自由走动并捕获场景,从而生成场景模型Scene Model。

- Scene Model是物理世界的单一、全面、最新的表示,易于索引和查询,可提供用户空间的几何和语义表示,这样你就可以构建房间规模的混合现实体验。

Scene Model的基本元素是附着在几何组件和语义标签之上的Scene Anchors。例如,系统将用户的客厅组织在带有语义标签的各个锚点周围,例如地板、天花板、墙壁、桌子和沙发。每个锚点同时与简单的几何表示相关联:2D bounding box或3D bounding box。开发者文档请访问这个页面。

1.3 Spatial Anchors

Spatial Anchors空间锚点是世界锁定的参照系,可以用作原点来定位在会话中持久存在的内容。这种持久性是通过在特定六自由度姿势下创建一个Spatial Anchor,然后将虚拟内容相对于它放置。利用Spatial Anchors,开发者可以创建允许用户将虚拟对象留在特定位置,而且即便用户离开所述区域,相关对象都可以保持锚定在位置的应用程序。

Spatial Anchors同时允许多个用户在空间中共享一个公共参考点,这使得他们能够在协作和共享的环境中与虚拟对象和数据进行交互。对于通过为多个用户创建共享的锁定世界参考帧来构建本地多人游戏体验时,这个功能非常有用。例如,两个或两个以上的人员可以围坐在一张桌子,并在上面开玩一个虚拟棋盘游戏。开发者文档请访问这个页面。

2. 交互

Presence Platform为你提供了在构建沉浸式体验时利用自然输入控件的功能,例如双手、语音和控制器。相关工具包括Interaction SDK、Hand Tracking、Voice SDK、Tracked Keyboard和Audio SDK。

2.1 Interaction SDK

Interaction SDK提供了一个用于将控制器和裸手交互添加到体验之中的组件库,如Grab、Poke、Target和Select,而且其中包含了Meta Quest设备用户交互的最佳实践。对于裸手交互,Interaction SDK提供了特定于手的交互模型、姿势和手势检测,以及以手为中心的视觉可供性。开发者文档请访问这个页面。

2.2 Voice SDK

Voice SDK允许你在游戏中构建完全可定制的语音体验,并为开发者提供了一套工具、库和资源,从而将语音识别和自然语言处理功能添加到VR和MR应用程序之中。Voice SDK由Wit.ai自然语言理解(NLU)服务提供支持,并与Meta Quest头显、移动设备和其他第三方平台兼容。

利用Wit.ai,你可以轻松地训练应用程序使用语音命令,而无需事先掌握AI/ML知识。Voice SDK和Wit.ai的结合可以帮助你专注于应用程序的创意和功能方面,同时实现强大的语音交互。开发者文档请访问这个页面。

2.3 Tracked Keyboard

Tracked Keyboard SDK为用户提供了一种在VR环境中与物理键盘进行交互的有效方式。通过将用户的双手放在键盘的VR表示之上,所述SDK克服了虚拟键盘和盲打的限制。开发者文档请访问这个页面。

2.4 Audio SDK

音频对于创造沉浸式VR或MR体验至关重要。Meta XR Audio SDK提供空间音频功能,包括基于头相关传递函数HRTF的对象和双声空间化,以及房间声学模拟。Audio SDK支持的功能包括音频空间化、近场渲染、房间声学、环境声学、衰减和反射,以及更多供开发者尝试的实验功能。开发者文档请访问这个页面。

3. 社交临在

Presence Platform为你提供了构建高保真Avatar和在虚拟世界种创建真实联系干的工具和资源。这主要通过身体、面部和眼动追踪来实现,亦即Movement SDK。

Movement SDK for Unity使用身体追踪、面部追踪和眼动追踪来将用户的身体运动映射至VR,从而增强社交体验。使用相关追踪提供的抽象信号,开发者可以为具有社交临场感的Avatar设置动画,并提供超越Avatar的功能。开发者文档请访问这个页面。

若要开始使用Presence Platform,你可以下载Oculus Integration package。

值得一提的是,我团队已经制作了几个示例并托管至Github,以帮助你将所述工具和SDK集成到自己的应用程序中:

-The World Beyond:展示了Scene、Passthrough、Interaction、Voice和Spatializer的使用。

- First Hand:展示了Interaction SDK的使用和裸手追踪。

- Unity-Movement:展示Meta Quest Pro身体、眼睛和面部追踪功能的软件包

- Whisperer:展示了Voice SDK的使用。项目包含App Lab的《Whisperer》演示的源代码。

- Unity Shared Spatial Anchors:展示了Shared Spatial Anchors的创建、保存、加载和共享。