Meta研究员用神经网络重建视觉透视,带来高质量MR透视效果

尽管效果大有进步,但“未来的路途依然非常遥远”。

(映维网Nweon 2022年10月31日)诸如Varjo XR-3、Quest Pro、Lynx R-1等头显或是未来几年内体验增强现实的最佳方式。采用透明光学器件的传统AR头显(如HoloLen 2和Magic Leap 2)一般是通过波导显示器将AR元素直接投射到眼睛,而前述设备则是利用外置摄像头拍摄物理环境,然后再将其显示在不透明显示器。在这里,系统可以根据需要用AR元素进行扩展。

人工视线合成:一个大问题

上面所说的技术通常称为透视AR。尽管透视AR拥有一定的优势,但它同样存在挑战:当使用传感器数据重建物理环境时,如何令视图看起来像是用户在现实世界中用双眼看到的一样。

分辨率、颜色保真度、深度表示和透视等都必须与自然视觉印象相对应,并在用户移动头部时以尽可能少的延迟进行修改。

透视尤其给这项技术带来了巨大的困难,因为前置摄像头的位置与眼睛的位置不完全匹配。这种视角转换可能会导致不适和视觉伪影。

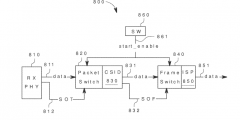

实际上,Meta的研究人员一直在研究相关的问题,并已在8月举行的Siggraphh 2022大会介绍了一项创新:使用人工神经网络重建视觉透视,亦即NeuralPassthrough神经透视。

......(全文 996 字,剩余 584 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限