微软AR专利提出基于用户输入确定用户注视焦点的方法

确定用户焦点

(映维网Nweon 2022年08月17日)计算设备可以使用不同类型的传感器来测量周围环境的特性以检测自然用户输入。自然用户输入允许用户以感觉直观的方式与计算设备交互,例如通过眼睛注视。

传统计算架构通常假设用户输入模式是明确的。为了基于来自这种精确模式的输入确定用户的焦点,处理可以依赖于传统的光线投射和命中测试技术。然而,这种光线投射和命中测试技术没有考虑到自然用户输入模式可能存在的传感器噪点和不确定性。因此,将光线投射和命中测试技术与此类自然用户输入模式结合使用可能会导致确定用户焦点的不准确。

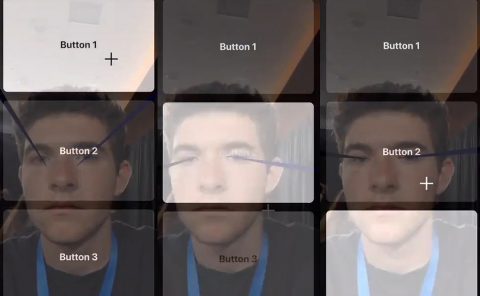

在名为“Intention image analysis for determining user focus”的专利申请中,微软提出了一种基于用户输入确定用户焦点的方法。在一个示例中,渲染系统用于生成包括多个交互对象的场景的意图图像。意图图像包括用基于用户的用户输入确定的意图值编码的像素。意图值指示用户意图聚焦于像素的可能性。意图图像中的交互对象根据交互对象具有用户焦点的可能性“亮起”。基于对应于交互对象的像素的意图值,为每个交互对象确定意图得分。

基于其相对于其他交互对象的意图得分,可以选择“最亮”的交互对象作为用户关注的对象。这种方法允许不将用户输入视为精确的点/位置,而是视为可能输入位置的概率空间分布。这允许使用噪点更大、精度更低的用户输入,从而提供用户焦点的准确确定。

......(全文 5970 字,剩余 5450 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限