微软专利探索眼球跳动误差,实现更精确HoloLens注视点交互

避免错误地将命令与目标对象以外的非目标对象关联

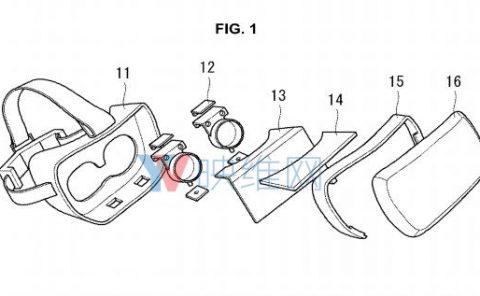

(映维网Nweon 2022年05月27日)随着眼动追踪技术的普及,眼动已经成为了AR/VR头显的一种重要用户输入机制。例如,眼动追踪传感器可用于确定用户眼睛的注视方向。然后,计算系统可以使用得到的注视方向来识别每条注视线相交的任何显示的虚拟对象。确定的注视方向随后可用于识别用户注视的对象。

通过这种方式,眼动追踪传感器可用于将由语音、手势、按钮或其他输入机制发出的用户命令与真实对象或虚拟对象相关联。

但是,使用眼睛注视来将命令与预期的真实对象或虚拟对象相关联可能存在困难。这在一定程度上是由于人眼自然进行的眼跳运动,亦即用户倾向于快速移动眼睛。例如,用户可能主要盯着一个感兴趣的对象,然后由于眼跳运动而短暂地瞥向场景中的其他对象/位置。如果仅根据检测到命令的时间将命令与对象关联,则可能出现错误地将命令与目标对象以外的非目标对象关联。

例如,HoloLens用户可能正在注视第一物理对象,并通过语音发出“放在那里”命令,从而将特定虚拟对象放置在所述第一物理对象。但由于眼跳运动,用户可能会在发出命令时短暂地注视第二物理对象。结果,计算设备或会错误理解用户意图,并将命令与第二物理对象相关联,从而无法将虚拟对象正确地放置在第一物理对象。

......(全文 2965 字,剩余 2469 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限