Meta专利提出减少AR/VR云渲染延迟技术

减少云渲染延迟的技术

(映维网Nweon 2022年05月10日)虚拟现实和增强现实都需要高沉浸感和高舒适度,但两者如同鱼与熊掌,难以兼得。在一定程度上,沉浸感和舒适度互为冲突,因为沉浸感越高,需要的性能就越高,所以设备就需要越大。反过来,优化舒适度或会导致性能下降。

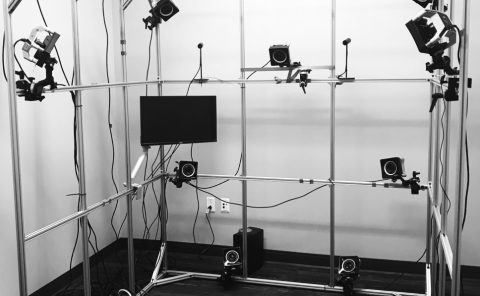

一个解决方案是云端渲染。但云渲染同样存在挑战。例如,全息影像的云渲染不是单纯的查看YouTube视频。除了是渲染拥有多达十亿个多边形的全息图之外,你同时需要与之进行交互。所以延迟问题变得十分复杂。

当然,行业依然在积极探索各种各样的解决方案。在一份名为“Latency-resilient cloud rendering”的专利申请中,Meta就提出了一种减少云渲染延迟的技术。

传统的云渲染方法使用服务器来执行所有渲染任务,并仅将最终视频流发送到客户端设备。但由于渲染过程和网络传输导致的延迟,当视频显示给用户时,服务器用于渲染视频的视点可能与用户的视点不同。所以视点的差异将表现为滞后,而当虚拟对象的几何结构复杂且网络条件差时,滞后将变得尤为明显。

......(全文 4406 字,剩余 4019 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限