苏黎世联邦理工学院提出gDNA,生成有详细皱纹和明确姿势控制的虚拟人

苏黎世联邦理工学院,图宾根大学和马克斯·普朗克智能系统研究所

(映维网Nweon 2022年04月27日)轻松创建各种高质量的数字人并完全控制其姿势的能力,这在电影制作、游戏、VR/AR、建筑和计算机视觉中存在大量的应用。尽管现代计算机图形技术实现了照片真实感,但它们通常需要大量的专业知识和大量的手动操作。

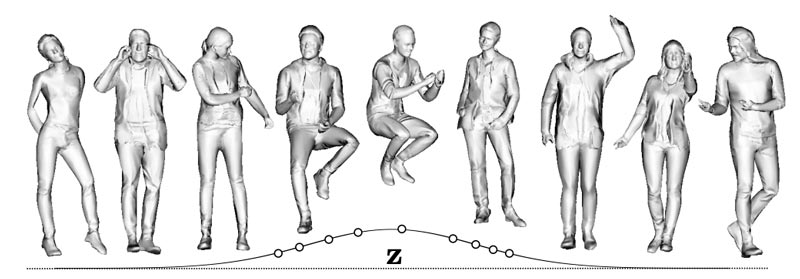

在日前公布的论文《gDNA: Towards Generative Detailed Neural Avatars》中,由黎世联邦理工学院,图宾根大学和马克斯·普朗克智能系统研究所组成的研究人员希望能够轻松创建详细的虚拟数字人。

团队的目标是通过学习一个generative model of people模型,从而帮助社区广泛访问3D虚拟数字人。为了实现这一目标,研究人员提出了一种方法,而且它可以:

- 生成不同的3D数字人

- 具有不同的身份和形状

- 以不同的服装风格和姿势出现

- 逼真且随机的高频细节,例如服装褶皱。

......(全文 3270 字,剩余 2960 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限