苹果专利为AR/VR演唱会提出传送多摄像头交互式内容的解决方案

选择性下载和处理机位录制内容,而不是完整下载和处理所有机位录制内容

(映维网Nweon 2022年03月29日)随着AR/VR的兴起,人们畅想的一个用例是足不出户就能身临其境地参加各种活动,比如说音乐会。对于所述情景,可以在音乐会现场使用多台摄像设备来录制内容并生成XR环境。以这种方式,即便没有亲自出席,AR/VR用户都可以通过相关体验来获得一种身临其境的感觉。但由于网络和处理能力等多方面的限制,如何有效交付多摄像头内容成为了厂商需要解决的一个问题。

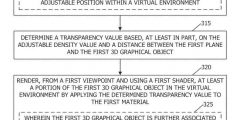

在名为“Efficient delivery of multi-camera interactive content”的专利申请中,苹果就介绍了一种用于更有效传送多摄像头交互式内容的方法和系统。

在各种实施例中,在物理环境中捕获内容的录制设备可以确定其在物理环境中的位置,并在可用于流式传输录制内容的清单中对其位置进行编码。然后,基于录制内容呈现XR环境的设备可以使用编码位置来确定是否基于用户在XR环境中查看内容的位置来流式传输录制内容。

以音乐会作为示例,如果用户尝试在XR环境中的音乐会舞台附近位置查看内容,则呈现设备可以下载于音乐会舞台附近录制的内容,因为所述内容可能与用户的当前视场相关。作为对比,在远离音乐会舞台位置所录制的内容可能与用户的当前视场无关,所以呈现设备可以基于所述内容的编码位置来确定不下载内容。

......(全文 3523 字,剩余 3023 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限