融合ToF+NeRF,Meta提出TöRF,实现更优动态场景视图合成

视点合成

(映维网Nweon 2022年03月09日)新视点合成(Novel-View Synthesis;NVS)的目标是从新视点逼真地渲染图像,并且长期以来都是计算机图形学和计算机视觉领域的一个重要挑战。

给定从不同视点拍摄的大量图像,系统可以推断场景的几何结构和外观,并以新camera姿势合成图像。与NVS相关的一个问题是,它需要一组来自不同视角的不同图像以准确地表示场景。这可能涉及在静态环境中移动单个摄像头,或使用大型多摄像头系统从不同角度捕获动态事件。

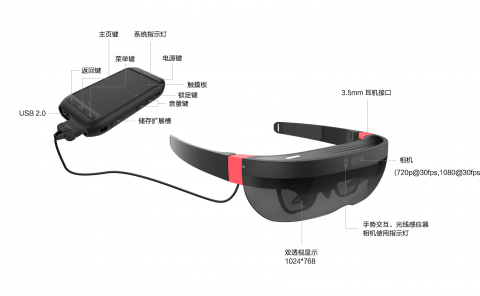

单目视频序列中的动态NV技术展示了令人信服的结果,但由于具有不适定性,它们出现了各种视觉伪影。这需要在动态场景的深度和运动方面引入先验知识。同时,移动设备现在搭载了带有颜色和深度传感器的摄像系统,例如微软的HoloLens,以及iPhone和iPad Pro中的前后RGBD摄像系统。

深度传感器可以使用立体光或结构光,或者越来越精确的飞行时间测量原理。尽管深度传感技术比以往任何时候都更加普遍,但一系列的NVS技术目前都没有利用这种额外的视觉信息源。为了提高NVS性能,卡内基梅隆大学、布朗大学、康纳尔大学、巴斯大学和Meta的研究人员提出了TöRF。

......(全文 3446 字,剩余 3026 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限