微软专利分享HoloLens通过光线投射与远距离对象进行交互的方法

用于远距离对象的交互

(映维网 2021年12月23日)允许用户在AR/VR应用中与3D对象进行自然交互具有优势,因为它对应于用户与现实世界中对象的交互方式。但是,与手臂够不着的3D对象交互可能十分困难。对于这种情况,特别的“超自然”交互方法可能更为适合。

另外,尽管近距离交互可以用手直接操纵全息图来实现,但用户必须能够与距离用户较远的全息图进行交互。理想情况下,这种远距离交互应该以某种方式与近距离交互体验相结合,并且应该对当前的目标方向和选择状态有明确的启示。

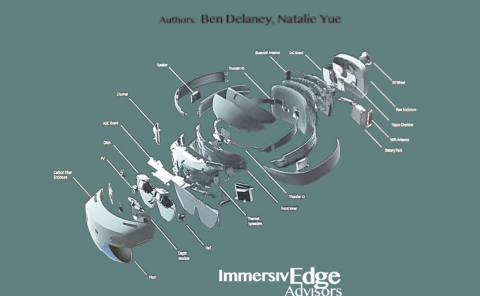

在名为“Holographic palm raycasting for targeting virtual objects”的专利申请中,微软提出了一种用于通过光线投射来与远距离对象交互的方法。

光线投射是各种超自然交互方法常用的方式。例如,可以从用户的手部或头部投射各种虚拟光线,从而便于用户与远处对象进行交互或显示为手臂够不着的对象。

......(全文 3073 字,剩余 2751 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限