影创孙立解读:2022年下一代Quest将开启VR新里程碑

查看引用/信息源请点击:映维网

影创科技孙立剖析下一代Quest

(映维网 2021年11月10日)在10月底,已经改名为Meta的Facebook公司举行了一场可能是迄今为止最糟糕的Connect大会——不厌其烦的Metaverse和隐私论调让很多会议观看者大为吐槽。尽管如此,考虑到会议开始前有关“Quest Pro”的爆料,这场会议可能深藏了一个全新的VR时代,抛出了下一代一体式VR头显的技术发展方向,也铺垫了下一个VR市场发展目标。

Meta(Facebook)宣布将在2022年上市下一代Quest头显,该头显在光学显示、MR功能、手部交互、手柄控制器定位追踪等方面应该会有重大的变化。为了更深度地解读下一代Quest头显,映维网与影创科技创始人孙立先生进行了深度探讨。孙立表示,影创科技一直在积极关注Meta公司的AR/VR前沿技术,同时为了跟进这一领头羊的步伐,影创科技也在积极研发相关前沿技术。

以下是映维网与孙立先生的对话整理:

映维网:从产品技术的角度,你怎么看今年的Facebook Connect大会?

孙立:其实AR(Project Nazare)、VR(Project Cambria)两个东西都发了,但可以看出AR还是更遥远的产品。扎克伯格在几年前的采访中也说过,如果要实现轻薄型AR眼镜,可能还需要十年。所以在AR上,并没有往真正量产的产品化(消费向的产品化)方面去做。

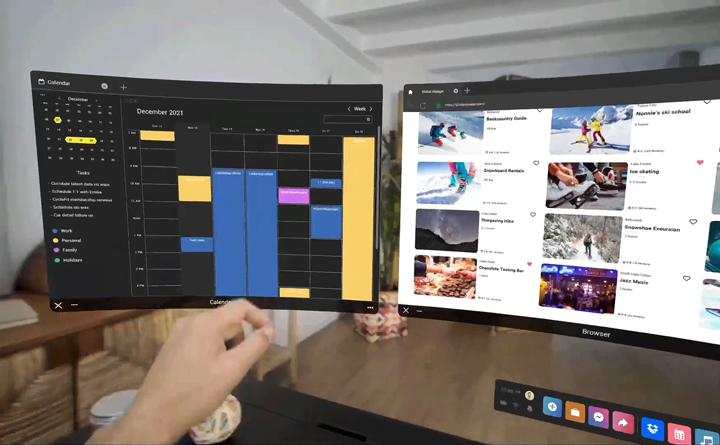

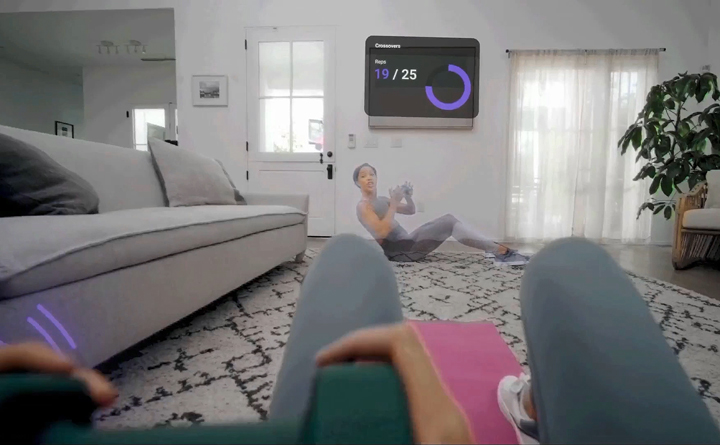

对于VR,目前已经做到了一个近千万级的年销量,再加上现在也能充分运用VR产品上的Camera做See-Through。这次大会的VR产品对See-Through的探索非常强烈。通过See-Through,它可以实现部分AR功能。从这次大会可以看出,Meta致力于把整个 VR产品变成一个生产力工具,变成一个效率工具,而不仅仅是一个娱乐游戏工具。一旦成为效率工具,销量就会得到更进一步扩张,变成电脑/手机级别这样的平台。

接下来,我认为Meta公司会把主要消费级产品放在See-Through的VR产品上面,同时继续做AR技术的探索,直到AR可以做到真正轻便的时候。现在,无论从任何的技术角度、电池角度、光学角度,AR眼镜都做不到普通眼镜大小,在这样的情况下,这东西就不太可能变成一个真正的消费级产品。

所以,AR这条路是继续探索,VR这条路是通过See-Through的方式实现AR。

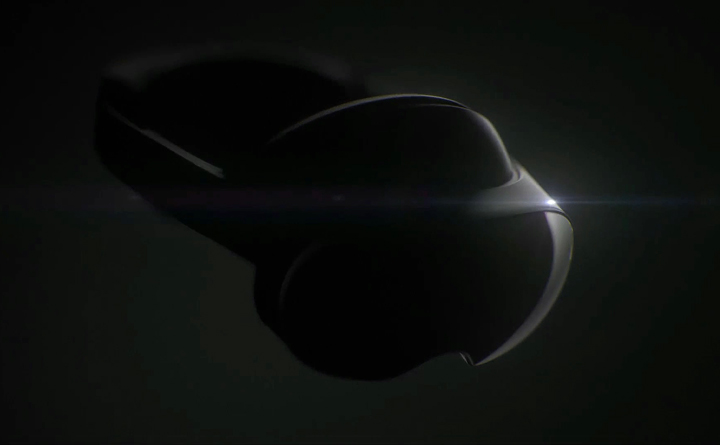

映维网:这次大会演示了代号为Project Cambria的下一代Quest VR头显。但从演示视频可以看出,它跟会议前泄露的图片效果图等基本一致。虽然我们知道的还非常有限,但从技术的角度,你会如何评价这么一款设备?

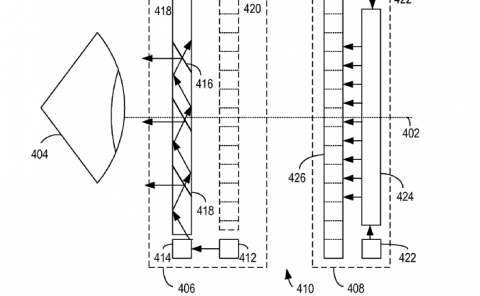

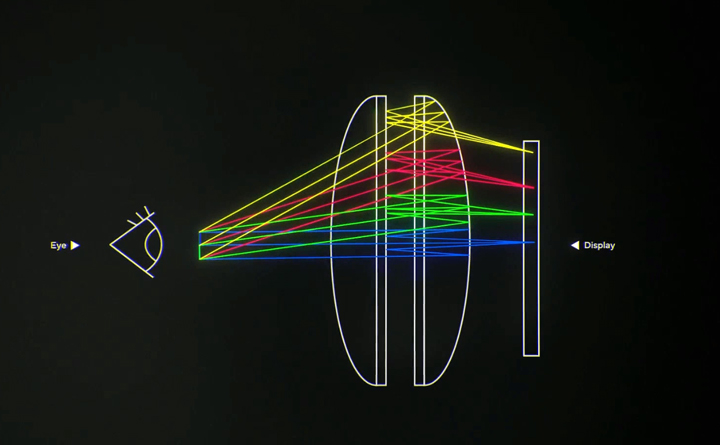

孙立:其实在这之前,我们也有得到一些消息,对这款产品还比较了解。先从技术角度,它是款很典型的Pancake光学VR设备,会上也展示了光学图,这种光学设计的好处就是可以让眼镜变得更薄,从七八厘米变成两三厘米的厚度。我们做头显这么长时间,很清楚整体尺寸最占设备重量,而不是说某个光学器件更会占重量。如果产品做得比较厚,外壳要把整个包裹起来,其中结构件的重量就会比较重。一旦体积给减少了,重量就可以大幅下降。

Pancake光学方案也带来了人体工学的改进,它这个人体工学和我们的“骐骥”非常像,这也是我们探索这么多年来最为舒适的一种佩戴方式。它不是通过勒住你的脸颊,而是像帽子一样通过额头和头部的环式佩戴。Quest 2其实是用橡皮筋勒的方式,不加舒适套件的话,对脸部的压力还是比较大。用这种额头和环式的佩戴方式,即便有更大的重量,佩戴体验效果也要比Quest 2更好。以前别的厂商也出过这种Pancake光学的设备,但是是用眼镜的佩戴方式。眼镜佩戴方式有个问题,就是鼻梁要受力。人类的鼻梁受力能力其实不太行,一个戴眼镜的人如果戴稍微重点的眼镜,压着鼻梁就会不舒服。

从技术角度,更加重点的是,它这次用了全新的See-Through方案。从公布的视频看,它能够彩色地看到外面的世界,而且本身彩色的还原度以及这个色彩下的清晰度、分辨率,看起来都比较高。虽然只是个视频示例,但Facebook应该不会做太假的视频示例。如果真是视频里那样,那么它在See-Through算法上做了非常多的功夫。一般来说,实现这样高清的See-Through,需要用到两个RGB Camera。之前有消息称,它是用一个RGB Camera和两个灰度Camera,做重构渲染,但这样的方案应该达不到视频里的效果。如果要达到视频里的效果,应该需要用两个RGB Camera,所以我觉得它很可能用了两个广角RGB Camera。

另外,因为它头显上已经有两个RGB的Camera,所以不太可能再用四个常规的灰度相机/红外相机去做手柄的追踪。如果这样做,就会有六个相机,整体功耗(很大)就不太科学。从之前的泄露图以及这次视频可以看出,它的手柄产生了巨大变化,不再是由头显对手柄进行定位追踪,而是由手柄上自带的三个或者多个Camera进行自我追踪,每个手柄都能自己做SLAM。也进一步表明,Facebook在计算机视觉领域做得越来越深,优化得越来越好。在这样的结构下,因为可以做See-Through,就可以有更大范围的活动,让人在一个更大的场景里走动。你可以把你整个家、整个房间、整个环境,作为虚拟跟现实的结合。这样对SLAM的要求也会更高,因为它不再是原来几乘几的活动范围,而是在划定一个范围后可变成一个开放空间式混合现实体验。

我认为这些就是Facebook这一代Quest头显的重要技术和一些改进。

映维网:刚有提到Pancake光学带来的外形尺寸变化,重量可以降低很多。目前Oculus Quest 2的重量是503克,你觉得下一代Quest会有多重?

孙立:从视频我们可以看出,下一代Quest应该是把电池后置了,整个头环的重量估计会有200多克,前面的重量可能可以下降到100多克,整个产品我认为会在400克左右。如果用的材料好一点,可能可以做到380多克,如果要降低成本,可能会稍微略重一点,但无论如何实际上的佩戴感受都会有大幅的提升。第一前后配比的重量,第二环视的佩戴,这两种方法可以让整个佩戴感受会更加舒服。

映维网:刚提到这次大会演示的MR视频效果,从黑白变成彩色,这有什么挑战?

孙立:其实整个挑战是一整套系统架构,而不仅仅是色彩一个挑战。

Quest的四目灰度相机既要做SLAM,也要追踪手柄控制器。这些灰度相机有一个“长短曝”的功能,第一帧长曝光能够做SLAM,第二帧短曝光能够追踪手柄——在非常短的曝光时间里配合手柄上的灯环点亮。

但如果要用RGB相机的话,首先RGB本身就不能够很好地识别红外光。一般来说,RGB是要给人看的,人眼又看不到红外光,所以它一般都会加一个红外滤光片,这样才能够把色彩还原到人眼。这种情况下,RGB相机可以用来做SLAM,但不能用来做手柄追踪。对于SLAM,需要支持全局曝光的RGB相机,而不是普通卷帘逐行曝光的RGB相机。对于手柄追踪,手柄控制器就必须要有自己的追踪系统。

初步分析,用两个RGB相机就可以做到一个比较不错的SLAM效果,因为这两个RGB相机相对来说会比较广角。为什么这么讲,因为它不仅仅要做SLAM,还要做手势追踪。对于手势追踪,RGB相机要比灰度相机更好,具备更好的鲁棒性,因为它会得到更多的色彩信息,所以可以做到更加精准的手势识别和追踪。

从技术难度上,这个变化带来的主要挑战有两块:摄像头位置扭曲和延迟。

摄像头位置扭曲,也叫CPW。因为摄像头和人眼不在同一个位置,但又要把它模拟到人眼同一个位置,这就需要进行位置调整。这个调整不是二维的调整,不是简单的旋转或裁切就可以做到,而是一个三维的调整,要把里面的三维进行重构。

第二个降低延迟是个比较难的问题。相机本身具备一定物理延迟,灰度相机的延迟在十几毫秒左右,传统RGB相机的延迟在三十毫秒左右,比如iPhone的RGB相机。物理延迟天然存在,要怎么把RGB相机的物理延迟做到非常低呢,这里会用到两个技术:重构和预测。

预测基本就是用ASW来做,对每一个像素点进行像素点的矢量运动估计。当你移动的时候,你会得到两个帧,通过这两帧的帧差,能够预测出下一帧。比如说,一个杯子在你正前方,然后你头往左转,杯子就会往右偏,它第二帧就是往右偏了一点,第三针可以预测它应该还会再往右偏一点。

通过这种线性预测,能够预测一两帧之间的这种可能性,但是光有预测还不行,因为预测是种不准确的方案,它只能降低人们感受上的延迟,并不能真正地降低纯物理世界的延迟,这时候就要用到三维重构技术。

我们在研究Quest See-Through的时候,已经可以明显地发现,它对整个三维世界是有一个重构过程,不仅仅是预测加上简单ATW的方式,而是把整个三维世界的深度信息给计算出来,利用这些深度信息重新把你看到的二维画面解算出深度缓冲区。

当你在运动的时候,因为延迟图像画面还没过来,就拿上一帧画面加上对上一帧画面的深度缓冲区,生成一张新的画面,就是三维重构后的二维反投影,投影到屏幕上。因为RGB相机的更大物理延迟,同样分辨率下,延迟一定会比灰度相机更高,这种情况下三维重构加反投影的方式就更加重要了。

Facebook在演示视频里大秀See-Through办公环境,在现实世界中打开多个屏幕,甚至可以在自己的办公桌上写字,这证明已经做到非常低延迟的效果。如果做得好,可以接近零延迟——可以理解为整个现实世界并不是被拍摄出来的,而是被渲染出来的。真实三维世界被拍摄出来,物理延迟天然存在,但如果把它重构并重新渲染,也可以把延迟降到接近零,只不过其中的算法确实非常难。

映维网:最近Facebook又发布了提高帧率新方法Application Spacewarp,它和Asynchronous Spacewarp有什么不同

孙立:Facebook把Application Spacewarp也称作ASW,这两个算法不仅名字类似,功能也类似。我猜测,Application Spacewarp其实就是之前Oculus Rift上的ASW 2.0,它是ASW 1.0和PTW的叠加。我们回到上一个问题,ASW1.0可以做预测补帧,但偶尔也会有一两帧的丢失,而ASW 2.0则可以填补这个丢帧问题,同时还可以让应用程序以低至一半的帧率运行。

假设在90fps的帧率下运行,理论上ASW 2.0可以为应用程序提供22ms的帧间隔渲染时间,即便去掉ASW + PTW的开销,估计依然会有13ms - 16ms左右渲染时间,相比ASW 1.0的原先11ms中只有9ms可用于渲染,ASW 2.0提高非常多。

让应用程序以低至一半的帧率运行,那么每一帧都要做一次补帧,而且这个补帧必须精准,不能是纯预测。这就需要结合PTW技术,通过计算最新位姿(位姿仍然是90fps来获取)与上一帧的差,再通过Z-buffer深度图对原图进行扭曲,最后再基于扭曲的结果做ASW 1.0,最终结果比只使用ASW1.0准确得多。

我一度以为Quest早就实现了这个功能,影创也早就在Tesseract系统上支持了这项技术,看来比Quest更早地应用到了实际产品中。

映维网:如果用同一套算法,只是从灰度相机改成用RGB相机,设备基于SLAM的定位追踪性能和效果会不会降低

孙立:同样的算法肯定会不一样。在RGB里面取特征和在灰度里面取特征,性能就会差很多。RGB信息量更大,如果你用同样的算法,它的延迟可能会变大,所以还需要额外的技术优化,来改善头部的定位追踪效果。

映维网:这些RGB相机还要提供See-Through透视MR功能,也会额外增加功耗。功耗问题也是促使手柄控制器转向自我追踪的原因之一吗?

孙立:是的,控制器需要更加低成本、低功耗,所以不太可能用RGB相机来做。

映维网:通过头显设备对手柄控制器进行定位追踪,和通过手柄控制器进行独立定位追踪,这两种技术方案哪个更有难度?

孙立:毫无疑问,手柄控制器的自我追踪更加有难度,更加有挑战性,这也是为什么一开始不这么做,现在才这么做。

首先,手柄控制器的自我追踪系统需要一定的算力和成本,我们不可能在手柄上搭载XR1或者XR2芯片去做定位追踪,这样价格就会很高。因此,需要用相对来说较为低端的芯片,而以前的低端芯片的算力又是不够的。现在,随着半导体技术的发展,一些中低端芯片也能很好地实现流畅的手部定位追踪。

其次,需要对手部和头部进行坐标系统一。如果手柄只是自己管自己,输出各自的相对坐标系,这个难度相对较小,但如何保证手柄的坐标系和头显的坐标系是统一的,这个就有难度了。

以前坐标系的统一比较简单,相当于把头显理解为一个参考系,然后在这个坐标系中用头显去追踪手柄控制器,把头显当做手柄控制器的坐标系零点。但是,现在系统不一样了,手柄跟头显之间没有了这种直接关系。

我们可以看到,下一代Quest的手柄背面应该有两个摄像头,正面看起来有一个摄像头。手柄应该需要通过摄像头或者说红外相机,对头显进行定位追踪,也就是说手柄在做SLAM之余还要找到头部的位置,然后进行三个坐标系的统一,也就是左手、右手和头。

这三个坐标系必须要达到非常完美的统一,否则就会很乱,你会觉得手柄跟头看起来不真实。你的眼睛在头上,你再去看手柄,如果这三个坐标系有偏差的话,你会看到左手可能偏右一点,右手可能会歪一点,这样的话体验就很不好了。

如何把这三个坐标系给统一起来,目前我也只能猜测。其中一种方式就是,手柄的正面摄像头可以拍摄头显上的一些特征点,可能是红外灯这种,在头显上布置红外灯。它不用实时匹配,只需每隔一段时间做一次,保证统一坐标系的准确性。比如,在识别1~2次或者初始化之后,接下来一段时间可能就不需要了,手柄可在任意位置移动,也不需要实时解算头显的位置,然后再过一段时间后,再统一一下坐标系。

这是一种可能的坐标系的统一方案。如果用这种方案,那么对于每一个SLAM个体的累积误差的要求就很高。我们都知道,SLAM会有累积误差,时间长了就可能会产生漂移。像手柄这种算力比较低的设备,漂移的程度可能会更加厉害。所以,要在手柄、头显三个坐标系的累积误差下做到统一,这个本身就是一个很大的挑战。

映维网:这种方案的转变,涉及额外的芯片和摄像头,Facebook也说它是一款高端头显,你预计最终产品定价会是什么价位

孙立:这个产品化以后,会是一个中高端的价格,可能是Quest 1的399美金价格。我们都清楚,Quest 2跟Quest 1在技术上没有啥区别,但是价格便宜了。再下一代Quest可能也会是这种情况,就是再迭代到Quest 4(可能是这个名字)也能做到Quest 2这样的299美金价格。

但是,后面可能会将手柄和头显拆开来卖,他们之前的采访反复提到过,如果减少手柄,可以大幅降低消费者入门门槛。现在Quest 2头显加手柄的官方标价是299美金,再迭代两代暂时叫Quest 4,那么它单头显可能可以做到199美金。头显本身只有两个RGB摄像头,比四个灰度摄像头更少,虽然RGB摄像头成本更贵一点,但也是稍微高一点,然后两个手柄还可以单独作为配件卖。

作为配件卖以后,主要操作方式就变了,变成了手势,手势可以作为它官方的标准输入方式,这样很多用户就不需要买手柄了,而只需要用手势就可以完成全部日常操作。这里的日常操作,也就是我们刚才前面提到的,下一代Quest的重点是要从游戏转向日常社交、办公,取代多屏、大屏电脑,走向更加日常化的使用。

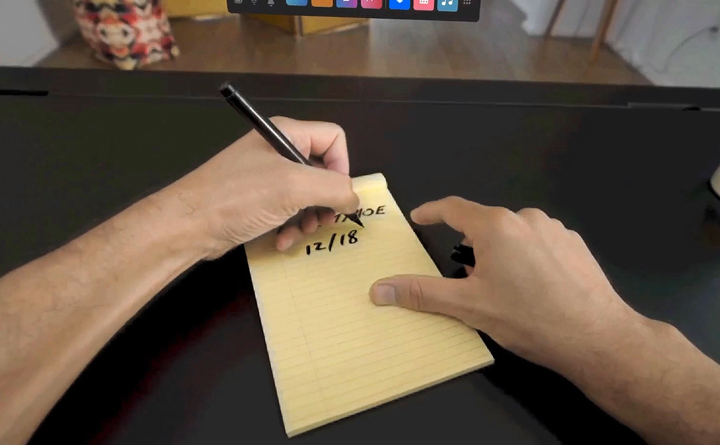

另外,它视频里还做了非常多的See-Through透视MR结合,比如说锚定键盘,甚至还可以用普通的写字笔做识别输入。我认为Facebook具备这种很强的CV能力,在常规的纸上写字,可以转化成AR/VR系统里的输入内容。

所以,它的单头显价格有望做到199美金的价格,把这两个东西拆开来卖,100美金卖手柄,199美金卖头显,这样产品的最小消费成本反而变低了,对于销量的提升反而有了帮助。整机价格最终可能会有些提高,但入门门槛其实降低了。当然,我同样认为这不太可能发生在下一代产品上。

映维网:刚提到因为色彩的丰富,RGB摄像头更有利于做手势识别,能再深入讨论下吗

孙立:从两个方面来讲,第一鲁棒性会更好。现在Quest 2用的灰度摄像头做手势交互,大部分情况下,已经非常不错了。我们影创也有手势交互的算法,最早就是在RGB摄像头上做,而且在RGB摄像头上做到了很好的鲁棒性,后来我们把同样的算法移植到了灰度摄像头上,发现鲁棒性差了很多。这个也很好理解,因为人的手有非常明显的颜色特征。

Quest 2透视

其实,手跟背景之间的颜色会非常影响鲁棒性,在灰度摄像头里很容易发生手部跟背景颜色相近的情况。因为本身并不识别颜色,背景哪怕不是皮肤的颜色,也可能看起来非常相近,只要色彩的灰阶和饱和度接近,就会非常相近。所以,这对算法是一个更大的挑战。

但在RGB摄像头里,除了跟皮肤颜色特别接近的背景,大部分颜色识别都可以做到非常好的鲁棒性。当时我们就觉得灰度的挑战性很高,后面我们也做了非常多的算法优化,能够在灰度摄像头下做到非常接近Quest的鲁棒性效果。

所以从鲁棒性来讲, RGB摄像头会比灰度摄像头更好,因为它提取的信息会更多,会更容易地去识别手部的姿态和动作。但是,这也反过来带来了负面影响,就是RGB摄像头的延迟会比灰度摄像头更高一些,因为同样分辨率下RGB摄像头需要传输的数据量会更大,可以理解为灰度摄像头只需要传输一个颜色通道,RGB摄像头则需要传输三个颜色通道。

如果只是用普通的传统手机的RGB摄像头,延迟都会比较高。所以,我们如果要做See-Through,一般会选用全局曝光的摄像头,降低它的运动模糊,降低它的本身延迟。

虽然Facebook也展示了可检测手部动作的手腕配件,但目前并没有真正实用。在手部没有任何传感器的情况下,手部的延迟就完全取决于摄像头带来的延迟,也没办法像头部一样正确预测手部的下一个动作(前文所说,头部可通过预测来降低延迟)。

总体而言,目前的手势延迟勉强够用,我相信它下一代产品即便用了RGB摄像头也不会太高于现在的整体延迟——应该在七八十毫秒的样子。新的RGB摄像头带来的额外延迟可能只有10毫秒,相对于七八十毫秒,10毫秒并不多。再通过算法的优化,可以接近现在Quest 2的手势延迟效果,但是鲁棒性会得到大幅提升。

这样一个情况下,我认为整体的交互体验会比现在更好。同样的延迟,更高的鲁棒性,我相信这个能做到。

映维网:从硬件角度,能不能通过高帧率的RGB摄像头来降低延迟

孙立:RGB摄像头的帧率其实蛮难做高,做高了功耗又上去了。在它既要做SLAM,又要做See-Through的情况下,它的帧率并不会特别高,我认为还是会在60Hz左右。

现在的手机不是都有慢镜头模式吗,可以开到120Hz,但如果真的开到120Hz,手机的发热就会明显提升,还有续航就会大幅下降。在现在的算力下,我认为120Hz没有必要。如果开到120Hz,每一帧时间的间隔就会变成9毫秒的样子(60Hz是16毫秒),间隔变短也会导致每一帧处理的时间变短,这样反而会造成综合负载提升。

现在真正的做法,在Quest 2上的做法,不管开不开See-Through,都可以用一个比较低的帧率,再加上三维重构来实现。也就是说,这个画面不是被拍摄出来的,而是被渲染出来的。我们可能会渲染60帧,然后再通过ASW+PTW做到120帧。

映维网:前面我们提到了那么多技术难点,你认为其中最难攻克的是哪个

孙立:我认为是See-Through。Quest 2上只是做了一个黑白的See-Through概念,可以是Demo。真正彩色里面的挑战,其实非常大。如果要做到它现在视频里的高清晰度,看到手在写字,看到家里的环境,做到这样的一个清晰度,对整个系统的要求会非常高,需要用到非常多的算法和优化器。我觉得,彩色RGB See-Through是整个新产品的最大挑战,这个也是我们预测苹果未来会推出的AR/VR产品里的非常重要的一个功能,而苹果可能会有更高的处理能力和更高的分辨率。

映维网:目前常规情况下,这种基于RGB摄像头的See-Through能做到多大的分辨率

孙立:正常来说,现在应该会在单眼1280×960这样的级别,这样才刚刚好够,允许我们去看一个相对来说比较清晰的世界,我觉得下一代Quest可能会是这样的一个分辨率。如果计算机要实时处理两个RGB的1280×960分辨率且帧率为60帧的信息量,负载已经很大了。如果我们把采样的帧率降低到30帧,通过重构的方式来进行插帧,这样也许会获得更高的分辨率,做到和屏幕匹配的单眼2k*2k也是可以的。当然,苹果可能会有更高的分辨率。

如果要处理更高的分辨率,至少目前的XR2算力还是很难实现的。当然,苹果可能会用它更强大的M1芯片,或者他们也为AR/VR专门做了芯片上的定制优化,我相信苹果可能会出一个更高分辨率的产品,但它不一定是直接一个这么高的分辨率。我也听说了一些传闻,说苹果是通过多相机的拼接,它的摄像头会比较多,通过这种拼接方式也有可能提升分辨率。但是,目前的芯片算力确实还是瓶颈,可能要到下一代XR芯片,整体的性能就可以再往上提一个档次。

映维网:这种Video See Through的MR方案对AR/MR行业会有影响吗

孙立:我们认为,在一段时间内MR会跟VR直接融合,这里的MR是指具备空间感知的设备,比如HoloLens和影创鸿鹄。这类设备会被VR的Video See Through覆盖,因为VR的Video See Through有更好的视场角体验。

大家都知道,无论是HoloLens,还是Magic Leap,还是国内一些产品,短期内MR设备(Optical See Through)再怎么做都不会有一个又轻便又大视场角提升。目前,只有VR的Video See Through方式,再加上Pancake光学,才能做到。

Optical See Through有一些天然的缺点,比如说处理遮挡的时候,处理黑色的时候,处理阴影的时候,Optical See Through就做不到,因为黑色不发光。如果你想显示一个区域的黑色,黑色在MR里又不发光,结果在光学透射里就变成了透明,没有办法正确显示一个黑色场景。但是,在Video See Through里,这个就可以非常好地克服,通过摄像头的捕获,屏幕里可以真的不发光,我们也看不到外界的光线,所以就成了真的黑色遮挡。

克服黑色可以带来更加真实的MR体验。我会发现,市面上所有MR眼镜(Optical See Through),不管HoloLens,还是Magic Leap,还是其他眼镜,在显示内容的时候都会有一种难受的漂浮感觉,虚拟的物体始终感觉是虚拟的,不是那么真实。这种感觉在iPhone ARkit里反而感受不到,ARKit更可以做出一些以假乱真的效果,这是Video See Through和Optical See Through的一种天然的感受。

Video See Through如果做的好,可以完全做到以假乱真。因为它可以实现更好的环境光渲染,可以实现更好的遮挡,可以实现更好的阴影。阴影非常重要,我们以前做游戏都知道,如果不给怪物加阴影,怪物看起来就会像是漂浮在屏幕上,但一旦加了阴影,就会感觉怪物是踩在地上。这样一个情况下,Video See Through的混合现实效果会更接近真实。

另外,Video See Through的价格也可以做得非常漂亮,我觉得VR Video See Through接下来会降维打击现在的Optical See Through MR,这是一个趋势。大家可以看到,现在市面上的MR眼镜都非常贵,HoloLens 3万多,Magic Leap 也很贵,即便是一些国产的眼镜,包括我们的MR眼镜,甚至都是1万以上的价格。但如果通过Video See Through的方式去实现MR效果,整个成本会降得非常低,就是一个VR眼镜的价格。下一代Quest,就算卖399美金,甚至是499美金,折合人民币也才3000多块钱。

所以,我认为VR + Video See Through会很大地打击Optical See Through的MR市场,我们影创从去年Q4开始,也全面转向VR + Video See Through的方案。

我们看到Facebook的研究,认为它一定会做到彩色Video See Through,一定会通过彩色Video See Through方案去挤压像HoloLens这样的这种MR应用。Facebook越来越多地在做一些以前MR公司在做的事情,跟工业结合,跟培训结合,跟教育结合。Facebook的进入,现在可以有更低的价格且更好的体验。我也深刻认为,这个事情马上就要发生,也是我对未来一段时间内MR和VR合二为一的一个判断。直到未来哪天轻便型的Optical See Through方案出现了,才可能会再次发生改变。

我觉得2027年、2028年可能是一个时间点,扎克伯格之前也曾预言,那个时候Optical See Through光学方案可能会变得真正的成熟。再比Pancake VR做得更加轻便的情况下,才会慢慢兴起。

还有一种,我们叫另类AR,有些公司把它定义为Assistant Reality(辅助现实),高通的定义里叫Smart Glasses(智能眼镜)。这样眼镜的市场,我认为会继续小规模存在,但不会有VR+Video See Through这样的一个更大规模的应用市场。这个东西不像是一个计算平台,就像有些公司给它的定义一样,就是个辅助产品,而不是一个全息显示的产品,也不是元宇宙的一个入口。

映维网:从更长远的技术发展角度,Optical See Through有没有可能做到显示黑色

孙立:我们也在研究这个方面,它是可以做到,比如用调整液晶的方式做遮挡,当显示黑色的时候,再给镜片添加一层额外的液晶,一种光栅性质的方式,对我们眼睛进行一些遮挡。

这个难度很高,并不是我们传统理解的在眼前遮挡一片东西就能够看不见了。你可以自己试一下,拿一小黑纸片遮到眼睛前,你会发现遮不住你的眼睛,除非把整个眼球都给遮住,否则你就会透过黑纸片看到背后的东西。因为光是从四面八方进来的,所以这个难度很高。它需要做一种类似于全息或者复眼显示的方式,才能够制作黑色的遮挡。

我看一些专利,包括我们自己的研究,传统衍射波导和HOE这种衍射光栅结构,我认为还需要时间,到2027年、2028年有可能能成熟,但用户不会等你,VR用户市场已经起来了,用Video See Through的方式去体验MR更切实际。

映维网:对于下一代Quest产品,Facebook也说了明年就要上市,预计这款产品会对VR行业产生什么样的影响

孙立:我认为,VR从大家所认为的小众垂直游戏娱乐市场变成了生产力工具,这个转变非常重要。

回顾电脑的发展历程,在个人电脑普及之前,雅达利这样的公司都在做游戏机,非常简单的打乒乓球那种游戏机,也已经卖出了一定的销量。但是,电脑市场的开始爆发是在苹果、IBM等推出了具备办公能力的个人电脑之后,其中典型的软件有电子表格VisiCalc,微软的Office三大套件。这些之后,电脑的销量才真正意义上爆发了。我认为VR也是一样,如果VR只是一个游戏机,那么它的销量一定是有限的,我们可以参考游戏主机市场的销量,每年Switch + PlayStation + Xbox也就几千万台的销量。

所以,既然我们认为VR、MR是下一代计算平台,那么它一定要能够给生产力带来提高,只有当它变成一个生产力工具之后,所有的人才会去用它,有足够多真正去用它的人之后,才会形成足够多的人和人之间的交流,才会变成一个大家愿意用的社交平台。社交平台需要有用户,你一个人上去就不叫社交平台了,所以它会先变成一种生产力工具,又通过它的通讯能力,包括Facebook一直在推的Workrooms这样的办公,后面又变成了社交平台,变成了元宇宙这样的一种迭代。

游戏是一个重要的功能,但不是大众消费者去买VR的刚需。现在大部分人买VR是为了玩游戏,这种VR的销量有限,但一旦买VR变成了买一种生产力工具,就会变成大家像买电脑一样自然,每个人家里都会有电脑,每个公司都会给员工配电脑,玩游戏反而成了一种额外的能力,这样才有可能变成真正普及的大众消费设备。我觉得这个过程非常重要,也是下一代Quest我认为将带来的一个革命性的改变。

映维网:关于下一代Quest我们已经讨论了非常多,这款设备也可能给我们行业带来重大的影响。那么,在这么一种行业发展趋势下,影创有在做哪些努力呢

孙立:正如我们刚才所讨论的一系列东西,我们影创也很早就开始在持续跟进。从去年Q4开始,我们就对下一代手柄做了相同技术路径的规划,也在今年推出了我们的6+6参考样机,现在我认为应该是国内最接近Quest体验的6+6设备。虽然我们以前主要是家做AR的公司,但从今年开始,我们的路线也非常接近类似Facebook,刚刚我们也讨论了VR、MR已经不分家了。

在这样的情况下,我们会更加全力地去攻坚所有跟VR+Video See Through方案有关的一系列技术,目前主要包括手势交互、自追踪手柄、Video See Through里的一系列非常重要的算法,比如ASW、PTW、重构等一系列算法。这些东西都是我们做MR、VR的积累的进一步提升,尤其是Video See Through的一些重要算法,都源自于我们做VR时针对帧率做插帧算法的要求。这些东西其实非常重要,但是国内很多厂商的技术研发都集中在光学,这种公司认为光学可能是最重要的。并不是说光学不重要,而是目前消费者能够感知到的并不在Optical See Through里面,因为这些东西的价格成本都太高了。

VR + Video See Through才是目前大众消费者能够去感知到的东西,当大家都用这样的方案,它真正重要的是显示效果,渲染的效果,能不能做到90帧,能不能做到低延迟。这些反而是我们非常容易忽略的。我相信我们接下来能把Video See Through做到全国最好。