Facebook开源3D重建数据集:Common Objects in 3D

这个大型数据集已托管至GitHub

(映维网 2021年09月06日)从远程呈现到模型生成,AR/VR在3D中重建对象是一个具有开创性的计算机视觉问题。得益于技术的进步,现在可以在传统智能手机和笔记本电脑屏幕、以及AR眼镜无缝融合真实和虚拟对象,从而驱动未来的体验。

然而,当前的三维重建方法依赖于各种对象类别(“汽车”、“甜甜圈”和“苹果”等)的学习模型,并且由于缺乏包含真实世界对象的视频和对象精确三维重建的数据集而受阻。因为模型依赖于所述示例来学习如何创建三维重建,研究人员通常只使用合成对象的数据集,而它们仅大致符合现实世界问题的挑战性性质。

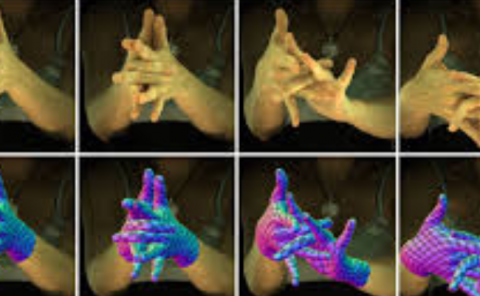

为了帮助解决这一问题并推动所述领域的进步,Facebook AI日前发布了一个大规模数据集Common Objects in 3D (CO3D)。它包含带有3D注释的常见对象类别的真实视频,近19000个视频提供了150万帧,涉及MS-COCO数据集中50个类别的对象。CO3D在类别和对象的数量方面都超过了现有的备选方案。

下面这个视频显示CO3D数据集中的真实对象和详细的3D重建。彩虹线显示了捕获视频的智能手机摄像头的轨迹。

......(全文 1351 字,剩余 962 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限