WWDC21大会AR汇总:ARKit 5、RealityKit 2、Visual Look Up

引入了一系列的功能和改进

(映维网 2021年06月08日)苹果于今天凌晨以线上形式举办了2021年WWDC全球开发者大会。这家公司带来了新版ARKit 5、RealityKit 2、Live Text、Visual Look Up。

ARKit 5

定位锚更多城市

ARKit是苹果最初在2017年WWDC推出的AR开发平台。利用这套工具,开发者可以为iPhone和iPad创建增强现实应用程序。最新的ARKit 5引入了一系列的功能和改进,从而帮助开发者构建比以往任何时候都要更好的AR体验。

现在,你可以在更多的城市放置Location Anchor定位锚,将App Clips或ARKit应用中的虚拟内容固定到打印或数字App Clip Code中,利用iPad Pro(第5代)超宽摄像头中的人脸追踪功能等等。

1. Location Anchor定位锚

Location Anchor定位锚允许你将AR作品锚定在特定的纬度、经度和高度。用户可以围绕虚拟对象走动,从不同的角度查看它们。现在,团队已经将Location Anchor定位锚定位锚带到伦敦和美国的更多城市,从而允许你为特定的地方创建AR体验,比如伦敦眼和时代广场。

注:这需要iPhone XS、iPhone XS Max、iPhone XR或更高版本,而且仅支持部分城市。

2. 扩展的人脸追踪支持

对人脸跟踪的支持已经扩展到任何搭载A12仿生芯片和更高版本的设备(包括iPhone SE)的前置摄像头。这样,更多用户都可以享受通过前置摄像头实现的AR体验。最新的iPad Pro(第5代)超宽摄像头同样支持人脸追踪。原深感摄像头一次最多追踪三张人脸并增强前置摄像头体验,如Memoji和Snapchat。

3. App Clip Code

App Clip Codes是人们发现你的App Clip和ARKit应用的最佳方式。它们独特的设计是“立即识别”,从而提供了一个快速和安全的方式来启动你的App Clip和ARKit应用。

现在,开发者可以将App Clips或ARKit应用中的虚拟内容固定到打印或数字App Clip Code中。这样当用户扫描打印或数字二维码时就能马上看到相关的虚拟内容。

ARKit 5已经正式发布,更多关于苹果AR开发工具的信息请访问苹果官网。

RealityKit 2

更方便创作高质量3D模型

RealityKit框架专门为增强现实量身定制,能够提供逼真的图像渲染、相机特效、动画、物理特效等等。借助原生Swift API,ARKit集成、基于物理的超逼真渲染、变换和骨骼动画、空间音频和刚体物理,RealityKit可让你比以往更加快速轻松地进行增强现实开发。

在今天凌晨举行的WWDC开发者大会中,苹果正式发布了RealityKit 2,带来Object Capture(对象捕捉),自定义着色器,自定义系统,动态asset和角色控制器等等。

RealityKit 2的新增内容包括:

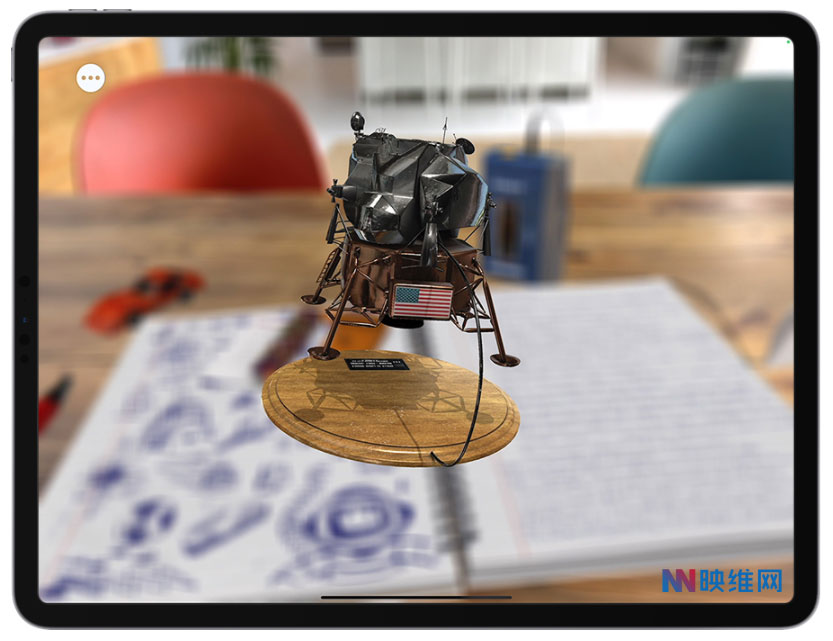

1. Object Capture 对象捕捉

利用macOS的Object Capture API,你可以将iPhone或iPad的照片转化为高质量的3D模型,并可在数分钟内实现AR优化。Object Capture使用摄影测量将在iPhone或iPad拍摄的一系列照片转换成3D模型,同时允许你在AR Quick Look中即时查看,或集成到Xcode项目之中。

2. 自定义着色器

RealityKit使用真实的和基于物理的材质、环境反射、背景阴影、相机噪点、运动模糊等等来将虚拟内容与现实世界无缝融合,以令虚拟与现实几乎无法区分。RealityKit2通过自定义渲染目标和材质提供了对渲染管道的更多控制,这样你就可以微调AR对象和场景的外观和感觉。

3. 自定义系统

你现在可以构建自己的Entity Component System,并在AR场景中组织资源和在系统层中构建更复杂的功能。

4. 动态asset

你现在可以启用可自定义的资源加载,从而能够更灵活地定制基于RealityKit的体验。例如,以编程方式使用每个帧更改图像或网格。

5. 角色控制器

开发者可以利用强大的Swift API轻松创建玩家控制的角色,这样你的用户就可以跳转、缩放和探索你创建的AR世界和基于RealityKit的游戏。

iOS15苹果地图

全新AR导航功能

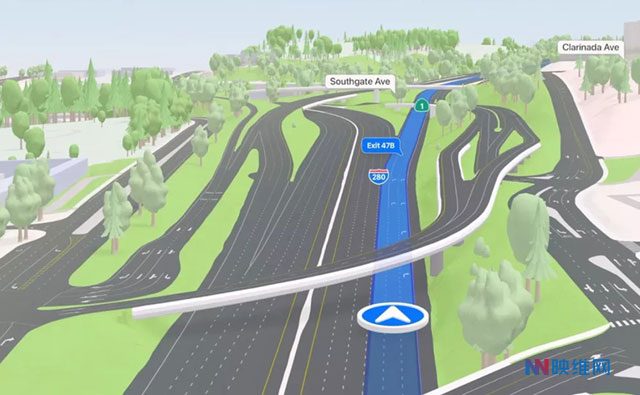

在今天凌晨举行的WWDC 2021开发者大会中,苹果表示iOS15将会为苹果地图(Apple Maps)带来全新的AR功能,从而提高这款原生导航应用程序之于谷歌产品的竞争力。

苹果地图的核心是地图本身,而它现在纳入了更丰富的高程数据和更多的道路颜色。在WWDC大会,苹果演示了关于旧金山科伊特大厦、渡轮大厦和金门大桥等地标的导航。

在上路时,用户现在可以看到详细的立体街道信息,包括车道标志、特殊车道(如自行车道和公共汽车/出租车车道)、人行横道等。公路和街道数据同样以3D显示,这样你在驾驶时就能够看到复杂的立交桥呈现等等。另外,利用苹果设备的高帧速率,苹果地图现在运行更加流畅。

团队指出,更详细的地图数据可以让司机更早地知道需要走哪条车道,从而提高安全性和帮助优化交通状况。

值得一提的是,苹果地图同时增加了提高步行和搭乘公共交通便利性的新功能。例如,用户可以将附近的公共交通站点和车站信息锁定到iPhone和苹果手表,并在乘车和公交接近站点时接收自动更新和通知。

在步行方面,全新的增强现实功能允许用户用iPhone的摄像头扫描相关地区附近的建筑物,从而确定自己的精确位置并获得更准确的步行方向。当然,相关信息将在增强现实视图中呈现。

苹果表示,这项功能将于2021年在部分城市推出,并在明年登陆更多的城市。

Visual Look Up

理解真实世界物体

谷歌的Google Lens已经成为最有用的增强现实应用之一。对于今天发布的iOS 15,苹果同样不甘人后。这家公司宣布,Live Text(实时文本)和Visual Look Up(视觉查找)将登陆iPhone。可以说,这两个应用工具都是直接对标谷歌的Google Lens。

1. 将手写文本或打印文本转换为数字文本

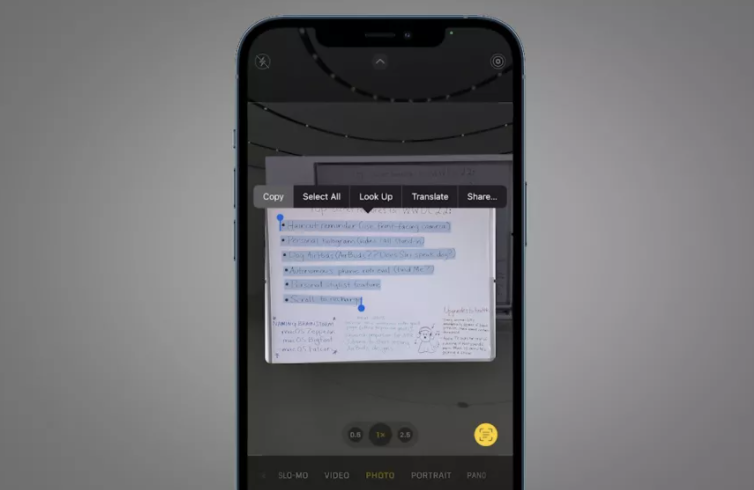

Android手机用户已经相当熟悉,而现在iPhone用户同样可以便利地通过Live Text(实时文本)将手写文本或打印文本转换为数字文本。苹果指出,所述功能是基于采用机载处理的“深层神经网络”,而不是基于云计算的方法。

在一个演示示例中,你可以对准办公室白板的便笺,点击相机应用取景器右下角的新图标,然后扫使用常用的文本选择手势(将手指拖到文本)就可以将手写文本复制到电子邮件或便笺应用中。

你同时可以对图库中的现有照片使用Live Text(实时文本)。在一个演示示例中,苹果以数字方式复制了一张旧照片的餐厅名字和电话号码。

苹果的Live Text(实时文本)的局限性要大于Google Lens,毕竟后者从2017年就已经与大家见面。目前,苹果表示所述功能只支持7种语言(英语、中文、法语、意大利语、德语、西班牙语、葡萄牙语)。相比之下,Google Lens支持100多种语言。

尽管目前尚无法与Google Lens相提并论,但对于苹果的相机应用而言,这是一个相当有用的新功能,而且它适用于所有类型的照片,包括屏幕截图和网络照片。

2. 搜索真实世界

尽管苹果在WWDC 2021期间没有深入演示Visual Look Up(视觉查找),但这个功能可允许系统自动在照片中查找信息,比如狗狗的品种或者花朵的类型。

这家公司指出,所述功能适用于书籍、艺术、自然、宠物和地标,但具体的支持范围有待观察。考虑到搜索巨头谷歌能够从服务中收集到堆积如山的数据,所以苹果要想在这方面与其竞争,这无疑是一件棘手的事情。

不过,尽管这一功能在一开始可能存在限制,但这一举动或许是为传闻中的苹果眼镜铺路。自动识别视觉信息是任何智能眼镜的一个重要组成要素,而Visual Look Up(视觉查找)可以为日后的苹果眼镜奠定基础。

Visual Look Up(视觉查找)适用于iPhone、iPad和Mac。用户只需更新到最新的软件,你就能尝鲜使用。预计iOS 15的完整版本将在9月中旬左右推送。