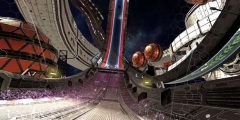

Facebook提出Pica模型,为Quest 2带来实时逼真虚拟化身渲染

(映维网 2021年04月20日)就如同个人计算机和智能手机在过去四十五年里(并正继续)改变了世界一样,Facebook坚信增强现实和虚拟现实将成为未来五十年里我们工作、娱乐和联结的主要方式。

为了克服人与人之间,以及人与机会之间的物理距离挑战,团队正在积极开展一个名为Codec Avatars的项目。Codec Avatars旨在利用突破性的3D捕获技术和人工智能系统,从而帮助人们在未来快速轻松地创建逼真的虚拟化身,并令虚拟现实中的社交联系变得如同现实世界般自然和常见。

日前,Facebook公布了一份即将在今年6月计算机视觉与模式识别大会(Conference on Computer Vision and Pattern Recognition;CVPR)介绍的论文。

简单来说,只对屏幕空间中的虚拟化身的面部可见像素进行解码,可以在计算受限的平台实现高保真的面部动画。

......(全文 1330 字,剩余 1020 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限