iPhone12 Pro完成了谷歌的使命,为苹果AR眼镜铺平道路

查看引用/信息源请点击:cnet

(映维网 2020年10月20日)还记得Google Tango吗?苹果正在大力押注LiDAR激光雷达技术,所述技术成为了iPhone 12家族的全新技术,尤其是iPhone12 Pro和iPhone12 Pro Max。如果能够成功,激光雷达LiDAR将成为一个你会经常听到的术语。

1. LiDAR是什么意思?

LiDAR是Light Detection and Ranging的缩写,亦即激光探测与测距。这项技术已存在一段时间。它主要是发射激光,接收从目标反射而回的信号,然后计算激光脉冲的传播或飞行时间来测量距离。

2. LiDAR如何感测深度?

LiDAR是一种飞行时间摄像头。有些智能手机是通过单个光脉冲来测量深度,而采用LiDAR技术的智能手机会以一束红外光点的形式发出光脉冲波,然后用传感器测量每一个光波,从而形成一个能够映射距的点场。光脉冲对人眼不可见,但你可以用夜视摄像仪看到它们。

3. 这不就是iPhone的Face ID吗?

是的,但它的覆盖距离更远。原理一致:用于Face ID的原深感摄像头同样能发射出一束红外激光,但它只支持数英尺的距离。iPad Pro和iPhone12 Pro背面的LiDAR激的工作范围是5米。

4. LiDAR已应用于其他科技领域

LiDAR是一种正如同雨后春笋般在各个领域兴起。它可用于自动驾驶汽车或辅助驾驶;它可用于机器人和无人机;诸如HoloLens 2这样的增强现实头显有采用类似的技术,从而在将3D虚拟对象叠加到现实世界视图之前实现空间的映射。但这项技术的存在已有一段相当长的历史。

微软原来的Xbox配件Kinect同样有搭载红外深度扫描功能。事实上,在2013年被收购的Primect有份参与Kinect技术的开发。来到今天,苹果手机前置了原深感摄像头并后置了LiDAR传感器。

5. LiDAR可以提升iPhone12 Pro的摄像头性能

飞行时间摄像头能够提升智能手机的拍摄聚焦精度和速度,而iPhone12 Pro不会例外。苹果承诺更优秀的低光聚焦,低光条件下高达6x的速度。另外,LiDAR的深度感知可用于提升夜间的人像模式。

更优的聚焦性能是一个加分项,而iPhone12 Pro有可能会为图像增加更多的3D数据。尽管这项功能尚未实现,但苹果前置的原深感摄像头已经为app提供了类似的应用。

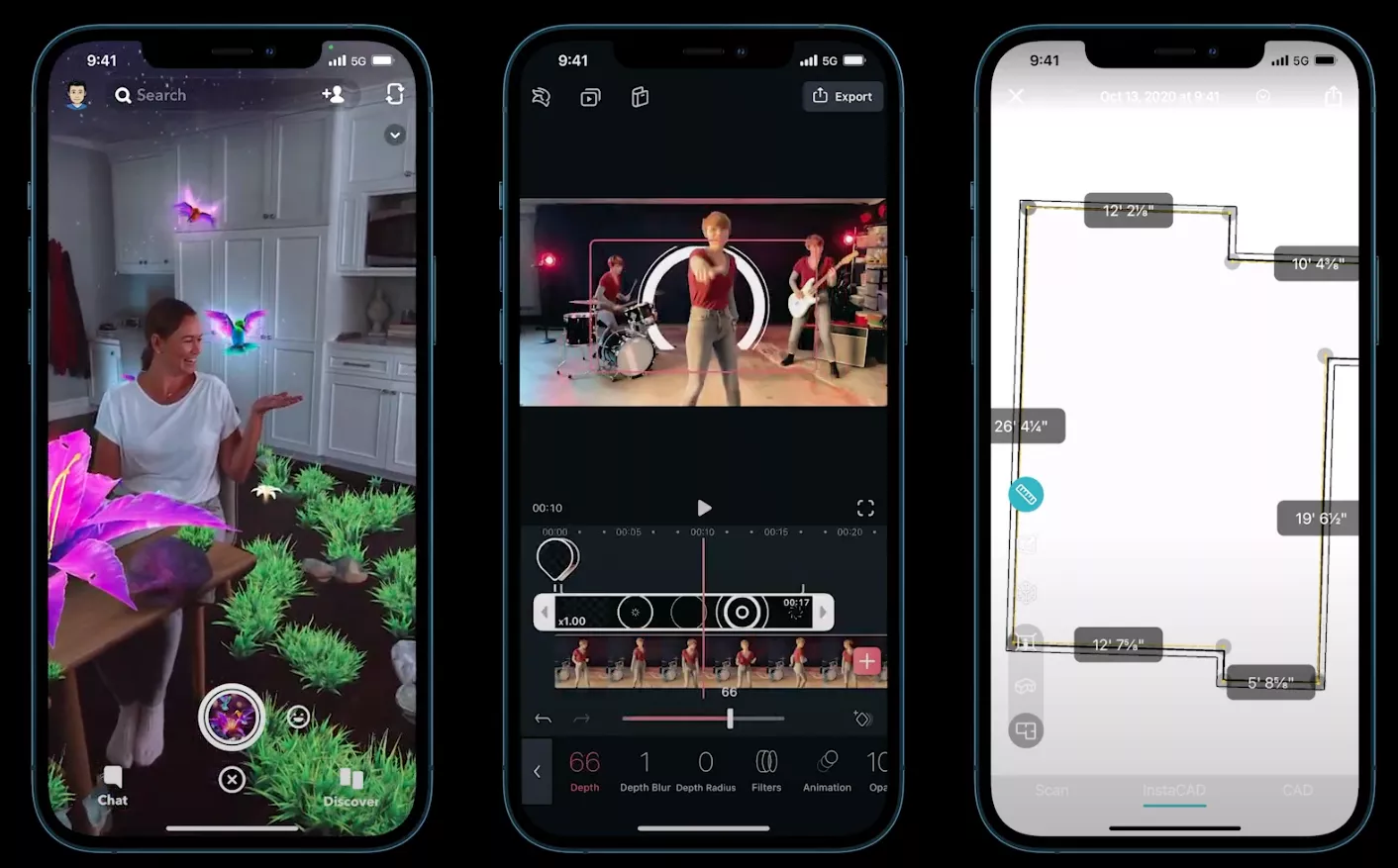

6. 它同时能极大提升增强现实

LiDAR将允许iPhone12 Pro更快启动AR应用,并迅速构建一个房间的映射以添加更多细节。苹果在iOS 14中的很多AR更新都涉及利用liDAR将虚拟对象隐藏在真实对象后面(遮挡),以及将虚拟对象放置在更复杂的房间映射中,如桌子或椅子之上。

但这项技术的潜能不仅只是这样。许多公司都致力于研发能够将虚拟对象和真实对象融合的头显:Facebook、高通、Snapchat、微软、Magic Leap、以及苹果等厂商开发的AR眼镜将依靠先进的3D世界映射来叠加虚拟对象。

这种3D映射目前主要是通过特殊的扫描仪和设备构建。但用户自己的设备可以最终帮助众包所述信息,或者添加额外的动态数据。再次强调,像Magic Leap和HoloLens这样的AR头显在叠加虚拟层之前就已经预先扫描了你的环境,而苹果配备了LiDAR的AR技术将同样如此。从这个意义上说,iPhone12 Pro和iPad Pro就像是没有头戴部分的AR头显……而它们将为苹果自己生产的AR眼镜铺平道路。

7. 3D扫描可以成为杀手级应用

LiDAR可以用来对3D对象和房间进行网格划分,然后在其上叠加内容。这可能是图像捕捉技术的下一波应用,比如作用于家庭装修,甚至是社交媒体和新闻业领域。这种捕捉3D数据并公开分享的能力可以让搭载LiDAR的智能手机和平板电脑成为3D内容捕捉工具。LiDAR同时可以在不适用摄像头元件的情况下来获取对象和空间的测量值。

8. 苹果不是第一家为手机探索LiDAR技术的公司

谷歌在开展Project Tango时也有过同样的想法,但这是一个只有两款手机采用的早期AR平台,而且销量平平。现在,苹果通过iPad Pro和iPhone 12 Pro系列将成功让该技术向大规模智能移动设备普及。

先进的摄像头阵列中包含红外传感器,并可用于映射房间,为AR和室内空间测量创建3D扫描和深度映射。搭载Tango的手机寿命很短,被苹果ARkit革了命后,取而代之的是可以在不需要相同硬件的情况下进行深度感知的计算机视觉算法ARCore。但是,苹果iPhone12 Pro现在又成为了一位更为先进的Google Tango继任者。