亚伯拉什分享Facebook最新AR/VR成果:手势、动捕、化身、AR虚实精确定位

基于虚拟现实和增强现实的第二波HCI革命不可避免

(映维网 2020年06月20日)2020年计算机视觉和模式识别大会汇聚了世界各地的计算机视觉研究者和工程师,而Facebook Reality Labs显然不会错过这样一场盛会。其中,首席科学家迈克尔·亚伯拉什通过视频介绍了团队的研究及相关进展。

亚伯拉什首先引用乔布斯于2005年在斯坦福大学毕业生演讲中针对PC图形界面未来发展方向的名言(You couldn’t argue about the inevitability, it was so obvious)指出,正如始于上世纪90年代的第一波HCI革命一样,基于虚拟现实和增强现实的第二波HCI革命同样不可避免。

第一波HCI革命是以PC和智能手机为代表的二维计算机,它们带来的数字世界改变了我们娱乐,工作和社交的方式。但尽管是这样,我们与数字世界的交互只能局限于二维屏幕。相反,亚伯拉什认为虚拟现实和增强现实则有望充分发挥人类完整的能力,以至于数字和现实能够实现无缝的融合。

亚伯拉什认为未来的VR头显能够实现200度视场,视网膜分辨率,可变焦距,逼真音频,而AR眼镜则是超级时尚,完全可以取代智能手机,并赋予佩戴者感知超能力。不过,目前这个愿景所需的技术远远没有达到应有的水平,包括光学系统,界面,触觉,虚拟化身和人体工学等。

为之奈何?亚伯拉什的答案非常简单:研究,研究,更多的研究。在演讲中,他提到了Facebook Reality Lab正在进行的研究及相关进展,并提供了一系列的视频材料。

首先是优化的手部追踪功能。如上方视频所示,现在系统能够相当精确地追踪手部和手指的快速运动。对于这一点,他表示光学手部和手指追踪将成为空间计算机范式的重要组成要素。

Facebook在虚拟化身渲染方面同样取得了进展,包括人体模拟,骨骼追踪,动捕技术,以及Codec Avatars。根据亚伯拉什的说法,再过数年就可以在虚拟现实中渲染出与真实别无二致的数字形象。

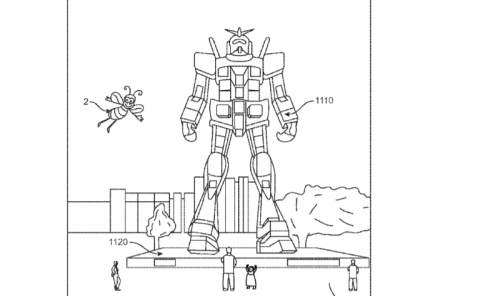

Facebooks XR未来的另一个重要组成要素是可以混合数字和物理信息的技术眼镜。但要做到这一点,它们首先需要在空间方面对物理世界进行分类,并在其中精确定位自己。在这样的背景下,亚伯拉什展示了LiveMaps团队的一个研究示例:

利用机器视觉和SLAM技术,LiveMaps可以创建共享的虚拟映射。为了实现这种规模的技术,这家公司设想LiveMaps将依靠未来智能设备捕获的众包信息。

亚伯拉什强调,尽管未来一片光明,但摆在我们面前的挑战依然巨大。他承认,第二波HCI革命的拓荒之路相当漫长,尚需无数年,无数个十年,但这同时是它的魅力所在,而且不可避免,势不可挡(You couldn’t argue about the inevitability, it was so obvious)。

完整的演讲视频如下: