Facebook发布『HMC实时面捕VR系统』论文

系统能够更精确地表示特定个体面容的细微差别

(映维网 2019年09月03日)Facebook Reality Labs(FRL)日前发布了实现超逼真虚拟角色的研究论文,并在其中进一步扩展了原来的“Codec Avatars”探索工作。完整的研究论文深入介绍了所述系统的方法论和数学计算。

名为“VR Facial Animation via Multiview Image Translation”的论文发布于《ACM Transactions on Graphics》期刊,而后者自称是“图形领域中最重要的同行评审期刊”。论文作者包括Shih-En Wei、Jason Saragih、Tomas Simon、Adam W. Harley、Stephen Lombardi、Michal Perdoch、Alexander Hypes、Dawei Wang、Hernan Badino和Yaser Sheikh。

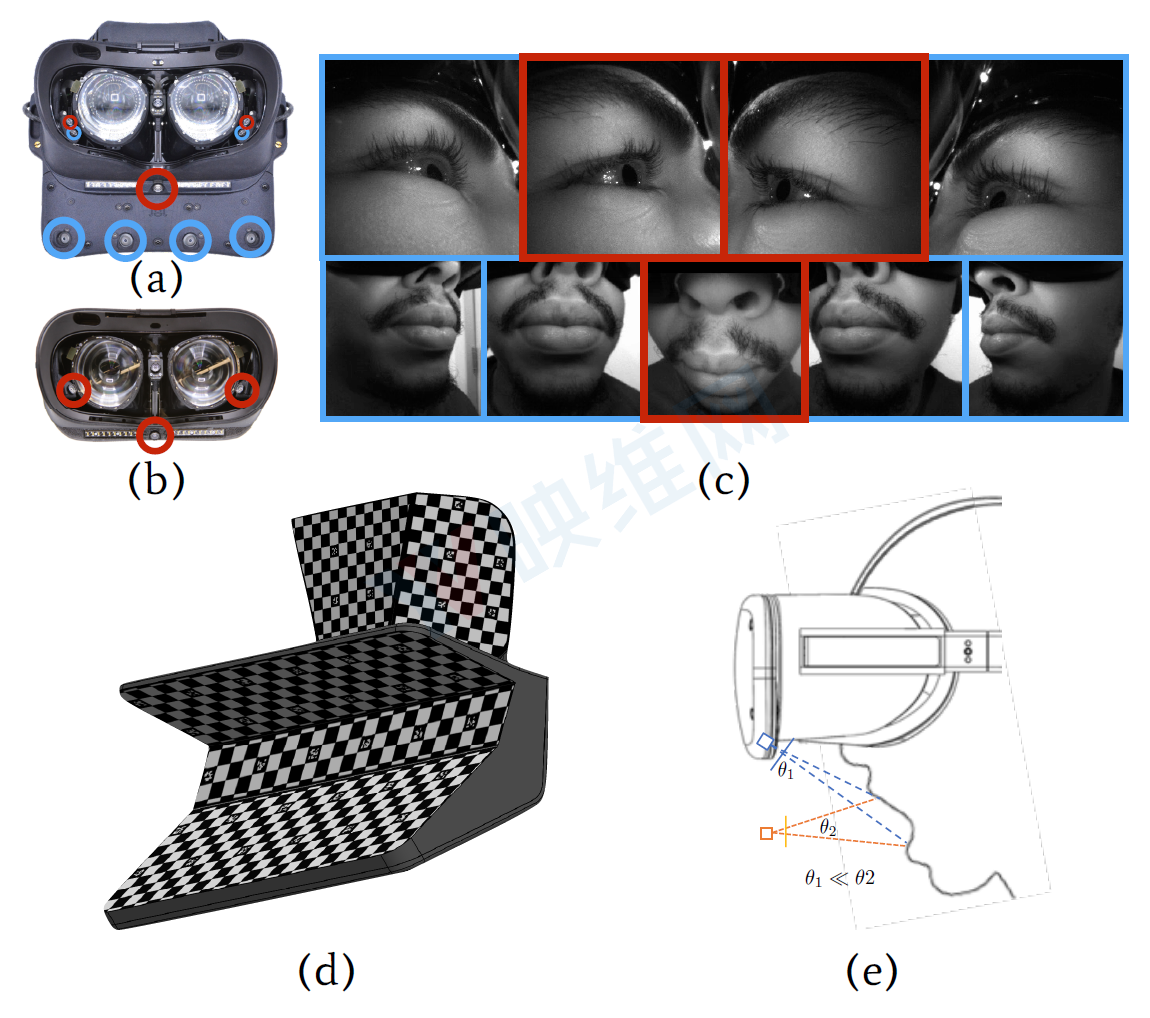

对于Facebook Reality Labs创建的系统,其能够通过紧凑的硬件并以前所未有的保真度来实时动画化虚拟角色。通过头显内置的三个标准摄像头(捕捉用户的眼睛和嘴巴),系统能够更精确地表示特定个体面容的细微差别。

除了摄像头之外,这份论文同时说明了如何利用相关图像来驱动用户的虚拟化身。FRL的解决方案非常依赖于机器学习和计算机视觉。一位作者指出:“我们的系统实时运行,并且支持广泛的表情,包括气鼓鼓、咬唇、舌头运动,以及诸如皱纹等传统方法难以精确动画化的细节。”

......(全文 1005 字,剩余 615 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限