Facebook开源DeepFocus,实现逼真散焦效果,推动下一代VR头显技术

文章相关引用及参考:oculus

这使我们的系统适用于所有下一代头显技术。

(映维网 2018年12月20日)Facebook Reality Labs(FRL)在今年早些时候亮相了Half Dome,这款头显原型的眼动追踪摄像头、宽视场光学元件、以及自主聚焦的显示器都预告着行业朝逼真VR体验前进的下一步。通过调整显示器以匹配用户眼睛运动,Half Dome的变焦设计能够令每一个虚拟对象清晰对焦。在为VR创建更为舒适、自然和身临其境的感觉目标中,这一方法带来了真正的进步。但要实现其所有的潜能,Half Dome的先进硬件需要搭载同样先进的软件。

在今年OC5大会的主题演讲中,Oculus首席科学家迈克尔·亚伯拉什就透露过借助可以实时实现“自然注视跟随模糊”的AI渲染器DeepFocus,他们“在解决这个问题上已经取得了相当大的进步”。他同时表示Oculus将在未来几个月内发表他们的研究成果。

今天,Oculus正式向我们分享了DeepFocus。这一基于AI的渲染系统能够协助Half Dome实现模拟人类感知世界的散焦效果。它是第一款能够实现如此效果的系统,可以模糊用户当下无法聚焦的场景部分,并且是以一种逼真、实时的注视跟随方式实现。于本月在日本东京召开的SIGGRAPH亚洲大会上,Oculus已经展示了相关的研究论文,他们同时开源了DeepFocus,包括系统的代码和用于训练的数据集,目标是帮助更广泛的VR研究人员将模糊融入至他们的研究之中。以下映维网整理了Oculus团队的具体分享:

渲染模糊对超逼真体验而言十分关键

DeepFocus由FRL的多学科研究团队开发。这与电影美学或炫酷的视觉效果无关。实际上,渲染模糊越精确,用户就越不可能注意到它。FRL的视觉科学家玛丽娜·赞诺丽(Marina Zannoli)很早就加入了DeepFocus项目,并认为对于真正逼真的体验而言,关键是聚焦和散焦视觉效果的组合。赞诺丽指出:“我们最终的目标是提供与现实无法区分的视觉体验。我们的眼睛就像是微小的相机:当它们聚焦于一个特定的对象时,不同深度的场景部分将看起来很模糊。那些模糊的区域有助于我们的视觉系统理解世界的三维结构,并帮助我们决定下一个焦点。尽管变焦VR头显可以在用户注视的任何位置提供清晰的图像,但DeepFocus使得我们能够像现实世界一样渲染场景的其余部分:自然模糊。”

逼真视网膜模糊一个最大的潜在优势是,其可以带来更为舒适的VR体验。FRL的显示系统研究小组负责人道格拉斯·兰曼(Douglas Lanman)解释说:“重点是实现全天候的身临其境。无论你是连续数小时开玩游戏,还是查阅一个无聊的电子表格,眼睛疲劳,视觉疲劳,以及你愿意花一天时间看着的精美图片,所有这一切都很重要。”

在2015年Half Dome项目仍位于早期阶段的时候,兰曼就已经认识到了渲染模糊的必要性。即便开展项目只是仅数月时间,但早期原型已经展示了在VR中创造清晰焦点的积极前景。但基于软件的散焦效果是一个主要障碍。我们的过程无法利用现有的技术来渲染非VR游戏中的实时模糊,因为它们更多是与影视摄制方法有关,目标是产生炫酷的电影效果(如精美的散焦背景),并且专门用于平板显示器和电视,而非奔着逼真感这个目的去。这种快速但不准确的“游戏模糊”实现方法与Half Dome的任务背道而驰。对于Half Dome,其目标是忠实地还原光线进入人类视网膜的方式。

我们投入了数个月的时间来探索如何通过传统技术来优化计算显示,但结果仍然不够快,无法产生真正的实时模糊,无法准确匹配物理现实。这些早期的努力揭示了在VR中渲染逼真模糊的双重挑战,亦即我们需要令人难以置信的高渲染速度,以及先进头显所需的高图像质量水平。渲染模糊不是应用于场景时的一次性过程。注视跟随的模糊必须实现快速,近乎即时的散焦效果,从而才能基本上匹配每个眼睛的运动。与此同时,其保真度无法单纯通过降低非聚焦对象的分辨率来实现。

兰曼发现,单纯地投入更多的处理能力来解决问题并不可行。对于2016年的Half Dome demo,其通过称为累积缓冲渲染(accumulation buffer rendering)的过程实现了实时模糊,其中每个场景渲染32次。但这种方法可行的原因只是因为整个场景十分简单,它不可能支持更广泛的VR体验,尤其是因为兰曼专注于为整个VR社区提供所有的软件解决方案。兰曼指出:“我希望它能够立即用于每一个游戏,这样我们就不必要求开发者改变他们的游戏,我渴望开箱即用的解决方案。”

2. 将深度学习带到VR

兰曼决定开发由AI驱动的软件,而不是被动地等待未来的处理器来满足我们的要求,或者要求用户自行提供更多的处理能力。具体而言,他希望利用深度学习,一种能够通过对大量相关数据进行训练,并从中学习如何执行特定任务的AI系统。深度学习算法通常用于分析图像,甚至是生成图像。尽管芯片厂商一直在朝这个方向发展,通过在最新的芯片中添加兼容AI的学习核心来提高图像质量的上限,但在与VR相关的系统中,深度学习却少之又少。兰曼说道:“我们决定利用那些正在推动行业趋势的相同AI工具。不仅仅只是生成像素,而且要提供前所未有的真实感。”

对于这个深度学习战略,兰曼从聘请不列颠哥伦比亚大学的人工智能研究员肖磊开始,后者的博士研究包括数值优化和计算摄影学的机器学习。兰曼指出:“我相信当时是肖磊来到实验室的第一天,我告诉他道,‘我希望像Half Dome这样的计算显示器能够首次实时运行,而且这个解决方案必须适用于Oculus Store中的每款内容,无需要求开发者进行重新编译。”

对于已经成为FRL研究科学家的肖磊,他的任务是根据已经用于ASW 2.0帧平滑技术,以及大多数游戏引擎都普遍提供的基本颜色和深度(RGB-D)输入来生成逼真的模糊,而不是根据一些复杂的,与焦点相关的新参数。这一领域早已存在相关的研究,但在虚拟场景深度不连续处出现的伪影,以及现代VR显示分辨率下的运行时性能不足一直都在对其造成困扰。理论上,如果AI系统有着对散焦的充分理解,这时无论相邻像素的相对深度或3D注视位置如何,它都可以预测相邻像素是如何混合在一起。如果这种技术可以用于简单的RGB-D输入,我们就可以将逼真的模糊应用于几乎所有的VR体验。

为了实现成熟图像理解和直接输入的这种组合,肖磊建立了一个全新的神经网络架构:一个专门针对实时渲染模糊进行优化的架构。与用于深度学习图像分析的更传统AI系统不同,肖磊研发的系统可以处理视觉效果,并且同时维持高质量VR所需的超清晰图像分辨率。

但与所有基于深度学习的系统一样,FRL需要大量的训练数据。具体来说,DeepFocus需要浏览数千个以不同距离放置各种对象的图像,并建立起对聚焦和散焦的理解。但是,没有现成的数据集能够提供DeepFocus团队所需的各种曲面和形状。所以肖磊和FRL的技术美术马特·查普曼(Matt Chapman)自行创建了这样一个数据库。

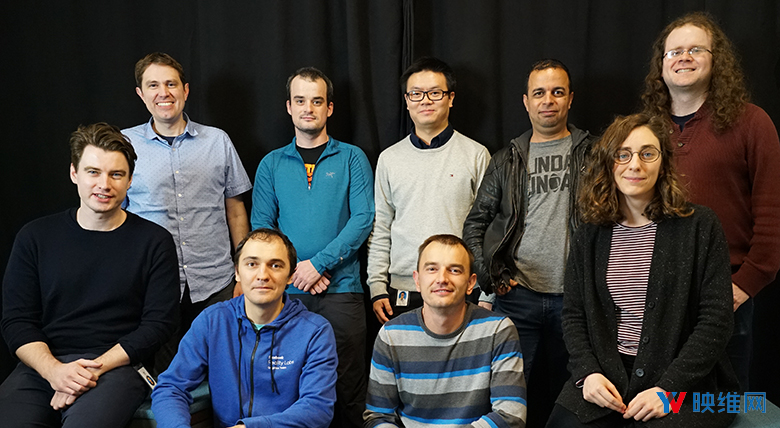

DeepFocus团队

查普曼是从Oculus产品团队来到FRL,而他在产品团队期间曾创建过一系列著名和优秀的demo。对于DeepFocus,查普曼将美学放在了一边,并为肖磊提供了一个虚拟对象的交互式堆积场。查普曼的随机场景生成器生成了由大量对象组成的场景,包括来自卢浮宫雕塑的3D扫描,以及合成球体,立方体和3D曲线。这些对象随机放置在3D空间中,深度范围从25厘米到10米。

由此产生的对象集合令人眼花缭乱,但一种方法可以解决随机场景生成器的视觉问题。这种不自然的,令人眼花缭乱的几何形状和遮挡物具有比现实生活中更多种类的纹理,表面和其他特征,但可以作为深度学习系统的一种焦点分析训练营。“这是我第一次与技术美术进行密切合作。”肖磊如是说道。像马特·查普曼这样的技术美术在研究机构中很少见,但对于FRL的AR和VR创新方法而言至关重要。肖磊表示:“为了改进随机场景生成器,从微调对象,纹理和材料的分布到减少ground truth图像的渲染时间,马特和我进行了大量的迭代。”总的来说,他们利用随机场景生成器绘制了196000张图像来对系统进行训练,使得DeepFocus能够理解如何在多变和不熟悉的VR环境中渲染模糊。

在接下来的一年中,DeepFocus团队增加了视觉科学家(如赞诺丽),以及研究科学家亚历山大·费克斯(Alexander Fix)和安东·凯普兰延(Anton Kaplanyan)。他们帮助设计了系统的深度学习方法。FRL的图形研究团队负责人凯普兰延表示:“对于之前用于渲染高度逼真模糊的方法,它们全都是基于人工制作的数学模型,边界情况与限制会导致低质量的结果和伪影。利用深度学习,我们的系统能够实现复杂的效果和关系,例如前景与背景散焦,以及遮挡边界处的正确模糊。通过生成丰富的ground truth数据库,我们能够覆盖更广泛的散焦效果,并为景深合成设立了新的标准。”

为了帮助证明DeepFocus能够实际应用于Half Dome,并且利用当前的处理器来实时渲染模糊,FRL的研究软件工程师萨拉·诺里(Salah Nouri)加入了项目。曾参与过3A级游戏制作的诺里表示:“当我加入团队时,他们已经建立好网络架构,而且运行时已经足够用于以1080p分辨率运行的常规PC或主机游戏。但我们至少需要将性能提高四倍,因为VR的要求更高。”

诺里能够在搭载四枚显卡的设备上演示DeepFocus和Half Dome。尽管这是比消费者目前可用的设备功能更强大,但仍然属于一项重大的技术进步。诺里表示:“我们需要非常小心地将四枚显卡之间的工作并行化,以便它们之间的内存传输不会产生任何额外的延迟,同时几乎无需任何计算成本。”

FRL对软件或硬件的探索尚未结束,我们的最终目标是在一枚显卡上实时运行渲染模糊。但无论是将人工智能技术集成到图形渲染中,还是开发新的,更具沉浸感的逼真VR体验,我们在SIGGRAPH亚洲大会展示的四显卡demo与研究代表了一个重要的里程碑。兰曼说道:“我们想看看渲染模糊可以为VR带来什么增益,但它必须是在真实的游戏和真实的VR设置中运行。我们做到了,而那解锁了全新的理解。”

3. 未来属于DeepFocus

对于DeepFocus和Half Dome,我们现在拥有了可以更好理解真实感如何对用户AR与VR体验作出贡献的工具。尽管我们现在是将DeepFocus用于Hald Dome之中,但系统的深度学习可以实现跨硬件兼容。我们的研究论文表明,除了在变焦显示器上渲染实时模糊外,DeepFocus同时支持用于多焦点和光场显示的高质量图像合成。这使得我们的系统适用于所有下一代头显技术。

通过开源我们的DeepFocus与训练数据,我们不仅为开发新VR系统的工程师提供了框架,而且为视觉科学家和研究长期感知问题的其他研究人员提供了框架。例如,我们的视觉系统是如何利用环境中的模糊来重新聚焦呢?对于世界的三维结构,模糊可以为大脑提供什么信息呢?DeepFocus有可能提供了渲染实时模糊的最后一块拼图,但基于我们系统的前沿研究才刚刚开始。