南加州大学、Snap研究员用体三维表征生成多样性3D发型

文章相关引用及参考:映维网

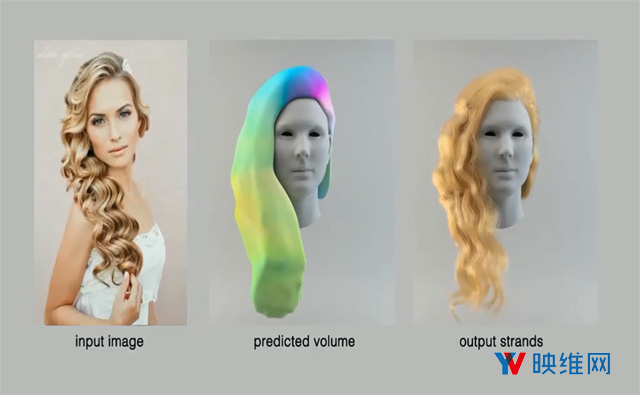

可以在一秒钟内根据图像产生3D头发模型

(映维网 2018年10月15日)单视图3D头发数字化的最新进展使得高质量CG角色的创建变得可扩展,并且可供最终用户访问,从而能够实现新形式的个性化VR与游戏体验。为了处理头发结构的复杂性和多样性,大多数尖端技术依赖于从综合头发数据库中成功检索出特定的头发模型。

这种基于数据的方法需要大量的存储,而且容易因为高度无约束的输入图像,异国发型,无效的面部检测而导致失败。为此,由Snap,Pinscreen和南加州大学研究人员组成的团队提出,通过体三维变分自动编码器的紧凑latent space来隐式表示3D发型的多样性,而不是直接使用大量的3D头发模型。

这种深度神经网络主要通过3D头发模型的体三维定向场表征进行训练,并且可以根据一个压缩代码合成新的发型。为了实现端到端的3D头发推理,研究人员训练了一个额外的回归网络,令其根据任何输入图像预测变分自动编码器latent space中的代码。然后,系统可以根据预测的体三维表征生成丝缕级别的发型。

......(全文 619 字,剩余 242 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限