结合深度数据和骨架,清华大学研究单深度相机实时动捕技术DoubleFusion

文章相关引用及参考:techcrunch

你知道为什么在动捕设置中,演员必须穿上紧身衣吗?

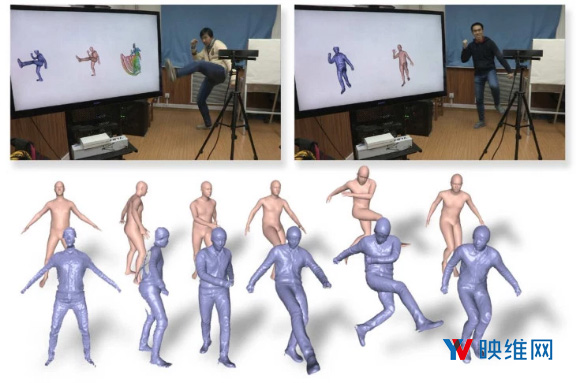

(映维网 2018年06月19日)随着增强现实技术的日渐流行和深度追踪摄像头开始登陆各款旗舰手机,提高计算机对人体运动追踪的时机已经成熟。现在映维网了解到,一项全新的计算机视觉系统甚至可以隔着衣服抽离人体运动。

一个基本的问题是,如果你要在电影或AR游戏中捕捉运动中的人体,衣服所造成的模糊感将会令人感到沮丧。你知道为什么在动捕设置中,演员必须穿上紧身衣吗?因为只有这样系统才能更准确地识别各肢体的位置。

即便是相当紧身的牛仔裤,这都会影响计算机对身体位置的捕捉。

这份最新的研究结合了深度数据和智能假设,利用一种X射线视觉来揭示衣服下面的人体形状和位置,即使在跳舞这样的快速动作时也能实时支持。

这篇论文是基于两个以前的方法:DynamicFusion和BodyFusion。前者通过单摄像头深度数据来估计身体姿势,但在快速移动或遮挡情况下效果不佳;后者则使用骨架来估计姿势,但同样在快速运动中表现不佳。研究人员将这两种方法合并为“DoubleFusion”,通过单个深度相机对动态人体进行采集,从深度数据中创建一种合理的骨架,然后通过距离适当的皮肤对其进行收缩包裹。

......(全文 863 字,剩余 421 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限