将2D图像人物实时映射3D模型,Facebook开源DensePose技术

文章相关引用及参考:映维网

高效地计算2D RGB图像和人体三维表面模型之间的密集对应关系。

(映维网 2018年06月19日)Facebook AI Reaserch(FAIR)今天正式开源了DensePose,一项将2D RGB图像的所有人类像素实时映射至3D模型的技术。

最近在人类认识方面的研究主要是定位一组零散分布的关节,如手腕或肘部。这对手势或动作识别等应用程序而言可能已经足够,但这减少了图像解释。Facebook则希望更进一步,比如说通过一张照片来进行试装,或者替换图片中朋友的衣服。对于这些任务,我们需要更完整的基于表面的图像解释。

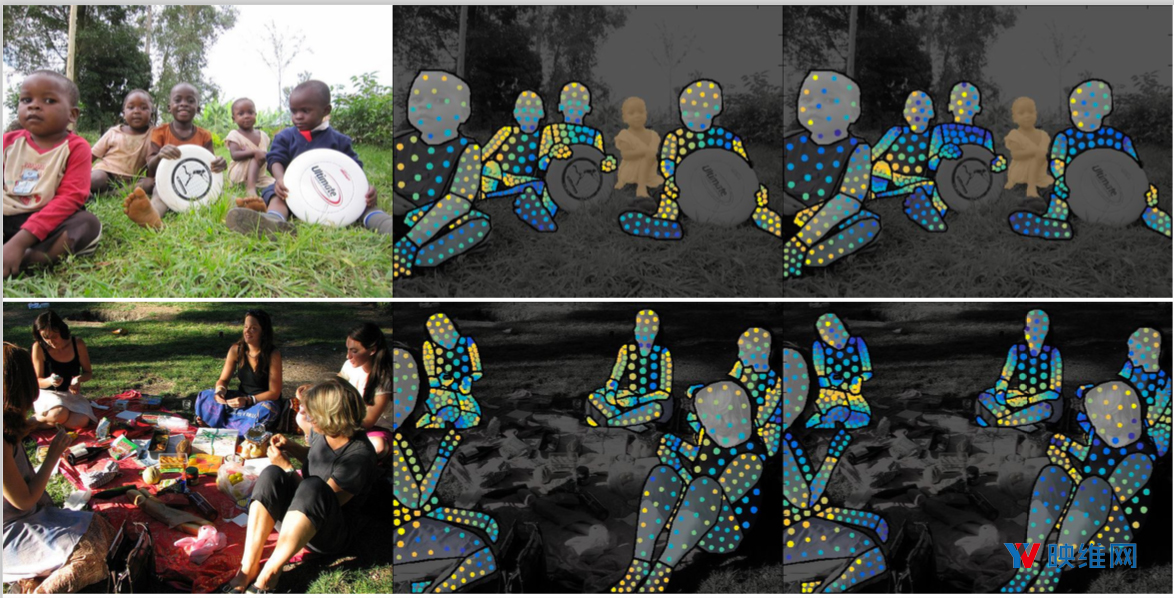

DensePose项目旨在解决这个问题,通过基于表面的模型来理解图像中的人类。Facebook的研究表明,我们可以高效地计算2D RGB图像和人体三维表面模型之间的密集对应关系。与人体姿势估计中利用10个或20个人体关节的常见项目不同,DensePose涉及整个人体,需要超过5000个节点。Facebook系统的最终速度和准确性加速了与增强现实和虚拟现实的联系。

早期对这个问题的研究在速度上相对缓慢,而DensePose则可以在单个GPU上以每秒多帧的速度运行,并且能够同时处理数十,甚至数百人。

为了实现这一点,Facebook推出了DensePose-COCO。这个大型标注数据集,在50000张COCO的图像上手工标注了图像-人体表面(image-to-surface)的对应点。在第一阶段,标注者将划定与可见的、语义上定义的身体部位相对应的区域。在第二阶段,Facebook用一组大致等距的点对每个部位的区域进行采样,并要求标注者将这些点与表面相对应。

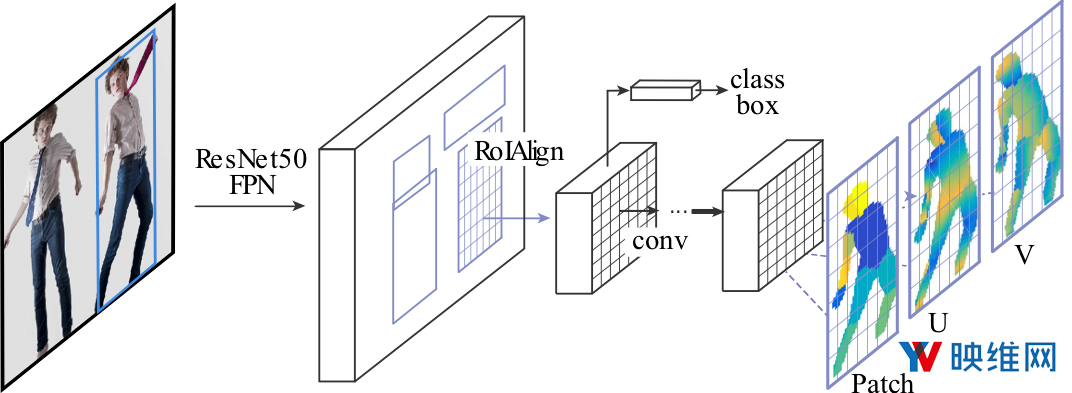

Facebook同时开发了一种新颖的深层网络架构。Facebook以Detectron系统为基准,并且纳入了密集姿态估计的功能。和Detectron的Mask-RCNN系统一样,Facebook采用了Region-of-Interest Pooling,并且引入了一个全卷积网络。Facebook用三个输出通道来增强网络,训练它把像素分配给各个部分,以及U-V坐标。得益于Caffe2,所产生的架构实际上与Mask-RCNN一样快。

Facebook表示,之所以开源是因为他们希望DensePose可以为计算机视觉,增强现实和计算机图形的研究人员和开发者可以更紧密地合作,并且助力新体验的发展。据映维网了解,DensePose目前已经托管至GitHub。Facebook同时为DensePose-COCO准备多个预先训练模型的性能基准,以及人工标注信息。