《Speak of the Devil》团队分享VR影片制作流程、挑战

文章相关引用及参考:映维网

映维网希望通过分享这篇文章来为大家提供一定的借鉴参考

(映维网 2018年04月02日)本文来自VR恐怖影片《Speak of the Devil》背后的Light Sail VR工作室。这部作品已在本月初登陆Oculus Home。在这篇文章中,Light Sail VR将向我们分享他们的后期制作流程。由于行业尚未建立起真正的标准,映维网希望通过分享这篇文章来为大家提供一定的借鉴参考。以下是映维网的具体整理:

在上周,我已经介绍了《Speak of the Devil》的拍摄。拍摄十分有趣,因为在拍完最后一个场景时你感觉似乎已经结束。但事实上,这仅仅只是一个阶段的结束,接下来还有更多的事情要做。后期制作是把所有都整合在一起的关键步骤。

我们当时的目标是在万圣节之前完成项目。必须承认,我们想象中的时间表十分荒谬和天真。我们当时完全没有想到接下来将要面临的工作量。显然,最终项目的完成时间比离当时的计划推迟了数个月。

本文存在一定的技术性,因为创建VR内容的确是技术性的工作。所需的工具非常新颖,或者是根本不存在。行业尚未建立标准的工作流程,而我们没有多少经验可以帮助决策。简而言之,你难以通过网络找到正确的答案,因为少有人以这种规模制作相关的项目。就我所知,《Speak of the Devil》是第一款真正的大型VR网格叙事内容。

我们需要改变很多以往的工作流程,并且不断适应一直变化的时间表和技术障碍。

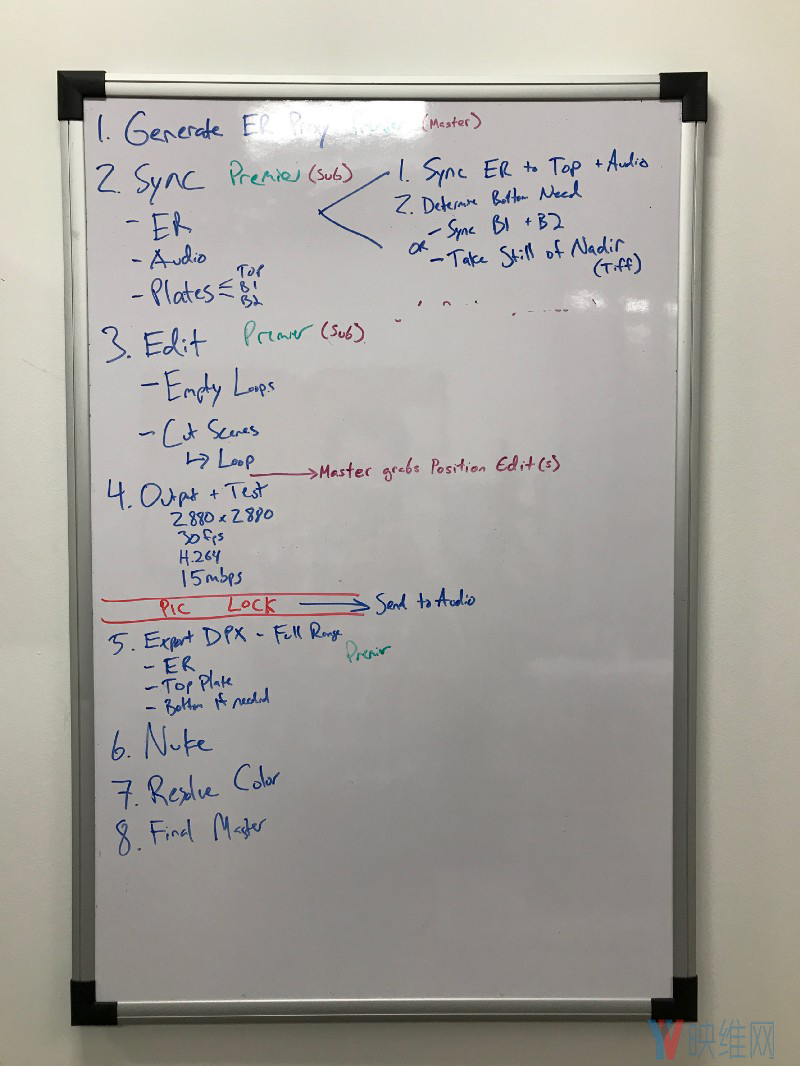

这是我们的第一个白板。大部分都是正确,但缺乏一定的细节。另外,这没有考虑到把多个场景纳入各个完成阶段的复杂度。

这是我们的第一个白板。大部分都是正确,但缺乏一定的细节。另外,这没有考虑到把多个场景纳入各个完成阶段的复杂度。

1. 大量的构思

对于《Speak of the Devil》,我们有幸加入了Google Jump Start项目。所以我们可以使用Jump相机,以及谷歌的Jump Cloud拼合技术。必须承认,谷歌有非常聪明的开发者设计了最好的自动拼合器之一。

我们拍摄了大概6TB的片段,而这需要上传至云端进行拼合。这样的数据量十分巨大。幸运的是,我们可以访问YouTube Space LA并利用他们GB级别的上传管道。把一切都上传至云端大概花费了24小时。令人感到惊喜的是,在内容上传12-36小时后,我们开始接到通知说拼合片段已经完成并可以进行下载。在超过7.5小时的材料中,每一次拍摄都在两天内完成。这令人难以置信,同时也是Google Jump相机非常受欢迎的一个重要原因。当然,我们还需要24小时才能下载拼合内容。

你从云端将能收到一个大小为5760×5760,以59.94fps运行,色彩空间是4:2:2的H.264 over-under文件。Adobe Premiere Pro显然不喜欢这种文件…。

我们需要立即将所有素材转码为Premiere Pro可以接受的文件。我们选择将自己的代理文件创建为DNxHR LQ 8bit文件,分辨率为2048×2048。回想起来,我本来应该可以产生更高质量的文件,因为我们无法感知森林中的小细节,这意味着我们要在工作流程的后期才能发现出错的地方。在与Jump的工程团队进行交流后,我们发现其实你是可以利用Jump来创建代理文件,并使用Adobe Premiere的代理功能进行对接。

除了编辑代理之外,我们还需要将所有使用过的素材转码为高质量的帧序列,这样才能在Nuke中进行顶部和底部立体合成。我们计划使用DPX文件,因为我们的Mistika单视场VR管道使用这种文件,我们发现这十分可靠。然而对我们运行媒体的快速计算,我们将需要的版本和中间件数量,以及我们在工作流程中为错误预留的空间,这一切都导致我们相信我们届时将需要超过100TB的存储空间。我的天啊!

Lumaforge拯救了我们。我们已经将他们的30TB Jellyfish Mobile作为我们办公室的主要共享储存。我们需要他们在更大的事务中为我们提供帮助。我欣赏Lumaforge的地方在于,这家公司愿意资助像我们这样的独立电影制作人。他们理解要创建某种挑战极限的项目所需要付出的勇气和辛勤努力。他们同时知道如何制作能够减轻我们负担的优秀工具。

Lumaforge巨大的共享储存令《Speak of the Devil》能够实现60fps速度下的5.7K分辨率。

Lumaforge巨大的共享储存令《Speak of the Devil》能够实现60fps速度下的5.7K分辨率。

我们将我们所有的三台工作站都连接至他们带过来的125TB塔式服务器。这意味着我们可以在一台设备上进行编辑,在第二台进行构景,然后在第三台进行导出。或者在一天结束时,我们可以在三台机器上排队渲染器,并且有机会完成任务。节省的时间非常巨大,同时我们可以使用800mb/s以上速度进行读写的驱动器。

我相信我们的设备是全天候24小时一直在运转。

我相信我们的设备是全天候24小时一直在运转。

但我们很快就发现,我们不仅需要大量的空间,还需要比10GbE更快的管道。在几个场景之后,我们认为DPX无法提供任何优势,所以我们转而使用Zip16 OpenEXR。可以考虑的格式有很多,但这是一个很好的标准,可以提供更小的文件大小和更可靠的Nuke工作流程,而这将成为我们管道的主要部分。但即使是切换到更加压缩的格式,我们的最终项目也是占据了大约110TB的空间。

在一切准备妥当后,现在是时候处理所有这些场景了。

2. 编辑

我们邀请Chris Willett作为我们这个项目的首席编辑。我们之前已经合作过一系列的项目。Willett的构景非常好,而且他一直愿意参与创建与众不同的内容。

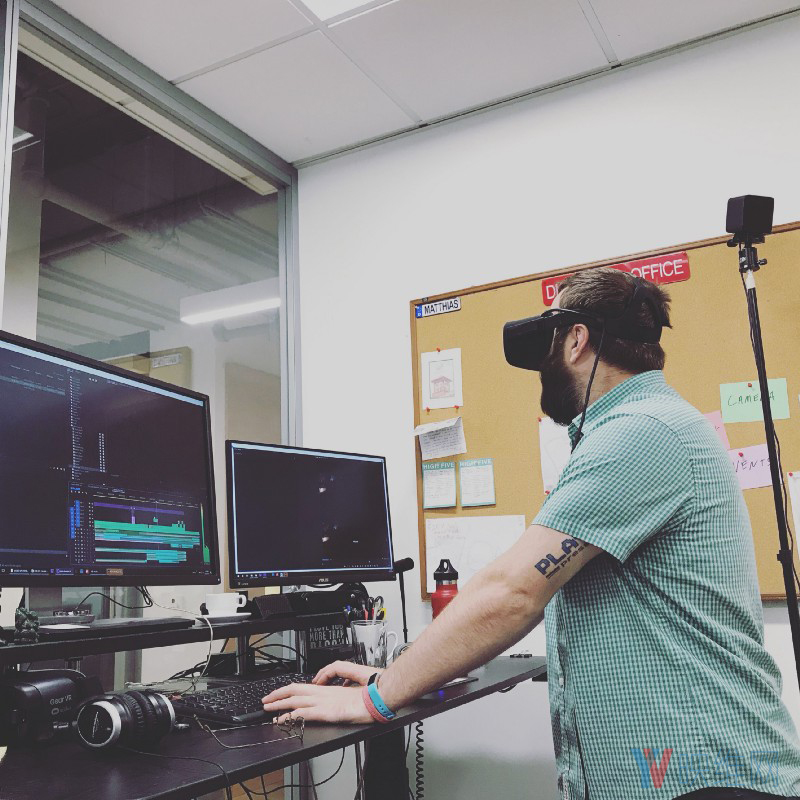

佩戴Rift头显的Chris正在整合开始时的噩梦场景。

佩戴Rift头显的Chris正在整合开始时的噩梦场景。

我们开始时只是在森林中创建所有空白点,选择最佳的15秒左右来创建无限循环。我们很快就会明白到底会有多少地点和镜头,而我们需要一种方法来跟踪进度。

我曾撰写过一篇使用Kanbanchi的文章。这是一种非常类似于Trello的服务,但具有更深入的Google Drive集成。文章很长,但结论是Kanbanchi对在整个管道跟踪镜头,以及与VFX和音效协作上的价值无可比拟。

由于要跟踪这么多镜头,Chris和我决定了采用一条管道,以确保一切尽可能顺利进行。每个位置都有一个包含序列的文件夹,其中每个组成部分(等矩形,板块拍摄等)都进行了分解并同步。我们关闭了大部分板块元素,然后将序列嵌套到编辑序列中。在这里,我们可以为死亡添加溶解和颜色效果。我们必须确保我们的过场动画无缝过渡到循环场景。

非常明显的是,你很难分辨场景是否有效,原因有二:

- 最终音频在成功营造情绪方面将发挥巨大的作用

- 在将场景放入游戏引擎并解决具体的bug之前,我们无法真正体验故事。

这意味着我们过去所习惯的质量控制过程被颠倒过来,而我们将不得不尽快整合游戏引擎的编程那方面,从而确认所有一切都能整合一起,并且播放我们当时的设想。由于从未做过这样的项目,理解起来十分困难。

3. 12种死法

死亡场景最为有趣,并且是我们必须做出的最具挑战性的创意选择。12种独特的死法,而令每一种死法都令人感觉有趣相当困难。

我们拍摄的一些死亡情景在编辑时变得一败涂地。坦率地说,恶魔对你大吼并不足以激起恐惧,所以我们需要加强这一点。Chris和我围绕时间和声音入手。我们甚至有机会破解Mettle的Mantra VR副本。

Mantra VR主要是用来翘曲世界,令场景看起来就像是Windego的声波正在对你施加影响。我们认为这为死亡添色不少。

Mantra VR主要是用来翘曲世界,令场景看起来就像是Windego的声波正在对你施加影响。我们认为这为死亡添色不少。

我最喜欢的死亡场景是Lindsey和Brian的呕吐物飞到你脸上的两个场景。为了达到这个效果,我们邀请了Occlusion VFX的Josiah Reeves来帮助模拟3D中的苍蝇,并将它们合成到场景之中。

这是最令我恐惧的场景。

这是最令我恐惧的场景。

12次死亡加上一条出路等于13是纯粹的巧合(在西方文化中,13是不吉祥的数字)。我们认为这是适合我们项目的数字。

4. 恐怖电影的成功在很大程度上取决于音效

在恐怖电影中,音效设计是帮助建立气氛的最重要因素之一。如果你觉得你太害怕了,不要闭上眼睛,请关掉音效。

对于《Speak of the Devil》,我们与Eric Wegener再次联手,我们曾在第一部360度恐怖项目《Paranormal Activity: The Ghost Dimension》进行过合作。

我需要不断在创意,设计和音景技术层面之间进行平衡。所需的材料数量惊人,森林中有50多个独特的地点,每个地点都涉及多个环境循环背景和过场动画。因此,这方面的一个重大挑战是让每个地点都是独特而有趣,同时还要令整个森林感觉真实和连贯。

我们这样做的一种方式是,让玩家听到来自相邻位置的远处声音,这不仅会产生令人毛骨悚然的逼真空间效果(即看不到的人物在附近大喊大叫),而且会吸引玩家前往特定位置以推进故事。

在我们建立了这种森林的逼真音效后,我们在上方设计了更多怪异的抽象层,试图混淆玩家并将其吓跑。这些声音大多由令人毛骨悚然的音调元素,低语,呼吸,大笑,哭泣和撒旦吟唱等组成。它们要么是由特定事件触发,要么作为完全不可预知的,可以随时发生的“随机一次性镜头”。

这种组合非常有效,可以逐渐增加你的孤立感和恐惧感,而增加的随机化确实能令你始终战战兢兢。

我们使用了Facebook Spatial Audio Workstation

我们使用了Facebook Spatial Audio Workstation

我们十分高兴能与Eric合作,而我认为沉浸式音效是我整个叙事中最喜欢的一部分。

5. 收尾

我们喜欢用GoPro Odyssey进行拍摄,但我们不喜欢的一件事情是,它无法捕捉球体的顶部和底部。Robert和我希望可以最大化沉浸感,这样无论是往下看还是往上看,用户都不会发现空白的区域。这意味着我们需要拍摄顶部和底部并将它们集成至到3D空间中。这不是一件容易的事,特别是对于我们的拍摄次数而已。

根据我们使用Google Odyssey Immarse的经验,我们知道我们必须利用Nuke才能实现最高质量的结果。

我们邀请了Treehouse Studios的Jeremy Vanneman来作为我们的立体视觉监督。我们希望尽快开始,但由于我们仍然处于编辑阶段,因此不可能把所有素材都发送至驱动,特别是考虑到内容的大小。

Jeremy用超过110个镜头来组合顶部和底部帧。

Jeremy用超过110个镜头来组合顶部和底部帧。

我们在Kanbanchi中制作卡片,并将等矩形镜头的静止帧与静止的顶部和底部板块连接起来。Jeremy利用Nuke将这些组合在一起,然后向我们发送回Nuke脚本。然后我们将重新连接到高分辨率帧序列和渲染器。我认为我们最短的渲染时间是8小时,而我们最长的渲染时间是75小时。

在VFX过程完成一半的时候,Google Jump团队发布了一个名为“Sweet Spot”的新功能。如果存在奇怪的光流伪影,这项功能将允许我们把场景发送回云端进行重新拼合。自在森林中拍摄这部电影以来,我们的镜头中出现了大量的伪影。事实上,如果你注意我们预告片中的场景,比如说Cultist拿着一个鹿头骨,以及最后叙述中的相同场景,你会发现由于我们采用“Sweet Spot”功能对其进行了后续处理,所以画面将有所优化。我们无法操作所有的场景,但我们能够在几个场景中使用这个优秀的新功能来显著提高质量。

请注意光流伪影的减少

请注意光流伪影的减少

我们的渲染器为左眼和右眼创建了一个单独的EXR帧序列,以准备接下来的颜色分级。当我们开始这个项目时,我们已经计划在Davinci Resolve中完成颜色分级,因为我已经很熟悉这个软件。《Speak of the Devil》为我们提出了一个有趣的问题。

你看,为了保持故事中地理的准确性,我们用照相机9(Odyssey的前置摄像头)面向正北拍摄了每一个场景。这意味着有很多故事发生在正南面(或直接发生在接缝线上)。

Davinci Resolve不理解360度视频。这意味着如果我要在接缝处做一个电动窗,离下接缝线的风险将非常高,因为我甚至无法在头显中检测的分级,我要等待数小时的渲染时才能知道。而我们并没有这样的时间。又一次,我不得不修改我们的工作流程。

幸运的是,Assimilate开发了十分强大的后期制作工具,能够完全支持360度视频。Scratch VR不仅可以让我们在接缝线上使用窗口和蒙版,而且还提供完整的头显预览支持。

Scratch VR似乎十分复杂,令人望而生畏,但一旦你掌握了具体的操作,这将是一款十分强大的工具。

Scratch VR似乎十分复杂,令人望而生畏,但一旦你掌握了具体的操作,这将是一款十分强大的工具。

我使用WMR头显来预览《Speak of the Devil》。能够翻转,调整设置,然后翻转并检查的能力为我们节省了大量的时间。这确实意味着要学习一个全新的程序,而我犯了很多需要重做和重新渲染的错误。尽管如此,我对最终的表现感到非常满意。

6. 结束了吗?

后期处理阶段是从去年9月份到今年1月中旬。对于通常是为品牌内容制作5分钟商业短片的我们而言,这感觉像是无穷无尽,但有几个人告诉我们,对于这种规模的项目来说我们的速度已经非常快。我们必须在后期处理过程中多次修改我们的技术和工作流程,这很令人沮丧,但迫使我们学习和积累了很多,这样我们在未来就能更轻松地处理这种风格的媒体内容。

但我们还没有完成。当我们完成所有最终的视觉特效,声音和色彩时,我们同时需要努力与Wemersive和The Oberon Group进行合作,思考如何对整个逻辑引擎进行编程并将其传输到你的手机之上。