布朗大学科学家用VR控制机器人,并开源项目代码

文章相关引用及参考:haptic

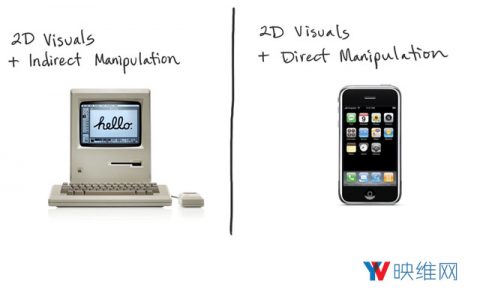

通过虚拟现实来直观地操纵机器人

(映维网 2018年01月17日)尽管自动机器人能够独立而且出色地完成自己的任务,但仍然存在需要人类介入和控制的情况。由布朗大学计算机科学家开发的新软件能够支持用户通过虚拟现实远程控制机器人,而这将能帮助用户沉浸在机器人的环境之中。

软件能够通过网络将机器人的手臂和抓爪,以及板载摄像头和传感器连接至虚拟现实硬件。借助手持式控制器,用户能够控制器机器人手臂的位置并执行复杂的操作。

用户可以步入机器人的金属皮肤以获取环境的第一人称视图,或者以第三人称视角调查场景。你可以自由切换,寻找最方便完成任务的视角。而且机器人和虚拟现实设备之间传输的数据足够紧凑,能够以最低延迟通过互联网发送,以支持用户远程控制机器人。

......(全文 1303 字,剩余 1001 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限