ManoMotion利用苹果ARKit实现手部控制输入

文章相关引用及参考:roadtovr

这一切只需使用智能手机的板载处理器和摄像头。

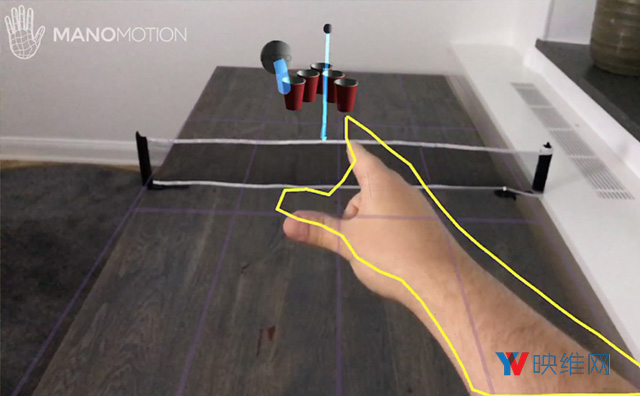

(映维网 2017年09月08日)计算机视觉和机器学习公司ManoMotion今天宣布,他们已经把基于智能手机的手势控制集成至苹果的增强现实开发者工具ARKit,从而把基本的手部追踪功能带到AR之中,而这一切只需使用智能手机的板载处理器和摄像头。

随着谷歌和苹果正通过各自的软件开发工具包ARCore和ARKit来加速增强现实革命,开发者希望看到基于智能手机的AR到底能走多远。我们至今已经看到了很多新的应用程序,包括移动VR头显的内向外定位追踪和部分非常令人兴奋的实验,但这是我们首次看到手部追踪集成到AR平台之中。

Venture Beat在ManoMotion集成对ARKit的支持之前就已经体验了该公司的手势输入功能,ManoMotion执行总监Daniel Carlman表示,其可以追踪“27自由度手部运动中的大部分”。跟原来版本一样,集成ARKit的SDK可以追踪深度,并识别熟悉的手势(如滑动,点击,抓取和释放)。ManoMotion同时宣称这一切“仅占用CPU,内存和电池消耗的极小一部分”。

在ManoMotion提供的视频中,我们可以看到基于ARKit的应用程序可以识别用户的手部,并能响应把将乒乓球弹射至杯子中的轻弹动作,这充分利用了ARKit的空间映射能力。

像啤酒乒乓球这样的简单游戏可能像是一种无关紧要的用例,但能通过双手与数字世界交互的能力在游戏之外拥有更大的含义。诸如HoloLens和Meta 2的AR设备依靠手势控制与UI进行交互,这为我们带来了无数的可能性,包括跟生产力相关的操作,如放置和调整窗口大小,或者是通过手指简单地打开房子中的联网灯泡。尽管谷歌和苹果都没有就未来的AR头显发表言论,但今天移动平台上的这些早期实验(不一定需要昂贵的定制设备)将会定义即将到来的AR头显的功能。

Carlman说:“到目前为止,当前的AR技术存在非常痛苦的限制,亦即无法直观地与3D空间中的增强对象进行交互。向ARKit带来手势控制并成为市场第一家为此提供证明的公司,这对我们来说是一个巨大的里程碑。我们渴望看到开发者将如何在增强现实中创建并重新定义交互!”

ManoMotion表示,即将推出的SDK版本将带来ARKit集成,并在“未来几周内”通过官网提供下载(点击前往)。ARKit集成将首先支持Unity iOS,而在随后的更新中将支持Native iOS。