浅谈VR的四代交互输入方式

文章相关引用及参考:vrfocus

VR中的面部表情存在非常多的应用,可以显著改善用户之间交流和交互

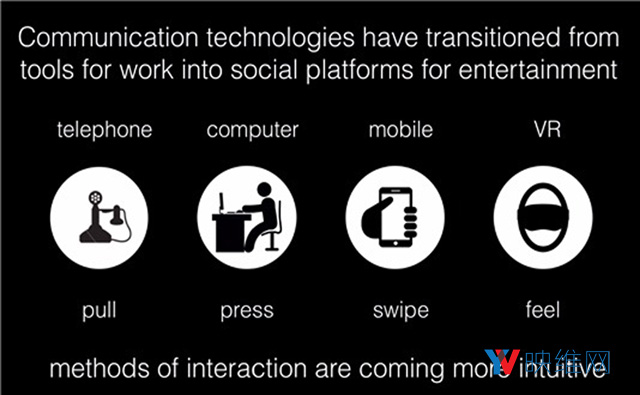

(映维网 2017年08月22日)自第一代大型主机诞生以来,设计师和工程师便一直在寻找更直观的交互方法。19世纪初的查尔斯·巴贝奇分析机主要通过穿孔卡进行输入和输出。100多年后,键盘和鼠标成为了计算机的主要输入方式。

笔记本电脑和随后的智能手机普及了触摸板鼠标和触摸屏。随着设备变得越来越直观和自然,我们的交互方法也同样如此。当年的计算机需要一整间房的空间,后来逐渐演变成摆在桌面上的电脑。然后是可以摆在双腿之上的笔记本电脑,再然后是我们每天都拿在手上的智能手机。未来的计算将呈现在你的面前,届时信息处理将变得更加个人化。

交互方式从需要推拉的穿孔卡发展成敲打的键盘和点击的鼠标,然后是手指滑动的触摸版和触摸屏。对于摆在面前的计算机,其挑战和潜在优势都非常显著。随着计算机屏幕从原来的19英寸发展成甚至没有屏幕(如Magic Leap和HoloLens),我们将需要新的交互方式。

我们可以从交互性和时间角度来分析VR/AR平台的输入设备。以这种方式来看,阻碍VR/AR成为真正身临其境的媒介的缺失一环将变得清晰起来。

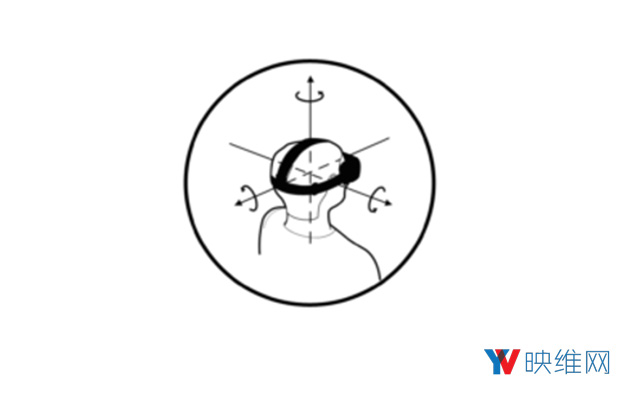

1. 第一代AR/VR输入

我们可以认为第一代输入设备是集成至头显的运动传感器,在旋转头部位置时可以改变场景。对VR来说,这可以通过在屏幕上创建指针(标线)来实现基本交互。

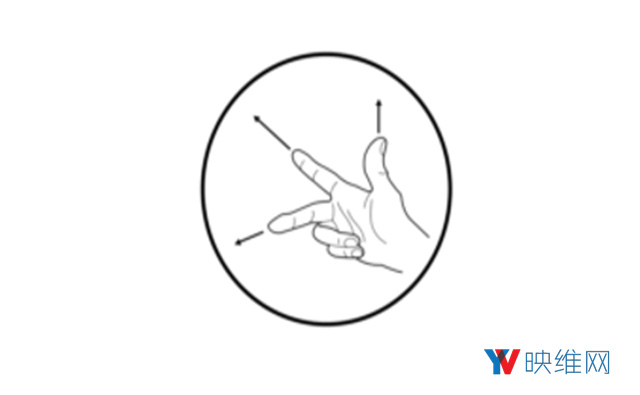

2. 第二代AR/VR输入

当软件能够与用户肢体进行交互时,虚拟现实系统将能以字面和隐喻的方式向前迈进。20世纪90年代出现了一系列的指向设备,特别是手套和跑步机,使用户能够四周移动,并把双手呈现在虚拟场景中。即使没有触觉反馈,无线和基于摄像头的肢体追踪都能显著提高交互性,例如用于VR的Leap Motion和类似的AR技术。

3. 第三代VR输入

在以往,可穿戴的眼动追踪一直是一种利基和相对昂贵的技术,主要限于学术用途和市场研究人员。然而,市场越来越重视注视点渲染的潜力,因为这种技术能够显著降低高分辨率,低延迟图像渲染的计算需求。

为VR添加眼动追踪的另一个好处是,它可以为用户和虚拟人物之间带来更逼真的交互。受益于智能手机革命的语音识别技术也可以用于辅助眼动追踪,比如通过启动明确性命令(比方说看着一扇门,然后说“开门”)。

主要的科技公司都已经收购了眼动追踪企业。谷歌收购了Eyefluence,Facebook接收的是Eye Tribe,而苹果则是SensoMotoric Instruments(SMI)。

4. 第四代VR输入

面部表情是VR和AR交互中重要的缺失元素。尽管已经有企业通过集成深度传感器的头显来可视化下半脸(如Binary VR),但这种方法是否能得到市场的欢迎还有待观察。

这种方法可能存在问题的三个潜在原因包括:1. 人类的交互方式;2. 人体工学方面的担心;3. 计算和续航能力的考虑。

眼动追踪研究得出了一个结论是,在面对面的交互中,我们主要是从眼睛区域推断信息。惊讶,愤怒,厌恶和真正的微笑都需要根据眉毛区域进行判断,而这通常是被头显所覆盖。为Oculus进行研究的黎颢在头显的泡沫衬垫 处集成了拉伸传感器,希望从头显后面导出信息。相信在最终版本推出时将会十分有趣。

Mindmaze已经展示了他们的Mask原型,产品的电极安装在泡沫衬垫面板上,而这些电极可以感觉到你的面部肌肉,甚至可以在你完全作出表情之前进行预测 。另外,三星还宣布了名为“FaceSense”的开发项目,但目前提供的细节有限。

Emteq的解决方案名为FaceTeq,其主要是通过新型传感器模式来检测面部肌肉收缩时产生的微小电气变化。每个面部表情都会在皮肤上产生一定的电活动,而这可以进行非侵入性地检测,无需任何摄像头。

上述平台预示着第四代VR输入的到来。研究人员,开发商和市场研究人员无疑将成为最初的采用者。然而,真正的进步将是实现面对面社交体验的能力。VR中的面部表情存在非常多的应用,相信这将可以显著改善用户之间交流和交互。