增强现实的第一个十年

本文相关引用及参考:seekingalpha

增强现实可能会演变成跟智能手机那样无处不在的大众产品。

(映维网 2017年4月14日)在2006年2月,Jeff Han在Ted Talk上演示了一个实验性“多点触控”界面。而今天,这个功能似乎过分的平淡无奇,因为每一款智能手机都可以实现。然而,当时的观众(大多是技术人士)却在屏住呼吸并为这个演示激情地鼓掌。原为惊人,现已平凡。一年后,苹果推出了iPhone,而随后围绕多点触控的热潮再次归零。

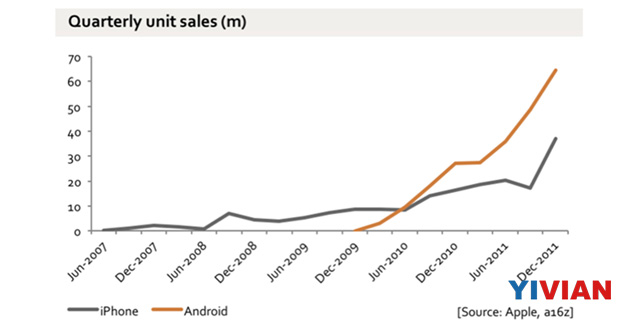

十年后之后回想起来,多点触控的发展一共出现了四个转折点。首先多点触控在研究实验室中成为了一个有趣的概念;然后公众场合出现了第一个demo演示;接下来真正在商业可行的多点触控诞生在iPhone上;几年后,随着iPhone的发展和安卓的追随,这个概念开始真正腾飞。你可以留意下方这个表格。在集成多点触控的iPhone于2007年推出后,消费者产品的发展一度陷入停滞,甚至下降,直至数年后才实现了指数式增长。大多数革命性技术都会呈现出阶段性发展,毕竟滴水穿石非一日之功。

今天,我认为增强现实是介于第二个和第三个转折点之间。惊人的demo以及第一款原型已经诞生,而虽然我们尚未看到消费者版产品的上市,但已经十分接近。

微软的HoloLens已经发货:尽管体积巨大、视场有限、成本高昂(3000美元),但这款设备提供非常优秀的定位追踪,同时把计算组件都整合到头显之中。HoloLens的第二个版本显然会在2019年推出。在另一边,根据人才招募和企业收购,以及执行总监的种种言论,我们不难发现苹果也在“蠢蠢欲动”。谷歌,可能还有Facebook和亚马逊都在为这个具有广阔前景的市场做准备。另外还有一批小公司和初创公司都在开展有趣的研发项目。

与此同时,融资14亿美元且估值已达45亿美元的Magic Leap仍在闭门深造,他们此前公布的一系列demo视频让我们看到一个全新的未来。视频显然很酷炫,但视频演示跟实际效果不可一概而论,欣赏一个关于iPhone的视频和真正上手体验iPhone截然不同。同样,AR视频的演示效果跟实际佩戴的体验也有着天壤之别。

这意味着,如果我们今天正处于“Jeff Han”的阶段,那我们离“iPhone一代”已经不远了。然后,在十年左右的时间里,增强现实可能会演变成跟智能手机那样无处不在的大众产品。

AR的第一阶梯是谷歌眼镜:漂浮的图像会呈现在你的面前,但这款设备并没有以任何方式与世界相连。事实上,谷歌眼镜在概念上与智能手表非常相似,不同的是前者需要你抬头向右看,后者则要求你低头往左看。谷歌眼镜带给你一个新屏幕,但里面的内容跟前方的现实世界似乎没有任何关联。然而,借助更先进的技术,我们可以扩展这一点,使用户的整个视野都变成显示窗口,并让3D对象叠加在现实空间之中。

然而,对于“真正的AR”或是“混合现实”,设备将能够开始感知你的周围环境,同时可以把数字对象叠加在现实世界中,其逼真程度仿佛就像现实与数字融合在了一起。跟谷歌眼镜不同,头显会对周围环境进行3D绘图,并始终追踪你的头部位置。这样对于墙壁上的“虚拟电视”,无论你如何走动,这台电视仍然可以固定在同一位置。或者你可以将《我的世界》投射在桌面上,然后用双手来构建各种山谷和城堡。另外,所有佩戴相同眼镜的用户将能够看到同样的景象。你可以将墙壁或书桌变成一块显示屏,然后整支团队都可以一同观看;或者你可以与朋友或家人一起玩《我的世界》,共同享受创造的乐趣;或者一个小小的机器人可以藏身于沙发后面,然后你与你的孩子一起玩躲猫猫游戏。这是同一屏幕下的混合现实,或者是将你周围的世界变成一块无限的屏幕。

但这还不够,因为你只是在进行SLAM(即时定位与地图构建):设备可以映射房间的3D表面,但尚不能理解感知。现在,假设我在一个网络活动中见到你,然后你的LinkedIn个人资料卡会显示在你的头上;或者Salesforce会显示你是一位关键的目标客户;又或者是Truecaller会提示说,你只是想向我推销保险并建议我远离你;还可以是像《黑镜》那样,我们可以屏蔽对方。也就是说,“眼镜”中的图像传感器集群不仅只是会映射我周围的对象,而且还能感知它们。这才是真正的增强现实,不仅只是在展示一个平行世界,而且两者融为一体,数字世界成为现实世界的一部分。你的眼镜可以显示你在智能手机或2000英寸屏幕上看到的内容,但也可以切换成现实世界的视角,同时予以更改。所以,一方面,你可以通过将一切都成为一块屏幕来丰富(或污染)整个世界;但另一方面,这还可以让你将最细微的信息或变化叠加在世界中。如果今天人们能够安装一个将“难以捉摸的人”替换成“千禧一代”的Chrome扩展程序,那MR扩展又可以改变什么?让你的老板“口吐彩虹”怎么样?

不过,如果这种眼镜的体积足够小,你会一整天都佩戴眼镜吗?如果不是,许多应用将不会起任何作用。你或许会常备智能手表/智能手机以及智能眼镜,前者是“始终在线”的设备,后者只有在正确的情景下才会拿出来使用。

这涉及到一个相关的问题:AR和VR会合并吗?这绝对有可能,两者都涉及数字影像,同时也面临着类似的工程挑战。在一台设备中整合两种功能的困难在于,会将用户沉浸在另一个世界中的VR需要眼镜完全密封,而AR则不需要。AR会把数字影像叠加在现实世界中,这意味着用户需要感知到现实世界,而VR希望的是一块黑色屏幕。在戴上AR眼镜后,你可以看到对方的眼睛。或许10年或20年后许多事情都会成为可能,但现在VR和AR似乎是两种不同的技术。在20世纪90年代后期,我们讨论了“移动互联网”设备是否需要使用单独的无线电单元和屏幕,耳机,键盘,或者具有键盘和屏幕的翻盖。我们一直都在探索,直到2007年(或更晚)才在同一块玻璃上解决所有这些问题。相信VR和AR也需要一段时间的发展。

然后,你该如何控制没有实体存在的数字影像,又该如何与之交互呢?典型的VR控制器可以吗?手部追踪足够好吗?智能手机的多点触控意味着我们拥有直接的物理交互,所以我们可以在屏幕上触摸我们想要的东西,但我们可以“触摸”空中悬停的AR对象吗?这会是一个优秀的“全天”界面模式吗?我们的应该使用语音进行交互吗?但这又会带来多少限制呢(即便是最完美的语音识别,你能想象完全通过话语来控制手机或PC吗)?或者眼动追踪是关键,但如果眼镜能够实现眼动追踪,你会选择通过视线来进行选择和确定吗?当然,智能手机和电脑也正面临这些问题。答案并不明确,而问题也不明确。

但在我看来,你越认为AR只是将对象和数据呈现在周围的世界中,这越像是一个AI问题。我在行走中的时候应该看到什么呢? LinkedIn还是Tinder?我又该在什么时候查看新消息呢,系统需要即时向我显示呢,还是说晚一点呢?我站在餐厅外面的时候是否应该说“嘿,眼镜,这家餐厅好吗?”还是说设备的操作系统会自动进行提醒呢?谷歌、苹果、微软和Magic Leap或许都有不同的哲学态度,但对我来说,如果你希望其工作有效率,那许多这些事情都需要实现自动操作,变成人工智能。著名计算机程序员埃里克·史蒂文·雷蒙德曾说过,如果计算机能够自行处理,那它永远都不应该向用户请示。如果一台计算机能够看到我们所看到的一切,知道我们所知道的一切,那它应该要剥除我们今天认为需要手动解决的一层层问题。所以,当我们从桌面PC的Windows/键盘/鼠标的UI模型发展至智能手机的触摸和直接交互时,一层层的问题已经被消除。一台智能手机不会再向你请示当前的位置是哪里,你的密码是什么(通过指纹识别)…AR应该朝着相同的方向发展:不仅仅是将智能手机应用程序呈现在你面前的小方窗里。一个由AI主导的无形用户界面将会再次改变一切。

与此同时,AR眼镜越是试图了解你周围的世界(包括你),它们得到的信息就越多。然后设备会根据情景、用例和应用模型而将数据发送到各种不同的云服务。这是一张脸吗?你正在与之进行对话吗?马上向Salesforce、LinkedIn,、TrueCaller、Facebook和Tinder发送数据。一双鞋子?马上发送至Pinterest、亚马逊和NET-A-PORTER。又或者把一切都发送给谷歌。如果大家在会议期间感到乏味,你会记录在Success Factors吗?这显然也会带来一些非常明显的隐私和安全问题。如果自动驾驶汽车一直在捕获高清3D 360度视频,一座充满这种机器的城市将成为最终的全景监狱。如果所有人都在佩戴AR眼镜,那又会发生什么事情呢?你的行踪随时都会被记录,你将无处可逃。假如你被黑客攻击又该怎么办呢?如果联网家庭被黑客攻击,你只会经历空调乱开、冰箱乱关这样的“闹鬼现象”。但如果AR眼镜被黑,你将会陷入无尽的幻觉之中。

最后,一个相当重要的问题是,有多少人会拥有这么一款设备呢?AR会成为像智能手机的一部分吗(如智能手机)?还是说,即便是巴西和印度尼西亚的乡村小镇也会有商店销售50美元的“Made in China”AR眼镜呢?当然,一切都为时尚早。但是,早在20世纪90年代末到20世纪初就出现了是否人人都会拥有移动数据设备这样的讨论。事后来看,这就像在争论是否人人都会拥有电脑,抑或是仍部分人会坚持使用文字处理器。PC和智能手机先后成为了唯一的通用设备时(目前拥有手机用户为50亿,其中25.3亿人拥有智能手机)。那在未来,是否大多数人都仍将坚持使用智能手机,而部分人(100万?500万?10亿?)则将眼镜作为配件呢?或者是,AR眼镜将成为新的通用产品呢?这个答案似乎涉及大量的想象,而不是分析。但如果是这样,那在1995年宣称“未来地球上所有人都将拥有一台手机”不也是一样吗?