Meta分享:AR语言学习应用Spatial Lingo如何融合MR与AI技术

AR语言学习应用

(映维网Nweon 2026年01月23日)Meta早前曾为Quest 3发布了一款开源语言学习应用《Spatial Lingo》,融合了混合现实透视功能与AI驱动的物体识别技术。现在,团队从技术角度撰文分享了它是如何MR与AI技术:

如果日常环境能教你一门新语言会怎样?

通过开源应用《Spatial Lingo》,日常物品将以增强现实形式,在你选择的英语或西班牙语中标注出来,令新语言练习变得身临其境且乐趣横生。下面将介绍这个开源Unity项目如何将透视功能、人工智能与混合现实用户界面结合(以及如何将其扩展到自己的项目中)。

什么是空间语言?

《Spatial Lingo》是一款开源混合现实应用,它通过在你周围的世界中增添你所选语言的词汇,重塑了语言练习方式。《Spatial Lingo》利用透视摄像头API和多种AI技术,为将相关功能融入你自己的体验提供了良好基础。

用户无需通过列表记忆词汇,而是通过探索真实环境来学习新单词——你每天看到的物体会即时翻译并高亮显示,使学习过程直观且难忘。无论你在家、在办公室,还是在户外,《Spatial Lingo》都将你周围的环境变成了一个互动教室。应用中活泼的3D伙伴乐乐会全程引导你,给予鼓励,让学习感觉不像一项任务,更像一场冒险。

《Spatial Lingo》是如何构建的

《Spatial Lingo》是透视摄像头API与多种AI技术在Meta Quest平台上结合所能实现功能的一个绝佳范例。

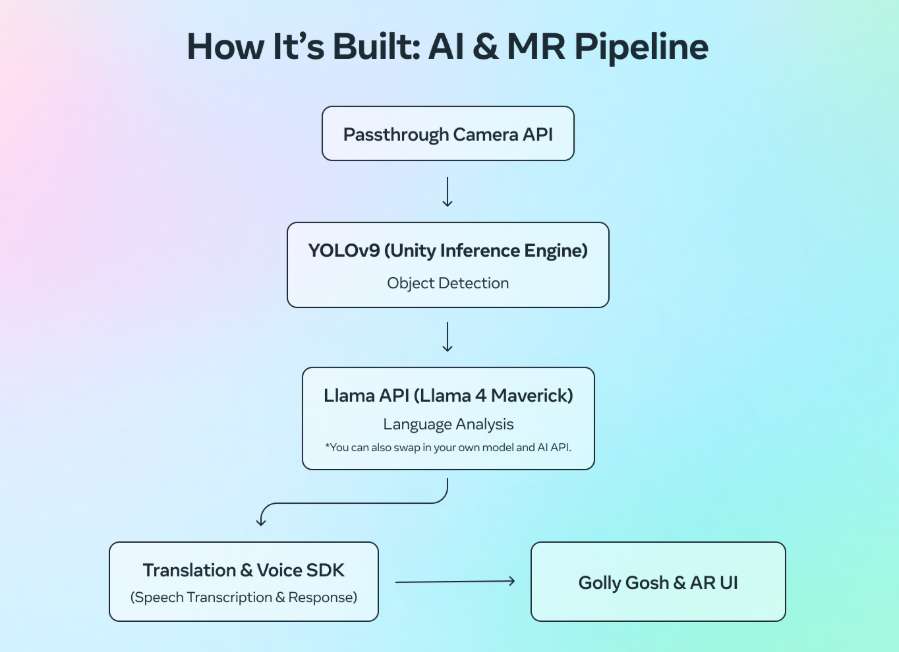

实时场景理解:利用透视摄像头API,《Spatial Lingo》能够看到玩家物理空间周围的景象。应用通过YOLOv9模型,借助Unity推理引擎(又称Sentis)分析Quest摄像头的图像,准确识别玩家周围的常见物体。一旦物体被YOLO识别,其图像会被裁剪并发送到Llama API。API使用Llama 4 Maverick分析物体,以获取基于该特定物体的准确名词、形容词和动词。这一功能通过高亮显示用户眼前可见并可触摸的物体,提供了一种感觉专为用户量身定制的动态体验。

语言理解:默认情况下,空间语言使用Llama 4 Maverick(通过Llama API)将检测到的物体名称翻译成西班牙语,并在混合现实中呈现。你可以在GitHub的开源项目中替换为自己的模型和AI API进行转译。当提示玩家说话时,应用使用Voice SDK捕捉并转录其语音输入。转录文本随后被发送给Llama 4 Maverick,由其检查玩家是否正确使用了目标词汇——细至动词变位和基本句子结构。乐乐的对话同样由Llama 4 Maverick生成(同样通过Llama API访问),这使其能够根据会话中的情况进行动态回应。生成文本回复后,Voice SDK会将其转换为语音,让乐乐能以鼓励和轻松的声音作出回应。

上方的流程图展示了空间语言的处理流程。

体验《Spatial Lingo》并探索代码

《Spatial Lingo》是开源的,开发者可以尝试、贡献,并基于成果进行构建。

下载应用(仅限美国):https://www.meta.com/en-gb/experiences/spatial-lingo-language-practice/24846121391731831/

探索代码:https://github.com/oculus-samples/Unity-SpatialLingo

Meta表示:“《Spatial Lingo》为利用AI和透视功能构建混合现实应用提供了实用的蓝图。立即深入了解,体验应用获取灵感,查看源代码作为范例,甚至克隆项目并在此基础上构建新的应用。”