苹果SHARP模型:一秒内将2D照片转换为逼真3D场景

图像质量误差降低了25-43%

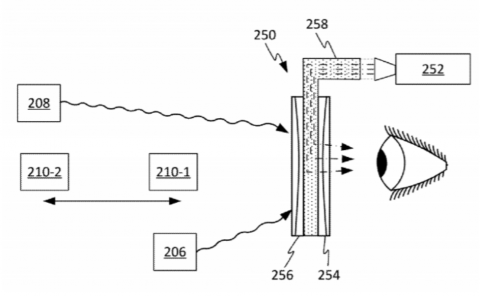

(映维网Nweon 2025年12月31日)苹果日前发布的开源模型SHARP能够在不到一秒的时间内,从单张2D照片生成照片级逼真的3D场景表示。这种技术能力将对AR/VR领域产生积极的影响。

据介绍,SHARP能够回归(一个)描绘场景的3D高斯表示参数。本质上,模型能够通过标准GPU的神经网络生成场景的3D表示。生成的3D高斯表示可以实时渲染,为邻近视角生成高分辨率、逼真的图像。表示具有度量单位,支持绝对比例,所以能支持带度量的camera运动。

模型解决了视图合成中的一个关键挑战。传统的3D高斯飞溅方法需要从不同视角拍摄数十或数百张图像。相比之下,SHARP能够在单一处理步骤中,仅从一张照片生成完整的3D高斯场景表示。

苹果表示,实验结果表明,SHARP在多个数据集上超越了之前的模型,将图像质量误差降低了25-43%,同时速度显著加快。这家公司进一步指出,模型在多个数据集上树立了新的技术水平。

模型生成. ply文件格式的3D高斯飞溅,与各种公开的3D高斯飞溅渲染器兼容。SHARP同时遵循OpenCV坐标惯例。其中,所述系统在标准GPU上能以每秒超过100帧的速度渲染3D表示,支持来自邻近视点的高分辨率视图。另外,用户可以渲染带有camera轨迹的视频,不过目前这需要CUDA GPU。

......(全文 485 字,剩余 49 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限