上海交大与腾讯等提出XR视线追踪不确定性感知眼部分割方法

眼部分割

(映维网Nweon 2025年12月26日)在增强现实与虚拟现实设备日益普及的今天,精准的视线追踪技术已成为实现自然、流畅人机交互的核心。而视线追踪的准确性,又在很大程度上依赖于底层视觉技术——眼部分割的精度。但在实际应用中,快速眼球运动导致的运动模糊、眼睑的天然遮挡,以及不同用户、不同设备配置带来的训练与测试数据之间的领域差异,这三大难题一直困扰着现有的眼部分割模型,导致其在复杂场景下性能急剧下降。

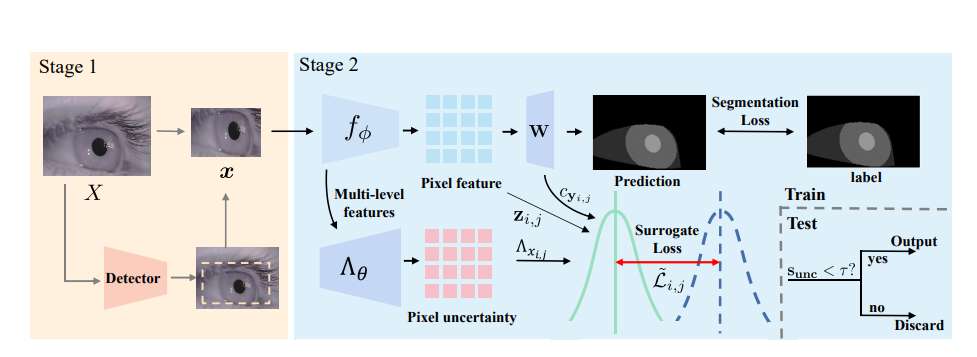

面对这一行业瓶颈,上海交通大学,腾讯,新加坡国立大学,清华大学,华东师范大学团队联合提出了EyeSeg,其核心创新在于将 “不确定性感知” 深度融入眼部分割流程中,使模型不仅能输出分割结果,还能“自知”其预测的可靠程度,从而在面临模糊、遮挡和未知场景时,表现出前所未有的鲁棒性。

EyeSeg的设计灵感源于人类的认知行为:当信息模糊不清时,人们会本能地意识到判断的不确定性,从而采取更审慎的策略。为了实现类似的能力,研究团队首先通过一个精心设计的眼部检测模块对输入图像进行预处理。该模块基于轻量化的YOLOv3架构,能够快速而准确地定位并裁剪出只包含眼睛的图像区域(Patch)。

......(全文 1648 字,剩余 1216 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限