索尼研发基于头戴摄像头的虚拟现实化身生成技术

为虚拟现实通信领域带来了革命性突破

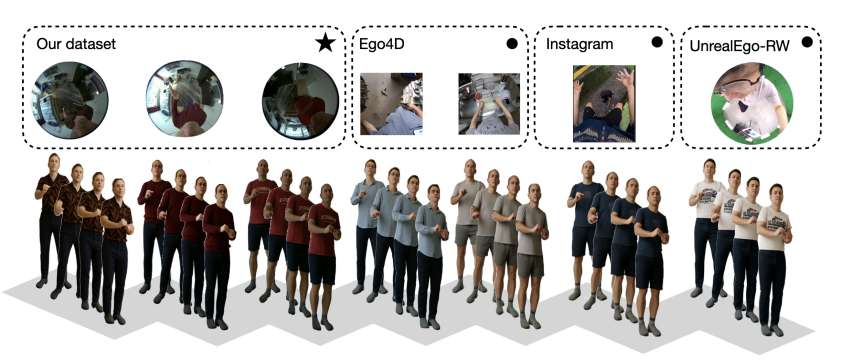

(映维网Nweon 2025年12月25日)理想的数字远程呈现体验需要精确地复制一个人的身体、服装和动作。为了捕获相关动作并将其转移到虚拟现实中,可以采用自中心(第一人称)的视角,这使得无需前视摄像头即可使用便携式且具有成本效益的设备。然而,这带来了诸如闭塞和扭曲的身体比例等挑战。

受SiTH和MagicMan等从正面图像进行360度重建的方法的启发,索尼团队引入了一个管道,使用ControlNet和稳定扩散主干从遮挡的自上而下图像生成逼真的正面视图。团队的目标是将单个自上而下的以自中心的图像转换为现实的正面表示,并将其输入到图像-运动模型中。这使得从最小的输入生成的化身运动,铺平了道路,更易于访问和通用的远程呈现系统。

这项技术实现了仅凭单个头戴摄像头拍摄的俯视角图像,就能生成具备细致服装纹理和完整身体结构的可动画数字化身,队虚拟现实通信领域具有重要意义。

......(全文 2494 字,剩余 2139 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限