堪萨斯大学等机构提出毫米波多用户VR系统360度视频流资源分配方案

研究了用于360度视频流的多任务边缘用户通信-计算资源分配

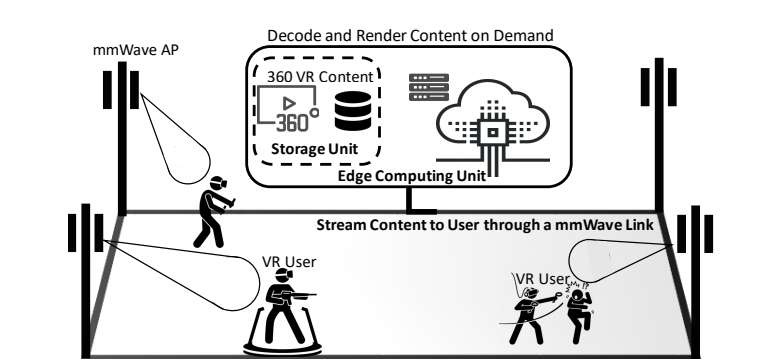

(映维网Nweon 2025年09月08日)在一项研究中,堪萨斯大学和新泽西理工学院团队在一个支持边缘计算的毫米波多用户虚拟现实系统中,研究了用于360度视频流的多任务边缘用户通信-计算资源分配。为了平衡其中产生的通信与计算权衡,他们构建了一个视频质量最大化问题,整合了相互依赖的多任务/多用户动作空间以及卡顿时间/质量变化约束。

研究人员为多任务码率自适应和计算分配构建了一个深度强化学习框架来解决目标问题。所提出解决方案不依赖于关于环境的先验知识,仅使用先前的视频流统计数据(例如吞吐量、解码时间和传输延迟)和内容信息,在在线观察流媒体性能的同时调整分配的视屏码率和计算分配。

另外,为了捕获环境中的任务相互依赖性,利用神经网络级联将所提出MTRC方法扩展为两个新颖的变体,分别称为R1C2和C1R2。研究人员使用真实的毫米波网络轨迹和360度视频数据集训练所有三种方法,以评估它们在期望体验质量、视口峰值信噪比、卡顿时间和质量变化方面的性能。结果表明,所提出方法优于最先进的码率自适应算法,其中C1R2表现最佳,实现了5.21~6.06 dB的PSNR增益、2.18~2.70倍的卡顿时间减少以及4.14~4.50 dB的质量变化减少。

......(全文 3902 字,剩余 3443 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限