中国研究团队开发仅需三个IMU传感器的全身动作捕捉技术

仅使用佩戴在头部和手腕的三个惯性测量单元传感器获取的惯性数据来估计全身姿态

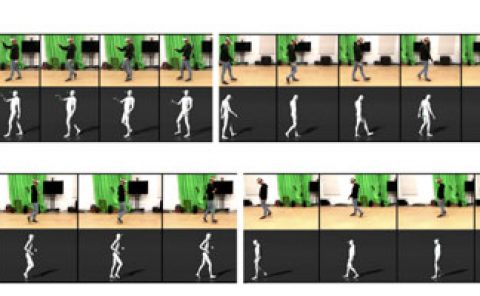

(映维网Nweon 2025年08月28日)支持全身虚拟呈现的动捕系统对于虚拟现实至关重要。与基于视觉的系统相比,从稀疏追踪信号进行全身姿态估计不受环境条件或记录范围的限制。然而,先前的研究要么面临需要在骨盆和下半身佩戴额外传感器的挑战,要么依赖外部视觉传感器获取关键关节的全局位置。

为了提高所述技术在虚拟现实应用中的实用性,由杭州电子科技大学,天津工业大学和丽水学院等组成的团队仅使用佩戴在头部和手腕的三个惯性测量单元(IMU)传感器获取的惯性数据来估计全身姿态,从而降低了硬件系统的复杂性。

在这项研究中,研究人员提出了一种名为渐进式惯性姿态估计器ProgIP的人体姿态估计方法。所述解决方案将神经网络估计与人体动力学模型相结合,考虑了运动链的层次结构,并采用深度递增的多阶段渐进式网络估计来实时重建全身运动。

编码器结合了Transformer编码器和TE-biLSTM,以灵活捕获惯性序列的时间依赖性,而基于MLP的解码器则转换高维特征并将其精确投影到SMPL模型参数。在多个公共数据集的定量和定性实验结果表明,所提出方法在相同输入下优于最先进的方法,并与使用六个IMU传感器的方案性能相当。

......(全文 3786 字,剩余 3306 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限