俄罗斯团队研发HapticVLM多模态触觉系统,实现84.7%材料识别准确率

多模态系统

(映维网Nweon 2025年08月22日)在一项研究中,俄罗斯斯科尔科沃科学技术研究院团队介绍了一种新颖的多模态系统HapticVLM。它将视觉语言推理与深度卷积网络相结合,以实现实时触觉反馈。HapticVLM利用基于ConvNeXt的材料识别模块生成鲁棒的视觉嵌入,以准确识别物体材料。同时,采用先进的视觉语言模型(Qwen2-VL-2B-Instruct)根据环境线索推断环境温度。

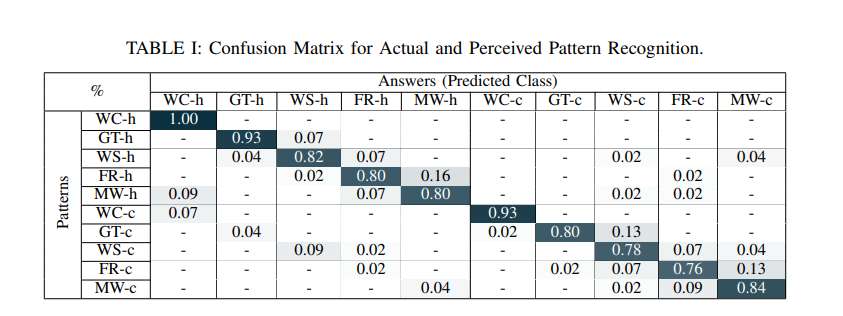

系统通过扬声器提供振动触觉反馈,并通过帕尔贴模块传递温度线索,从而合成了触觉感受,弥合了视觉感知与触觉体验之间的鸿沟。实验评估表明,系统在五种不同的听觉-触觉模式平均识别准确率达到84.67%。在15种场景下,温度估计准确率达到86.7%。

当然,团队坦诚,当前研究存在一定的限制,未来工作将着重于扩展触觉模式范围并增加用户研究,以进一步完善和验证系统性能。总体而言,HapticVLM向情境感知、多模态触觉交互迈出了重要一步,在虚拟现实等领域具有潜在应用价值。

......(全文 2766 字,剩余 2427 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限