NeRF技术五年发展梳理综述:从神经辐射场到3D视觉应用的全面演进

研究人员对过去五年(2020-2025)的NeRF论文进行了全面调查

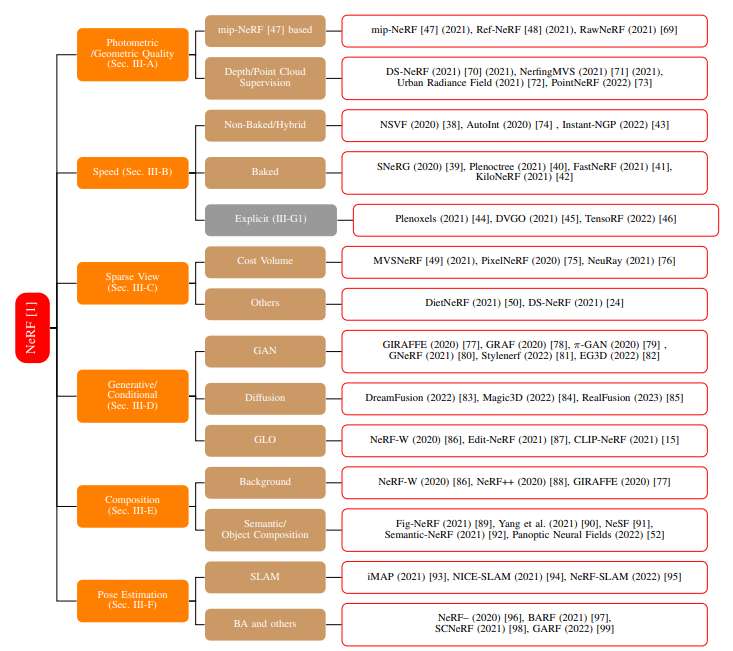

(映维网Nweon 2025年08月19日)2020年3月,神经辐射场NeRF的出现彻底改变了计算机视觉,允许隐式的、基于神经网络的场景表示和新颖的视图合成。如今,NeRF模型已在虚拟现实/增强现实等领域得到了广泛的应用。在一份名为《NeRF: Neural Radiance Field in 3D Vision: A Comprehensive Review》综述论文中,研究人员对过去五年(2020-2025)的NeRF论文进行了全面调查。

团队介绍了NeRF的理论及其通过可微体渲染的训练,同时对经典NeRF、隐式和混合神经表示以及神经场模型的性能和速度进行了基准比较,并概述了关键数据集:

神经辐射场(Neural Radiance Fields/NeRF) 使用可微分体渲染来学习一种隐式的神经场景表示。它使用多层感知器MLP来将3D场景的几何形状和光照作为神经场存储起来。这种学习到的表示随后可用于从用户指定的、新颖的视角生成场景的2D图像。Mildenhall等人于ECCV 2020首次提出了NeRF。自那以后,它在视觉质量方面达到了最先进水平,产生了令人印象深刻的演示,并启发了一系列后续工作。从2020年起,NeRF模型及后续基于神经场的体渲染模型已在照片编辑、3D表面提取、人体化身建模、大型/城市级3D表示与视图合成、以及3D物体生成等领域得到应用。

......(全文 30633 字,剩余 30210 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限